Systèmes sensoriels/Système Auditif

Introduction

Système auditif

Système vestibulaire

Système somatosensoriel

Système olfactif

Système gustatif

Introduction

[modifier | modifier le wikicode]Le système sensoriel pour le sens de l'ouïe est le système auditif. Ce wikibook couvre la physiologie du système auditif et son application à la prothèse neurosensorielle la plus réussie - les implants cochléaires. La physique et l'ingénierie de l'acoustique sont couvertes dans un wikibook séparé, Acoustics. Une excellente source d'images et d'animations est "Journey into the world of hearing" [1]..

La capacité à entendre n'est pas aussi répandue dans le règne animal que d'autres sens comme le toucher, le goût et l'odorat. Elle se limite principalement aux vertébrés et aux insectes. C'est chez les mammifères et les oiseaux que le sens de l'ouïe est le plus développé. Le tableau ci-dessous montre les plages de fréquence des humains et de certains animaux sélectionnés :

| Humains | 20-20'000 Hz |

|---|---|

| Baleines | 20-100'000 Hz |

| Chauve-souris | 1'500-100'000 Hz |

| Poissons | 20-3'000 Hz |

L'organe qui détecte le son est l'oreille. Il agit comme récepteur dans le processus de collecte de l'information acoustique et la fait passer à travers le système nerveux dans le cerveau. L'oreille comprend des structures à la fois pour le sens de l'ouïe et le sens de l'équilibre. Il ne joue pas seulement un rôle important en tant que partie intégrante du système auditif pour recevoir le son, mais aussi dans le sens de l'équilibre et de la position du corps.

|

|

|

|

Les humains ont une paire d'oreilles placées symétriquement des deux côtés de la tête, ce qui permet de localiser les sources sonores. Le cerveau extrait et traite différentes formes de données afin de localiser les sons, par exemple :

- la forme du spectre sonore au niveau de la membrane tympanique (tympan).

- la différence d'intensité sonore entre l'oreille gauche et l'oreille droite.

- la différence de temps d'arrivée entre l'oreille gauche et l'oreille droite.

- la différence de temps d'arrivée entre les réflexions de l'oreille elle-même (en d'autres termes : la forme du pavillon (motif de plis et de crêtes) capte les ondes sonores d'une manière qui aide à localiser la source sonore, en particulier sur l'axe vertical.

Les jeunes humains en bonne santé sont capables d'entendre des sons sur une gamme de fréquences allant de 20 Hz à 20 kHz. Nous sommes plus sensibles aux fréquences comprises entre 2 et 4 kHz, qui est la gamme de fréquences des mots parlés. La résolution en fréquence est de 0,2%, ce qui signifie que l'on peut distinguer entre une tonalité de 1000 Hz et 1002 Hz. Un son à 1 kHz peut être détecté s'il dévie la membrane tympanique (tympan) de moins de 1 angström, ce qui est inférieur au diamètre d'un atome d'hydrogène. Cette sensibilité extrême de l'oreille peut expliquer pourquoi elle contient le plus petit os qui existe à l'intérieur du corps humain : l'étrier. Il mesure de 0,25 à 0,33 cm de long et pèse entre 1,9 et 4,3 mg.

Anatomie du système auditif

[modifier | modifier le wikicode]

Le but de cette section est d'expliquer l'anatomie du système auditif de l'homme. Le chapitre illustre la composition des organes auditifs dans l'ordre dans lequel se déroule l'information acoustique au cours de la perception sonore.

Veuillez noter que les informations de base pour les "Composants d'organes sensoriels" peuvent également être trouvées sur la page "Système auditif" de Wikipedia, à l'exclusion de certains changements tels que les extensions et les spécifications faites dans cet article. (voir aussi : WikipediaSystème_auditif))

Le système auditif détecte les ondes sonores, c'est-à-dire les changements de pression atmosphérique, et convertit ces changements en signaux électriques. Ces signaux peuvent ensuite être traités, analysés et interprétés par le cerveau. Pour l'instant, concentrons-nous sur la structure et les composantes du système auditif. Le système auditif se compose principalement de deux parties :

- l'oreille et

- le système nerveux auditif (système auditif central)

L'oreille

[modifier | modifier le wikicode]L'oreille est l'organe où se produit le premier traitement du son et où se trouvent les récepteurs sensoriels. Il se compose de trois parties :

- Oreille externe

- Oreille moyenne

- Oreille interne

Oreille externe

[modifier | modifier le wikicode]Fonction : Collection de l'énergie sonore et amplification de la pression sonore.

Les plis du cartilage entourant le conduit auditif externe (méat auditif externe, méat acoustique externe) sont appelés le pavillon de l'oreille. C'est la partie visible de l'oreille. Les ondes sonores sont réfléchies et atténuées lorsqu'elles frappent le pavillon de l'oreille, et ces changements fournissent des informations supplémentaires qui aideront le cerveau à déterminer la direction d'où proviennent les sons. Les ondes sonores pénètrent dans le conduit auditif, un tube d'une simplicité trompeuse. Le conduit auditif amplifie les sons entre 3 et 12 kHz. Au fond du conduit auditif se trouve la membrane tympanique (tympan), qui marque le début de l'oreille moyenne.

Oreille moyenne

[modifier | modifier le wikicode]

Fonction : Transmission de l'énergie acoustique de l'air à la cochlée.

Les ondes sonores qui circulent dans le conduit auditif touchent la membrane tympanique (tympan). Cette information circule dans la cavité tympanique remplie d'air (cavité de l'oreille moyenne) via une série d'os : le malléus (marteau), l'enclume et l'étrier. Ces osselets agissent comme un levier et un télétype, convertissant les vibrations sonores du tympan à basse pression en vibrations sonores à haute pression au niveau d'une autre membrane plus petite appelée fenêtre ovale (ou elliptique), qui est l'une des deux ouvertures dans la cochlée de l'oreille interne. La deuxième ouverture est appelée fenêtre ronde. Il permet au fluide dans la cochlée de bouger.

Le malléus s'articule avec la membrane tympanique par l'intermédiaire du manubrium, tandis que l'étrier s'articule avec la fenêtre ovale par l'intermédiaire de son repose-pied. Une pression plus élevée est nécessaire parce que l'oreille interne au-delà de la fenêtre ovale contient du liquide plutôt que de l'air. Le son n'est pas amplifié uniformément sur toute la chaîne ossiculaire. Le réflexe stapédius des muscles de l'oreille moyenne aide à protéger l'oreille interne des dommages.

L'oreille moyenne contient encore l'information sonore sous forme d'onde; elle est convertie en impulsions nerveuses dans la cochlée.

Oreille interne

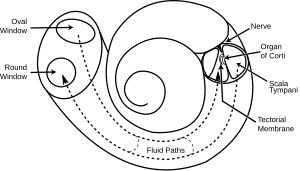

[modifier | modifier le wikicode]| Schéma de structure de la cochlée | Coupe transversale de la cochlée |

|---|---|

|

|

Fonction : Transformation d'ondes mécaniques (son) en signaux électriques (signaux neuronaux).

L'oreille interne se compose de la cochlée et de plusieurs structures non auditives. La cochlée est une partie en forme d'escargot de l'oreille interne. Il comporte trois sections remplies de liquide : scala tympani (galerie inférieure), scala media (galerie centrale, canal cochléaire) et scala vestibuli (galerie supérieure). La cochlée supporte une onde fluide entraînée par la pression à travers la membrane basilaire séparant deux des sections (scala tympani et scala media). La membrane basilaire mesure environ 3 cm de long et de 0,5 à 0,04 mm de large. La membrane de Reissner (membrane vestibulaire) sépare les scala media et les scala vestibuli.

Il est frappant de constater qu'une section, le scala media, contient un fluide extracellulaire dont la composition est similaire à celle de l'endolymphe, que l'on trouve habituellement à l'intérieur des cellules. L'organe de Corti est situé dans ce conduit et transforme les ondes mécaniques en signaux électriques dans les neurones. Les deux autres sections, scala tympani et scala vestibuli, sont situées dans le labyrinthe osseux qui est rempli d'un fluide appelé périlymph. La différence chimique entre les deux fluides endolymphe (dans les scala media) et périlymphe (dans les scala tympani et scala vestibuli) est importante pour la fonction de l'oreille interne.

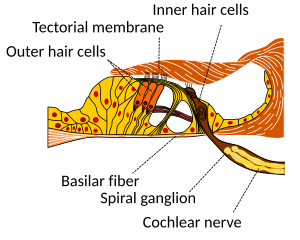

Organe de Corti

[modifier | modifier le wikicode]L'organe de Corti forme un ruban d'épithélium sensoriel qui descend le long de toute la cochlée. Les cellules ciliées de l'organe de Corti transforment les ondes fluides en signaux nerveux. Le voyage d'un milliard de nerfs commence par cette première étape; à partir de là, un traitement ultérieur mène à une série de réactions et de sensations auditives.

Transition de l'oreille au système nerveux auditif

[modifier | modifier le wikicode]

Cellules ciliées

[modifier | modifier le wikicode]Les cellules ciliées sont des cellules cylindriques, chacune avec un faisceau de 100-200 cils spécialisés au sommet, d'où leur nom. Ces cils sont les mécanocapteurs de l'ouïe. Les plus courtes sont appelées stéréocilia, et la plus longue à l'extrémité de chaque faisceau de cellules ciliées kinocilium. L'emplacement du kinocilium détermine la direction, c'est-à-dire la direction de déviation induisant l'excitation maximale des cellules ciliées. La membrane tectorielle, qui se déplace d'avant en arrière à chaque cycle de sons, incline les cils et permet au courant électrique d'entrer dans la cellule cilaire.

La fonction des cellules ciliées n'est pas complètement établie jusqu'à présent. Actuellement, la connaissance de la fonction des cellules ciliées permet de remplacer les cellules par des implants cochléaires en cas de perte auditive. Cependant, d'autres recherches sur le fonctionnement des cellules ciliées pourraient un jour ou l'autre permettre de réparer les cellules. Le modèle actuel est que les cils sont attachés les uns aux autres par des "liens de pointe", des structures qui relient les pointes d'un cil à l'autre. En s'étirant et en comprimant, les liens de pointe ouvrent alors un canal ionique et produisent le potentiel récepteur dans la cellule ciliée. Il est à noter qu'une déviation de 100 nanomètres permet déjà d'obtenir 90% du plein potentiel récepteur.

Neurones

[modifier | modifier le wikicode]Le système nerveux fait la distinction entre les fibres nerveuses qui transportent l'information vers le système nerveux central et les fibres nerveuses qui transportent l'information loin de celui-ci : Les neurones afférents (également les neurones sensoriels ou récepteurs) transportent les impulsions nerveuses des récepteurs (organes sensoriels) vers le système nerveux central. Les neurones efférents (également les neurones moteurs ou effecteurs) transportent les impulsions nerveuses du système nerveux central vers des effecteurs tels que les muscles ou les glandes (ainsi que les cellules ciliées de l'oreille interne).

Les neurones afférents innervent les cellules ciliées cochléaires internes, au niveau des synapses, où le neurotransmetteur glutamate communique les signaux des cellules ciliées aux dendrites des neurones auditifs primaires.

Il y a beaucoup moins de cellules ciliées internes dans la cochlée que dans les fibres nerveuses afférentes. Les dendrites neurales appartiennent aux neurones du nerf auditif, qui à son tour rejoint le nerf vestibulaire pour former le nerf vestibulaire, ou nerf crânien numéro VIII'.

Les projections effectives du cerveau à la cochlée jouent également un rôle dans la perception du son. Des synapses efficaces se produisent sur les cellules ciliées externes et sur les dendrites afférentes (vers le cerveau) sous les cellules ciliées internes.

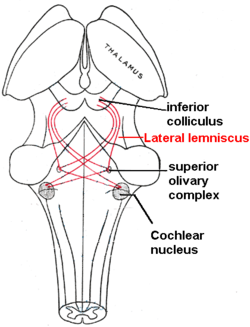

Système nerveux auditif

[modifier | modifier le wikicode]L'information sonore, maintenant réencodée sous forme de signaux électriques, voyage le long du nerf auditif (nerf acoustique, nerf vestibulocochlear, nerf crânien VIIIe), à travers des stations intermédiaires telles que les noyaux cochléaires et le complexe olivaire supérieur du tronc cérébral et le collicule inférieur du cerveau moyen, en cours de traitement à chaque point de cheminement. L'information finit par atteindre le thalamus, et de là, elle est relayée au cortex. Dans le cerveau humain, le cortex auditif primaire est situé dans le lobe temporal.

Cortex auditif primaire

[modifier | modifier le wikicode]Le cortex auditif primaire est la première région du cortex cérébral à recevoir un apport auditif.

La perception du son est associée au gyrus temporal supérieur postérieur droit (STG). Le gyrus temporal supérieur contient plusieurs structures importantes du cerveau, y compris les zones 41 et 42 de Brodmann, marquant l'emplacement du cortex auditif primaire, la région corticale responsable de la sensation des caractéristiques de base du son comme la hauteur et le rythme.

La zone d'association auditive est située dans le lobe temporal du cerveau, dans une zone appelée zone de Wernicke, ou zone 22. Cette zone, près du sulcus cérébral latéral, est une région importante pour le traitement des signaux acoustiques afin qu'ils puissent être distingués comme parole, musique ou bruit.

Traitement du Signal Auditif

[modifier | modifier le wikicode]Maintenant que l'anatomie du système auditif a été esquissée, ce sujet va plus loin dans les processus physiologiques qui ont lieu tout en percevant l'information acoustique et en convertissant cette information en données qui peuvent être manipulées par le cerveau. L'ouïe commence par des ondes de pression frappant le conduit auditif et est finalement perçue par le cerveau. Cette section détaille le processus de transformation des vibrations en perception.

Effet de la tête

[modifier | modifier le wikicode]Les ondes sonores d'une longueur d'onde plus courte que la tête produisent une ombre sonore sur l'oreille plus éloignée de la source sonore. Lorsque la longueur d'onde est plus courte que la tête, la diffraction du son conduit à des intensités sonores à peu près égales sur les deux oreilles.

Réception du son au pavillon de l'oreille

[modifier | modifier le wikicode]Le pavillon de pavillon recueille les ondes sonores dans l'air affectant le son venant de l'arrière et l'avant différemment avec sa forme ondulée. Les ondes sonores sont réfléchies et atténuées ou amplifiées. Ces changements aideront plus tard à la localisation sonore.

Dans le canal auditif externe, les sons entre 3 et 12 kHz - une plage cruciale pour la communication humaine - sont amplifiés. Il agit comme un résonateur qui amplifie les fréquences entrantes.

Conduction sonore vers la cochlée

[modifier | modifier le wikicode]Le son qui entre dans le pavillon sous forme d'ondes voyage le long du conduit auditif jusqu'au début de l'oreille moyenne marquée par la membrane tympanique (tympan). Comme l'oreille interne est remplie de fluide, l'oreille moyenne est une sorte de dispositif d'adaptation d'impédance afin de résoudre le problème de la réflexion de l'énergie sonore sur la transition de l'air au fluide. Par exemple, lors du passage de l'air à l'eau, 99,9% de l'énergie sonore entrante est réfléchie. Ceci peut être calculé à l'aide de :

.

avec Ir l'intensité du son réfléchi, Ii l'intensité du son entrant et Zk la résistance aux ondes des deux milieux (Zair = 414 kg m-2 s-1 et Zwater = 1.48*106 kg m-2 s-1). Trois facteurs qui contribuent à l'adaptation d'impédance sont :

- la différence de taille relative entre le tympan et la fenêtre ovale.

- l'effet de levier des osselets de l'oreille moyenne et de l'oreille moyenne

- la forme du tympan.

Les changements longitudinaux de la pression de l'air de l'onde sonore font vibrer la membrane tympanique qui, à son tour, fait osciller de façon synchrone les trois ossicules enchaînés malleus, incus et étrier. Ces os vibrent comme une unité, élevant l'énergie de la membrane tympanique à la fenêtre ovale. De plus, l'énergie du son est encore renforcée par la différence de surface entre la membrane et la plaque de pied de l'étrier. L'oreille moyenne agit comme un transformateur d'impédance en changeant l'énergie sonore collectée par la membrane tympanique en une plus grande force et moins d'excursion. Ce mécanisme facilite la transmission des ondes sonores dans l'air dans les vibrations du fluide dans la cochlée. La transformation résulte du mouvement d'entrée et de sortie en forme de piston par le repose-pied de l'étrier qui se trouve dans la fenêtre ovale. Ce mouvement effectué par le repose-pied met en mouvement le fluide dans la cochlée.

Par l'intermédiaire du muscle stapédius, le plus petit muscle du corps humain, l'oreille moyenne a une fonction de porte d'entrée : la contraction de ce muscle modifie l'impédance de l'oreille moyenne, protégeant ainsi l'oreille interne des dommages causés par des sons trop forts.

Analyse de fréquence dans la cochlée

[modifier | modifier le wikicode]Les trois compartiments remplis de liquide de la cochlée (scala vestibuli, scala media, scala tympani) sont séparés par la membrane basilaire et la membrane de Reissner. La fonction de la cochlée est de séparer les sons en fonction de leur spectre et de les transformer en un code neuronal.

Lorsque le repose-pied de l'étagère pénètre dans le périlymph des vestibules de la scala, la membrane de Reissner se plie dans le milieu de la scala. Cet allongement de la membrane de Reissner provoque le déplacement de l'endolymphe à l'intérieur de la scala media et induit un déplacement de la membrane basilaire.

La séparation des fréquences sonores dans la cochlée est due aux propriétés particulières de la membrane basilaire. Le fluide dans la cochlée vibre (en raison des mouvements d'entrée et de sortie de l'étrier), mettant la membrane en mouvement comme une onde en mouvement. La vague commence à la base et progresse vers l'apex de la cochlée. Les ondes transversales dans la membrane basilaire se propagent avec

:

avec μ le module de cisaillement et ρ la densité du matériau. Comme la largeur et la tension de la membrane basilaire changent, la vitesse des ondes se propageant le long de la membrane passe d'environ 100 m/s près de la fenêtre ovale à 10 m/s près de l'apex.

Il y a un point le long de la membrane basilaire où l'amplitude de l'onde diminue brusquement. A ce point, l'onde sonore dans le fluide cochléaire produit le déplacement maximal (amplitude maximale) de la membrane basilaire. La distance parcourue par l'onde avant d'arriver à ce point caractéristique dépend de la fréquence du son entrant. Par conséquent, chaque point de la membrane basilaire correspond à une valeur spécifique de la fréquence de stimulation. Un son basse fréquence parcourt une plus longue distance qu'un son haute fréquence avant d'atteindre son point caractéristique. Les fréquences sont mises à l'échelle le long de la membrane basilaire avec des fréquences élevées à la base et des fréquences basses à l'apex de la cochlée.

Transduction sensorielle dans la cochlée

[modifier | modifier le wikicode]La plupart des sons du quotidien sont composés de fréquences multiples. Le cerveau traite les fréquences distinctes, pas les sons complets. En raison de ses propriétés inhomogènes, la membrane basilaire effectue une approximation à une transformée de Fourier. Le son est ainsi divisé en ses différentes fréquences, et chaque cellule ciliée de la membrane correspond à une certaine fréquence. L'intensité sonore des fréquences est codée par le taux d'allumage de la fibre afférente correspondante. Ceci est dû à l'amplitude de l'onde progressive sur la membrane basilaire, qui dépend de l'intensité sonore du son entrant.

Les cellules sensorielles du système auditif, appelées cellules ciliées, sont situées le long de la membrane basilaire à l'intérieur de l'organe de Corti. Chaque organe de Corti contient environ 16 000 cellules de ce type, innervées par environ 30 000 fibres nerveuses afférentes. Il existe deux types de cellules ciliées distinctes sur le plan anatomique et fonctionnel : les cellules ciliées interne et externe. Le long de la membrane basilaire, ces deux types sont disposés en une rangée de cellules internes et trois à cinq rangées de cellules externes. La plus grande partie de l'innervation afférente provient des cellules ciliées internes, tandis que la plus grande partie de l'innervation efférente va aux cellules ciliées externes. Les cellules ciliées internes influencent le taux de décharge des fibres nerveuses auditives individuelles qui se connectent à ces cellules ciliées. Par conséquent, les cellules ciliées internes transfèrent les informations sonores aux centres nerveux auditifs supérieurs. Les cellules ciliées externes, en revanche, amplifient le mouvement de la membrane basilaire en injectant de l'énergie dans le mouvement de la membrane et en réduisant les pertes par frottement, mais elles ne contribuent pas à la transmission de l'information sonore. Le mouvement de la membrane basilaire fait dévier les stéréocilias (poils sur les cellules ciliées) et fait diminuer (dépolarisation) ou augmenter (hyperpolarisation) les potentiels intracellulaires des cellules ciliées, selon la direction de la déflexion. Lorsque les stéréocilias sont en position de repos, il y a un courant stable qui circule dans les canaux des cellules. Le mouvement des stéréocilias module donc le flux de courant autour de ce courant stable.

Examinons séparément les modes d'action des deux types de cellules ciliées :

- Cellules ciliées internes :

La déviation de la stéréocilie des cellules ciliées ouvre mécaniquement des canaux ioniques qui permettent aux petits ions potassium chargés positivement (K+) d'entrer dans la cellule et de la dépolariser. Contrairement à de nombreuses autres cellules électriquement actives, la cellule ciliée elle-même ne déclenche pas de potentiel d'action. Au lieu de cela, l'afflux d'ions positifs de l'endolymphe dans le milieu scala dépolarise la cellule, ce qui donne lieu à un potentiel récepteur. Ce potentiel récepteur ouvre des canaux calciques sous tension ; les ions calcium (Ca2+) entrent ensuite dans la cellule et déclenchent la libération de neurotransmetteurs à l'extrémité basale de la cellule. Les neurotransmetteurs diffusent à travers l'espace étroit entre la cellule ciliée et un terminal nerveux, où ils se lient aux récepteurs et déclenchent ainsi des potentiels d'action dans le nerf. De cette façon, le neurotransmetteur augmente la vitesse de tir dans le VIIIe nerf crânien et le signal sonore mécanique est converti en un signal nerveux électrique.

La repolarisation dans la cellule ciliée se fait d'une manière spéciale. Le périlymph dans Scala tympani a une très faible concentration d'ions positifs. Le gradient électrochimique fait circuler les ions positifs à travers les canaux vers le périlymph. (voir aussi : Wikipedia Cellule ciliée)

- Cellules ciliées externes :

Dans les cellules ciliées externes de l'homme, le potentiel récepteur déclenche des vibrations actives du corps cellulaire. Cette réponse mécanique aux signaux électriques est appelée électromobilité somatique et entraîne des oscillations dans la longueur de la cellule, qui se produisent à la fréquence du son entrant et fournissent une amplification mécanique en retour. Les cellules ciliées externes n'ont évolué que chez les mammifères. En l'absence de cellules ciliées externes, la sensibilité diminue d'environ 50 dB (en raison de pertes par frottement plus importantes dans la membrane basilaire, ce qui amortirait le mouvement de la membrane). Ils ont également amélioré la sélectivité des fréquences (discrimination de fréquence), ce qui est particulièrement bénéfique pour l'homme, car elle permet une parole et une musique sophistiquées. (voir aussi : Wikipedia Cellule ciliée)

Sans stimulation externe, les fibres nerveuses auditives déchargent des potentiels d'action dans une séquence temporelle aléatoire. Ce tir à temps aléatoire est appelé activité spontanée. Les taux de décharge spontanée des fibres varient de taux très lents à des taux allant jusqu'à 100 par seconde. Les fibres sont classées en trois groupes selon qu'elles tirent spontanément à des taux élevés, moyens ou faibles. Les fibres ayant des taux spontanés élevés (> 18 par seconde) ont tendance à être plus sensibles à la stimulation sonore que les autres fibres.

Voie auditive de l'influx nerveux

[modifier | modifier le wikicode]

Ainsi, dans les cellules ciliées internes, le signal sonore mécanique est finalement converti en signaux électriques nerveux. Les cellules ciliées internes sont reliées à des fibres nerveuses auditives dont les noyaux forment le ganglion en spirale. Dans le ganglion spiralé, les signaux électriques (pointes électriques, potentiels d'action) sont générés et transmis le long de la branche cochléaire du nerf auditif (VIIIe nerf crânien) au noyau cochléaire dans le tronc cérébral.

De là, l'information auditive est divisée en au moins deux flux :

- Noyau cochléaire central :

L'un des flux est le noyau cochléaire ventral qui est ensuite divisé en noyau cochléaire postéro-ventral (PVCN) et le noyau cochléaire antéro-ventral (AVCN). Les cellules du noyau cochléaire ventral se projettent dans une collection de noyaux appelée complexe olivaire supérieur.

Complexe olivaire supérieur : Localisation du son

[modifier | modifier le wikicode]Le complexe olivaire supérieur - une petite masse de substance grise - est censé être impliqué dans la localisation des sons dans le plan azimutal (c'est-à-dire leur degré à gauche ou à droite). Il y a deux indices majeurs pour la localisation sonore : Différences de niveau intra-auriculaire (ILD) et différences de temps inter-auriculaires (ITD). L'ILD mesure les différences d'intensité sonore entre les oreilles. Cela fonctionne pour les hautes fréquences (plus de 1,6 kHz), où la longueur d'onde est plus courte que la distance entre les oreilles, causant une ombre de tête - ce qui signifie que les sons à haute fréquence frappent l'oreille évitée avec une intensité plus faible. Les sons de basse fréquence ne projettent pas d'ombre, puisqu'ils s'enroulent autour de la tête. Cependant, comme la longueur d'onde est plus grande que la distance entre les oreilles, il y a une différence de phase entre les ondes sonores qui entrent dans les oreilles - la différence de synchronisation mesurée par le DTI. Cela fonctionne très précisément pour les fréquences inférieures à 800 Hz, où la distance de l'oreille est inférieure à la moitié de la longueur d'onde. La localisation du son dans le plan médian (avant, dessus, arrière, dessous) est facilitée par l'oreille externe, qui forme des filtres sélectifs de direction.

Là, les différences de temps et de volume de l'information sonore dans chaque oreille sont comparées. Les différences d'intensité sonore sont traitées dans les cellules du complexe olivaire supérieur latéral et les différences de temps (retards d'exécution) dans le complexe olivaire supérieur médial. Les humains peuvent détecter des différences de synchronisation entre l'oreille gauche et l'oreille droite jusqu'à 10 μs, ce qui correspond à une différence de localisation du son d'environ 1 degré. Cette comparaison des informations sonores des deux oreilles permet de déterminer la direction d'où provient le son. L'olive supérieure est le premier nœud où les signaux des deux oreilles se rejoignent et peuvent être comparés. Comme étape suivante, le complexe olivaire supérieur envoie l'information jusqu'au colliculus inférieur par l'intermédiaire d'un tractus d'axones appelé lemniscus latéral. La fonction du collicule inférieur est d'intégrer l'information avant de l'envoyer au thalamus et au cortex auditif. Il est intéressant de savoir que le colliculus supérieur à proximité montre une interaction de stimuli auditifs et visuels.

- Noyau cochléaire dorsal :

Le noyau cochléaire dorsal (DCN) analyse la qualité du son et projette directement via les lemnisucs latéraux vers le collicule inférieur.

Du collicule inférieur, les informations auditives du noyau cochléaire ventral et dorsal passent au noyau auditif du thalamus, qui est le noyau génial médian. Le noyau géniculé médial transfère l'information au cortex auditif primaire, la région du cerveau humain responsable du traitement de l'information auditive, située sur le lobe temporal. Le cortex auditif primaire est le premier relais impliqué dans la perception consciente du son.

Cortex auditif primaire et zones auditives d'ordre supérieur

[modifier | modifier le wikicode]Une information sonore qui atteint le cortex auditif primaire (zones 41 et 42 de Brodmann). Le cortex auditif primaire est le premier relais impliqué dans la perception consciente du son. Il est connu pour être tonotopiquement organisé et exécute les bases de l'audition : hauteur et volume. En fonction de la nature du son (parole, musique, bruit), est ensuite transmis à des zones auditives d'ordre supérieur. Les sons qui sont des mots sont traités par la zone de Wernicke (zone 22 de Brodmann). Ce domaine est impliqué dans la compréhension de la langue écrite et parlée (compréhension verbale). La production du son (expression verbale) est liée à la zone de Broca (zones 44 et 45 de Brodmann). Les muscles qui produisent le son nécessaire à la parole sont contractés par la zone faciale du cortex moteur qui sont des régions du cortex cérébral impliquées dans la planification, le contrôle et l'exécution des fonctions motrices volontaires.

Perception du timbre

[modifier | modifier le wikicode]Cette section passe en revue un sujet clé en neuroscience auditive : la perception du timbre. Une certaine compréhension de base du système auditif est présumée, de sorte que les lecteurs sont encouragés à lire d'abord les sections ci-dessus sur l' 'Anatomie du système auditif' et le 'Traitement du signal auditif'.

Introduction

[modifier | modifier le wikicode]Timbre est une perception subjective, évoquée par des sons qui ont une nature approximativement périodique. Pour de nombreux sons naturels, la périodicité d'un son est le principal déterminant du timbre. Pourtant, la relation entre un stimulus acoustique et le timbre est assez abstraite : en particulier, le timbre est assez robuste aux changements d'autres paramètres acoustiques tels que l'intensité sonore ou timbre spectral, qui peuvent tous deux modifier de manière significative les propriétés physiques d'une forme d'onde acoustique. Ceci est particulièrement évident dans les cas où des sons sans composantes spectrales partagées peuvent évoquer le même timbre, par exemple. Par conséquent, l'information relative à l'assiette longitudinale doit être extraite des repères spectraux et/ou temporels représentés sur plusieurs canaux de fréquences.

Les recherches sur le codage du timbre dans le système auditif se sont largement concentrées sur l'identification des processus neuronaux qui reflètent ces processus d'extraction, ou sur la recherche du " point final " d'un tel processus : une représentation explicite et robuste du timbre telle que perçue par l'auditeur. Les deux entreprises ont connu un certain succès, les preuves s'accumulant pour les " neurones sélectifs de la poix " dans des " zones de poix " putatives. Cependant, on peut se demander si l'activité de ces zones est réellement liée au timbre ou si elles présentent simplement une représentation sélective des paramètres liés au timbre. D'une part, la démonstration de l'activation de neurones ou de zones neurales spécifiques en réponse à de nombreux sons de pitch-evoking, souvent avec des variations substantielles dans leurs caractéristiques physiques, fournit des preuves corrélatives convaincantes que ces régions codent effectivement le pitch. D'autre part, il est difficile de démontrer la preuve causale que ces neurones représentent le timbre, ce qui nécessite probablement une combinaison d'approches d'enregistrement " in vivo " pour démontrer une correspondance de ces réponses aux jugements de hauteur (c.-à-d. ([wikipedia:Psychophysics|résponses psychophysical], plutôt que seulement la périodicité des stimulus), et une manipulation directe de l'activité dans ces cellules pour démontrer des biais prévisibles ou des altérations dans la perception du timbre.

En raison de la nature plutôt abstraite du timbre, nous n'entrerons pas immédiatement dans ce domaine de recherche active non encore résolu. Nous commençons plutôt notre discussion par les contreparties physiques les plus directes de la perception du timbre, c'est-à-dire la fréquence sonore (pour les sons purs) et, plus généralement, la périodicité des stimuli. Plus précisément, nous distinguerons et définirons plus concrètement les notions de périodicité et de timbre. Ensuite, nous exposerons brièvement les principaux mécanismes de calcul qui peuvent être mis en œuvre par le système auditif pour extraire ces informations relatives au timbre à partir de stimuli sonores. Par la suite, nous décrivons la représentation et le traitement des paramètres de hauteur dans le cochlée, le voie auditive ascendante sous-corticale], et, enfin, des résultats plus controversés dans[Systèmes sensoriels/Système auditif#Anatomie du système auditif|cortex auditif primaire] et au-delà, et évaluer les preuves de 'neurones de timbre' ou 'zones de timbre' dans ces régions corticales.

Périodicité et timbre

[modifier | modifier le wikicode]Le timbre est une propriété psychophysique émergente. L'importance et la 'hauteur' du timbre dépend de plusieurs facteurs, mais à l'intérieur d'une gamme spécifique de fréquences harmoniques et fondamentales, appelée " région d'existence ", l'importance de la hauteur du timbre est largement déterminée par la régularité de la répétition des segments sonores ; la hauteur du timbre par le taux de répétition, également appelée fréquence modulante. L'ensemble des sons capables d'évoquer la perception du timbre est diversifié et spectralement hétérogène. De nombreux stimuli différents - y compris les sons purs, les trains de clics, les bruits d'ondulation itérés, les sons modulés en amplitude, etc. - peuvent évoquer une perception de hauteur, tandis qu'un autre signal acoustique, même avec des caractéristiques physiques très similaires à de tels stimuli, peut ne pas évoquer la hauteur. La plupart des sons naturels de pitch-evoking sont des complexes harmoniques - des sons contenant un spectre de fréquences qui sont des multiples entiers de la fréquence fondamentale, F0. Une découverte importante dans la recherche sur le timbre est le phénomène de la 'fondamentale manquante' (voir ci-dessous) : dans une certaine gamme de fréquences, toute l'énergie spectrale à F0 peut être retirée d'un complexe harmonique, et évoquer encore une hauteur corrélée à F0 dans une oreille humaine [2]. Cette constatation semble généraliser à de nombreux systèmes auditifs non humains [3][4].

Le phénomène de la 'fondamentale manquante' est important pour deux raisons. Premièrement, il s'agit d'un point de référence important pour évaluer si des neurones ou des régions du cerveau sont spécialisés dans le traitement du timbre, car on peut s'attendre à ce que ces unités présentent une activité reflétant F0 (et donc le timbre), indépendamment de sa présence dans le son et d'autres paramètres acoustiques. De manière plus générale, un 'neurone de timbre' ou 'centre de timbre' devrait montrer une activité constante en réponse à tous les stimuli qui évoquent une perception particulière du timbre. Comme nous le verrons plus loin, cela a été à l'origine d'un certain désaccord sur l'identification des neurones ou zones. Deuxièmement, le fait que l'on puisse percevoir un timbre correspondant à F0 même en son absence dans le stimulus auditif fournit des preuves solides contre la mise en œuvre par le cerveau d'un mécanisme de 'sélection' de F0 pour déduire directement le timbre. le timbre doit plutôt être extraite de repères temporels ou spectraux (ou les deux) [5].

Mécanismes d'extraction du timbre : repères spectraux et temporels

[modifier | modifier le wikicode]

Ces deux indices (spectral et temporel) sont les bases de deux grandes classes de modèles d'extraction du timbre [5]. Les premières sont les méthodes du domaine temporel, qui utilisent des repères temporels pour évaluer si un son est constitué d'un segment répétitif et, le cas échéant, le taux de répétition. Une méthode couramment proposée est autocorrélation]. Une fonction d'autocorrélation consiste essentiellement à trouver les délais entre deux points d'échantillonnage qui donneront la corrélation maximale : par exemple, une onde sonore d'une fréquence de 100 Hz (ou période, T=10 ms) aurait une corrélation maximale si les échantillons sont prélevés à 10 ms d'intervalle. Pour une onde de 200 Hz, le retard donnant une corrélation maximale serait de 5 ms - mais aussi à 10 ms, 15 ms et ainsi de suite. Ainsi, si une telle fonction est exécutée sur toutes les fréquences composantes d'un complexe harmonique avec F0=100 Hz (et donc ayant des harmoniques à 200 Hz, 300 Hz, 400 Hz, et ainsi de suite), et que les intervalles de temps résultants donnant une corrélation maximale étaient additionnés, ils voteraient collectivement pour 10 ms - la périodicité du son. La deuxième classe de stratégies d'extraction de hauteur est celle des méthodes du domaine fréquentiel, où le timbre est extrait en analysant les spectres de fréquence d'un son pour calculer F0. Par exemple, les processus de " correspondance de modèle " - tels que le ‘harmonic sieve’ - proposent que le spectre de fréquence d'un son soit simplement adapté aux modèles harmoniques - la meilleure correspondance donne le bon F0[6].

Il y a des limites aux deux catégories d'explications. Les méthodes dans le domaine des fréquences exigent que les fréquences harmoniques soient résolues - c'est-à-dire que chaque harmonique soit représentée comme une bande de fréquences distincte (voir la figure de droite). Pourtant, les harmoniques d'ordre supérieur, qui ne sont pas résolues en raison de la largeur de bande plus large dans la représentation physiologique pour les fréquences plus élevées (conséquence de l'organisation logarithmique de la membrane basilaire), peuvent encore évoquer le timbre correspondant à F0. Les modèles temporels n'ont pas ce problème, puisqu'une fonction d'autocorrélation devrait toujours produire la même périodicité, que la fonction soit exécutée sur un ou plusieurs canaux de fréquence. Cependant, il est difficile d'attribuer les limites inférieures des fréquences de pitch-evoking à l'autocorrélation : des études psychophysiques démontrent que l'on peut percevoir le timbre à partir de complexes harmoniques avec des fondamentales manquantes aussi bas que 30Hz ; ceci correspond à un retard d'échantillonnage de plus de 33 ms - bien plus long que le retard de ~10 ms communément observé dans la signalisation neurale [5].

Une stratégie pour déterminer laquelle de ces deux stratégies est adoptée par le système auditif est l'utilisation d'harmoniques en phase alternée : présenter des harmoniques impaires en phase sinusoïdale, et même des harmoniques en phase cosinusoïdale. Comme cela n'affectera pas le contenu spectral du stimulus, aucun changement dans la perception du timbre ne devrait se produire si l'auditeur se fie principalement sur des repères spectraux. D'autre part, le taux de répétition de l'enveloppe temporelle doublera. Ainsi, si des repères d'enveloppe temporelle sont adoptés, le timbre perçue par les auditeurs pour les harmoniques de phase alternée sera d'une octave au-dessus (c.-à-d. le double de la fréquence) du timbre perçue pour les harmoniques toutes-cosinus avec la même composition spectrale. Des études psychophysiques ont étudié la sensibilité de la perception du timbre à de tels changements de phase sur différentes plages F0 et harmoniques, fournissant la preuve que les deux humains [7] et autres primates [8] adoptent une stratégie double : des signaux spectraux sont utilisés pour les harmoniques résolues d'ordre inférieur, tandis que des signaux d'enveloppe temporelle sont utilisés pour les harmoniques non résolues d'ordre supérieur.

Extraction du timbre dans la voie auditive ascendante

[modifier | modifier le wikicode]On a rapporté que la discrimination par la poix chez l'homme est inférieure à 1% [9]. Compte tenu de cette sensibilité élevée aux changements de hauteur et de la démonstration que des repères spectraux et temporels sont utilisés pour l'extraction du timbre, nous pouvons prédire que le système auditif représente à la fois la composition spectrale et la structure fine temporelle des stimuli acoustiques d'une manière très précise, jusqu'à ce que ces représentations soient finalement transmises explicitement la périodicité ou les neurones sélectifs de hauteur.

Les expériences électrophysiologiques ont identifié des réponses neuronales dans le système auditif ascendant qui sont cohérentes avec cette notion. A partir du niveau de la cochlée, les mouvements de la membrane basilaire (BM) cartographiée tonopiquement en réponse à des stimuli auditifs établissent un Place theory (hearing)] pour la composition de fréquence le long de l'axe BM. Ces représentations sont encore renforcées par un phase-locking des fibres nerveuses auditives (ANFs) aux composantes de fréquence auxquelles il répond. Ce mécanisme de représentation temporelle de la composition de la fréquence est encore amélioré de nombreuses façons, comme inhibition latérale à la cellule pileuse / ganglion spiral synapse [10], appuyant l'idée que cette représentation précise est essentielle pour le codage du timbre.

Ainsi, à ce stade, les pics temporels à verrouillage de phase des FNA sont probablement porteurs d'une représentation implicite de la périodicité. Ceci a été testé directement par Cariani et Delgutte[11]. En analysant la distribution des intervalles inter-spike de tous les ordres (ISI) dans les FNA des chats, ils ont montré que l'ISI le plus commun était la périodicité du stimulus, et que le rapport crête/moyenne de ces distributions augmentait pour les stimuli complexes évoquant des perceptions de hauteur plus saillantes. Sur la base de ces résultats, ces auteurs ont proposé l'" hypothèse de l'intervalle prédominant ", où un code commun de tous les ISI d'ordre " vote " pour la périodicité - bien que, bien sûr, ce résultat soit une conséquence inévitable des réponses à verrouillage de phase des FNA. En outre, il est prouvé que le code de lieu pour les composantes de fréquence est également critique. En croisant un stimulus basse fréquence avec une porteuse haute fréquence, Oxenham et al. ont transposé la structure temporelle fine de la sinusoïde basse fréquence à des régions de fréquence plus élevée le long de la BM.[12] Ceci a conduit à une altération significative des capacités de discrimination du timbre. Ainsi, le codage du lieu et le codage temporel représentent l'information relative à l'assiette longitudinale dans les FNA.

Le nerf auditif transporte l'information jusqu'au noyau cochléaire (CN). Ici, de nombreux types de cellules représentent l'information relative au timbre de terrain de différentes manières. Par exemple, de nombreuses cellules buissonnantes semblent avoir peu de différence dans les propriétés de mise à feu des fibres nerveuses auditives - l'information peut être transmise à des régions cérébrales d'ordre supérieur sans modification significative [5]. Selon Winter et ses collègues, les intervalles de pointe du premier ordre dans ces cellules correspondent à la périodicité en réponse à des stimuli de bruit ondulé itéré (IRN), ainsi qu'à des complexes harmoniques en phase cosinusine et en phase aléatoire, invariablement au niveau sonore [13]. Bien qu'il soit nécessaire de caractériser davantage les réponses de ces cellules à différents stimuli de tangage, il y a donc une certaine indication que l'extraction du tangage peut commencer dès le niveau du CN.

Dans le collicule inférieur (IC), il existe des preuves que le taux de réponse moyen des neurones est égal à la périodicité du stimulus [14]. Des études subséquentes comparant les réponses des neurones IC aux complexes harmoniques de même phase et de phase alternée suggèrent que ces cellules peuvent répondre à la périodicité du niveau d'énergie global (c.-à-d. l'enveloppe), plutôt qu'à la véritable fréquence de modulation, mais il n'est pas clair si cela s'applique seulement aux harmoniques non résolus (comme le prédisent les expériences psychophysiques) ou aussi aux harmoniques résolus [5]. Il reste beaucoup d'incertitude quant à la représentation de la périodicité dans le CI.

Codage du timbre dans le cortex auditif

[modifier | modifier le wikicode]Il y a donc une tendance à renforcer cette représentation de F0 dans l'ensemble du système auditif ascendant, bien que la nature précise de cette représentation demeure incertaine. Dans ces étapes sous-corticales de la voie auditive ascendante, cependant, il n'y a pas de preuve d'une représentation explicite qui code de façon constante l'information correspondant au timbre perçue. De telles représentations se produisent probablement dans les régions auditives " supérieures ", à partir du cortex auditif primaire.

En effet, des études de lésions ont démontré la nécessité d'un cortex auditif dans la perception du timbre. Bien entendu, une altération de la détection de la tonalité à la suite de lésions du cortex auditif peut simplement refléter un rôle de transmission passive pour le cortex : là où l'information sous-corticale doit " passer à travers " pour affecter le comportement. Pourtant, des études comme celle de Whitfield ont démontré que ce n'est probablement pas le cas : alors que les chats décoratifs pourraient être formés à nouveau (suite à une ablation duur cortex auditif) pour reconnaître des sons complexes composés de trois composantes de fréquence, les animaux ont sélectivement perdu la capacité de généraliser ces sons à d'autres complexes avec le même pitch[15]. En d'autres termes, si la composition harmonique peut influencer le comportement, les relations harmoniques (c'est-à-dire une queue de hauteur) ne le peuvent pas. Par exemple, l'animal lésé pourrait répondre correctement à un son pur à 100Hz, mais ne répondrait pas à un complexe harmonique composé de ses harmoniques harmoniques (à 200Hz, 300Hz, et ainsi de suite). Cela suggère fortement un rôle pour le cortex auditif dans la poursuite de l'extraction de l'information relative au timbre.

Les premières études MEG du cortex auditif primaire avaient suggéré que A1 contenait une carte de hauteur. Ceci était basé sur les résultats qu'un son pur et son complexe harmonique fondamental (MF) manquant évoquait l'excitation par stimulus (appelée N100m) au même endroit, alors que les fréquences des composantes du MF présentées isolément évoquaient des excitations dans différents endroits [16]. Pourtant, ces notions ont été surestimées par les résultats d'expériences utilisant des techniques à plus haute résolution spatiale : wikipedia:Local_field_potential|local field potential (LFP)]] et multi-unit_recording|multi-unit recording (MUA)] ont démontré que la cartographie A1 était tonotopique - c'est-à-dire, basée sur la meilleure fréquence des neurones (BF), plutôt que sur la meilleure 'timbre'[17]. Ces techniques démontrent toutefois l'émergence de mécanismes de codage distincts reflétant l'extraction de signaux temporels et spectraux : une représentation à verrouillage de phase du taux de répétition de l'enveloppe temporelle a été enregistrée dans les régions BF supérieures de la carte tonotopique, tandis que la structure harmonique du train de clics était représentée dans les régions BF inférieures [18] Ainsi, les repères pour l'extraction du brai peuvent être encore améliorés par cette étape.

Kadia et Wang ont décrit un exemple de substrat neuronal susceptible de faciliter une telle amélioration dans le cortex auditif primaire des ouistitis [19]. Environ 20 % des neurones ici pourraient être classés comme des unités " multicrêtes " : des neurones qui ont des zones de réponse en fréquence multiples, souvent en relation harmonique (voir figure, à droite). De plus, l'excitation de deux de ces pics spectraux a un effet synergique sur les réponses des neurones. Cela faciliterait donc l'extraction de tonalités harmoniquement liées dans le stimulus acoustique, permettant à ces neurones d'agir comme un " modèle harmonique " pour l'extraction de signaux spectraux. De plus, ces auteurs ont observé que dans la majorité des neurones à pic unique (c'est-à-dire des neurones avec un seul pic d'accord spectral à son FB), une tonalité secondaire pourrait avoir un effet modulatoire (facilitant ou inhibant) sur la réponse du neurone à son FB. Encore une fois, ces fréquences modulantes étaient souvent en relation harmonique avec le BF. Ces mécanismes de facilitation peuvent donc permettre l'extraction de certaines composantes harmoniques, tandis que le rejet d'autres combinaisons spectrales par modulation inhibitrice peut faciliter la désambiguïsation avec d'autres complexes harmoniques ou des complexes non harmoniques comme le bruit à large bande.

Cependant, étant donné que la tendance à améliorer F0 a été démontrée dans l'ensemble du système auditif sous-cortical, on pourrait s'attendre à devoir se rapprocher d'une représentation plus explicite du timbre dans le cortex. Les expériences de neuroimagerie ont exploré cette idée, capitalisant sur la qualité émergente du timbre : une méthode soustractive permet d'identifier les zones du cerveau qui montrent BOLD responses] en réponse à un stimulus de pitch-evoking, mais pas à un autre son ayant des propriétés spectrales très similaires, mais qui n'évoque pas la perception du timbre. De telles stratégies ont été utilisées par Patterson, Griffiths et collègues : en soustrayant le signal BOLD acquis pendant la présentation du bruit à large bande du signal acquis pendant la présentation de l'IRN, ils ont identifié une activation sélective du gyrus latéral (et, dans une certaine mesure, médial) de Heschl (HG) en réponse à cette dernière classe de sons de pitch-evoking [20]. De plus, la variation du taux de répétition de l'IRN dans le temps pour créer une mélodie a conduit à une activation supplémentaire dans le gyrus temporal supérieur (STG) et le planum polare (PP), ce qui suggère un traitement hiérarchique du timbre à travers le cortex auditif. Dans cette optique, les enregistrements MEG de Krumbholz et al. ont montré qu'à mesure que le taux de répétition des stimuli IRN augmente, un nouveau N100m est détecté autour de la HG lorsque le taux de répétition franchit le seuil inférieur pour la perception du timbre, et l'amplitude de cette "réponse au timbre" augmente avec la salinité du timbre [21].

Il y a cependant un débat sur l'emplacement précis de la zone de sélection de l'emplacement. Comme le soulignent Hall et Plack, l'utilisation des stimuli IRN seuls pour identifier les zones corticales sensibles au timbre est insuffisante pour saisir le large éventail de stimuli qui peuvent induire la perception du timbre : l'activation de HG peut être spécifique aux stimuli répétitifs à large bande [22]. En effet, sur la base des signaux BOLD observés en réponse à de multiples stimuli de pitch-evoking, Hall et Plack suggèrent que le planum temporale (PT) est plus pertinent pour le traitement du pitch.

Malgré les désaccords en cours sur la zone neuronale précise spécialisée dans le codage du timbre, de telles preuves suggèrent que les régions situées en antérolatéral par rapport à A1 peuvent être spécialisées dans la perception du timbre. L'identification des neurones " sélectifs du timbre " à la frontière antérolatérale de A1 dans le cortex auditif du marmouset vient étayer cette notion. Ces neurones étaient sélectivement sensibles à la fois aux sons purs et aux harmoniques F0 manquants avec les périodicités similaires [23]. Beaucoup de ces neurones étaient également sensibles à la périodicité d'autres stimuli, tels que les trains de clics ou le bruit IRN. Cela prouve clairement que ces neurones ne répondent pas simplement à une composante particulière du signal acoustique, mais qu'ils représentent spécifiquement des informations relatives au timbre.

Codage périodique ou codage de timbre ?

[modifier | modifier le wikicode]L'accumulation de preuves suggère donc qu'il existe des neurones et des zones neurales spécialisées dans l'extraction de F0, probablement dans des régions juste avant les régions à faible FB de A1. Cependant, il y a encore des difficultés à appeler ces neurones ou zones "sélectives du timbre". Bien que le stimulus F0 soit certainement un déterminant clé du timbre, il n'est pas nécessairement équivalent au timbre perçue par l'auditeur.

Il y a cependant plusieurs sources de données suggérant que ces régions sont en fait des régions codant le pitch, plutôt que seulement F0. Par exemple, une étude plus poussée des unités sélectives de pas de marmouset par Bendor et ses collègues a démontré que l'activité de ces neurones correspond bien aux réponses psychophysiques des animaux [8]. Ces auteurs ont testé la capacité des animaux à détecter un complexe harmonique en phase alternée au milieu d'une présentation continue d'harmoniques de même phase au même F0, afin de distinguer entre le moment où les animaux se fient davantage à des repères d'enveloppe temporelle pour la perception du timbre qu'à des repères spectraux. Conformément aux expériences psychophysiques chez l'homme, les marmousets utilisaient principalement des repères d'enveloppe temporelle pour les harmoniques d'ordre supérieur, les harmoniques non résolues de faible F0, tandis que les repères spectraux étaient utilisés pour extraire le timbre des harmoniques d'ordre inférieur des complexes F0 élevés. L'enregistrement de ces neurones sélectifs de hauteur a montré que l'accord F0 décalé vers le bas d'une octave pour les harmoniques de phase alternée, par rapport aux harmoniques de même phase pour les neurones accordés sur les basses F0s. Ces modèles de réponses neuronales sont donc cohérents avec les résultats psychophysiques et suggèrent que des indices temporels et spectraux sont intégrés dans ces neurones pour influencer la perception du timbre.

Encore une fois, cette étude ne permet pas de distinguer définitivement si ces neurones sélectifs de hauteur représentent explicitement le timbre, ou simplement une intégration d'informations F0 qui seront ensuite décodées pour percevoir le timbre. Une approche plus directe a été adoptée par Bizley et al, qui ont analysé comment les mesures LFP et MUA du cortex auditif chez les furets pourraient être utilisées indépendamment pour estimer le stimulus F0 et la perception du timbre [24]. Alors que les furets étaient engagés dans une tâche de discrimination de hauteur (pour indiquer si un son de voyelle artificielle cible était plus haut ou plus bas en hauteur qu'une référence dans un paradigme de choix forcé 2-alternative forcé], l'analyse receiver operating characteristic (ROC) a été utilisée pour estimer la discriminabilité de l'activité neuronale dans la prédiction du changement dans F0 ou le choix comportemental réel (i)].e. un substitut de la perception du timbre). Ils ont constaté que les réponses neurales dans l'ensemble du cortex auditif étaient informatives en ce qui concerne les deux. Au départ, l'activité discriminait mieux F0 que le choix de l'animal, mais l'information concernant le choix de l'animal s'est régulièrement accrue tout au long de l'intervalle post-timulus, devenant finalement plus discriminable que la direction du changement de F0 [24].

La comparaison des différences de ROC entre les zones corticales étudiées a montré que l'activité des champs postérieurs discriminait mieux le choix des furets. Cela peut être interprété de deux façons. Étant donné que l'activité liée au choix était plus élevée dans les champs postérieurs (qui se situent à la limite inférieure du BF de A1) que dans les champs primaires, cela peut être considéré comme une preuve supplémentaire de la sélectivité du timbre près de la limite inférieure du BF de A1. D'autre part, le fait que l'information relative au timbre a également été observée dans les champs auditifs primaires peut suggérer que suffisamment d'information relative au timbre peut déjà être établie à ce stade, ou qu'un code réparti sur plusieurs zones auditives. En effet, alors que les neurones individuels répartis dans le cortex auditif sont en général sensibles à de multiples paramètres acoustiques (et donc non " sélectifs en hauteur "), les analyses théoriques de l'information ou neurométriques (utilisant des données neurales pour inférer des informations liées aux stimulus) indiquent que l'information en hauteur peut néanmoins être représentée de manière robuste via population coding, ou même par des neurones individuels par multiplexage temporel (i.e., représentant plusieurs caractéristiques sonores dans des fenêtres temporelles distinctes) [25][26]. Ainsi, en l'absence de stimulation ou de désactivation de ces neurones ou zones putatifs sélectifs du timbre pour démontrer que de telles interventions induisent des biais prévisibles ou des altérations du timbre, il se peut que le timbre soit représentée dans des codes spatialement et temporellement répartis sur l'ensemble du cortex auditif, plutôt que de s'appuyer sur des représentations locales spécialisées.

Ainsi, l'enregistrement électrophysiologique et les études de neuroimagerie suggèrent qu'il pourrait y avoir un code neuronal explicite pour le timbre près de la limite inférieure du BF de A1. Certes, les réponses cohérentes et sélectives à une large gamme de stimuli de pitch-evoking suggèrent que ces neurones et zones putatifs sélectifs de pitch ne reflètent pas simplement une caractéristique physique immédiatement disponible du signal acoustique. De plus, il est prouvé que ces neurones sélectifs de poix putatifs extraient l'information des signaux spectraux et temporels de la même manière que l'animal. Cependant, en vertu de la relation abstraite entre le timbre et un signal acoustique, une telle preuve corrélative entre un stimulus et une réponse neuronale ne peut être interprétée que comme une preuve que le système auditif a la capacité de former des représentations améliorées des paramètres liés au timbre. En l'absence de preuves causales plus directes pour ces neurones présumés sélectifs du timbre et les zones neurales déterminant la perception du timbre, nous ne pouvons pas conclure si les animaux se fient effectivement à de tels codes explicites localisés pour le timbre, ou si les solides représentations distribuées du timbre à travers le cortex auditif marquent le codage final du timbre dans le système auditif.

Références

[modifier | modifier le wikicode]- ↑ NeurOreille and authors, « Journey into the world of hearing »,

- ↑ Schouten, J. F. (1938). The perception of subjective tones. Proceedings of the Koninklijke Nederlandse Akademie van Wetenschappen, 41, 1086-1093.

- ↑ Cynx, J. & Shapiro, M. Perception of missing fundamental by a species of songbird (Sturnus vulgaris). J Comp Psychol 100, 356–360 (1986).

- ↑ Heffner, H., & Whitfield, I. C. (1976). Perception of the missing fundamental by cats. The Journal of the Acoustical Society of America, 59(4), 915-919.

- ↑ 5,0 5,1 5,2 5,3 et 5,4 Schnupp, J., Nelken, I. & King, A. Auditory neuroscience: Making sense of sound. (MIT press, 2011).

- ↑ Gerlach, S., Bitzer, J., Goetze, S. & Doclo, S. Joint estimation of pitch and direction of arrival: improving robustness and accuracy for multi-speaker scenarios. EURASIP Journal on Audio, Speech, and Music Processing 2014, 1 (2014).

- ↑ Carlyon RP, Shackleton TM (1994). "Comparing the fundamental frequencies of resolved and unresolved harmonics: Evidence for two pitch mechanisms?" Journal of the Acoustical Society of America 95:3541-3554

- ↑ 8,0 et 8,1 Bendor D, Osmanski MS, Wang X (2012). "Dual-pitch processing mechanisms in primate auditory cortex," Journal of Neuroscience 32:16149-61.

- ↑ Tramo, M. J., Shah, G. D., & Braida, L. D. (2002). Functional role of auditory cortex in frequency processing and pitch perception. Journal of Neurophysiology, 87(1), 122-139.

- ↑ Rask-Andersen, H., Tylstedt, S., Kinnefors, A., & Illing, R. B. (2000). Synapses on human spiral ganglion cells: a transmission electron microscopy and immunohistochemical study. Hearing research, 141(1), 1-11.

- ↑ Cariani, P. A., & Delgutte, B. (1996). Neural correlates of the pitch of complex tones. I. Pitch and pitch salience. Journal of Neurophysiology, 76(3), 1698-1716.

- ↑ Oxenham, A. J., Bernstein, J. G., & Penagos, H. (2004). Correct tonotopic representation is necessary for complex pitch perception. Proceedings of the National Academy of Sciences of the United States of America, 101(5), 1421-1425.

- ↑ Winter, I. M., Wiegrebe, L., & Patterson, R. D. (2001). The temporal representation of the delay of iterated rippled noise in the ventral cochlear nucleus of the guinea-pig. The Journal of physiology, 537(2), 553-566.

- ↑ Schreiner, C. E. & Langner, G. Periodicity coding in the inferior colliculus of the cat. II. Topographical organization. Journal of neurophysiology 60, 1823–1840 (1988).

- ↑ Whitfield IC (1980). "Auditory cortex and the pitch of complex tones." J Acoust Soc Am. 67(2):644-7.

- ↑ Pantev, C., Hoke, M., Lutkenhoner, B., & Lehnertz, K. (1989). Tonotopic organization of the auditory cortex: pitch versus frequency representation.Science, 246(4929), 486-488.

- ↑ Fishman YI, Reser DH, Arezzo JC, Steinschneider M (1998). "Pitch vs. spectral encoding of harmonic complex tones in primary auditory cortex of the awake monkey," Brain Res 786:18-30.

- ↑ Steinschneider M, Reser DH, Fishman YI, Schroeder CE, Arezzo JC (1998) Click train encoding in primary auditory cortex of the awake monkey: evidence for two mechanisms subserving pitch perception. J Acoust Soc Am 104:2935–2955.

- ↑ Kadia, S. C., & Wang, X. (2003). Intégration spectrale en A1 de primates éveillés : neurones aux caractéristiques d'accordage simple et multicrêtes. Journal of neurophysiology ", " 89 "(3), 1603-1622.

- ↑ Patterson RD, Uppenkamp S, Johnsrude IS, Griffiths TD. (2002) "The processing of temporal pitch and melody information in auditory cortex," Neuron 36:767-776.

- ↑ Krumbholz, K., Patterson, R. D., Seither-Preisler, A., Lammertmann, C., & Lütkenhöner, B. (2003). Neuromagnetic evidence for a pitch processing center in Heschl’s gyrus. Cerebral Cortex, 13(7), 765-772.

- ↑ Hall DA, Plack CJ (2009). "Pitch processing sites in the human auditory brain," Cereb Cortex 19(3):576-85.

- ↑ Bendor D, Wang X (2005). "The neuronal representation of pitch in primate auditory cortex," Nature 436(7054):1161-5.

- ↑ 24,0 et 24,1 Bizley JK, Walker KMM, Nodal FR, King AJ, Schnupp JWH (2012). "Auditory Cortex Represents Both Pitch Judgments and the Corresponding Acoustic Cues," Current Biology 23:620-625.

- ↑ Walker KMM, Bizley JK, King AJ, and Schnupp JWH. (2011). Multiplexed and robust representations of sound features in auditory cortex. Journal of Neurosci 31(41): 14565-76

- ↑ Bizley JK, Walker KM, King AJ, and Schnupp JW. (2010). "Neural ensemble codes for stimulus periodicity in auditory cortex." J Neurosci 30(14): 5078-91.