Psychologie cognitive pour l'enseignant/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/Psychologie_cognitive_pour_l%27enseignant

Introduction

Comme beaucoup d'élèves peuvent en témoigner, la mémoire est d'une grande importance à l'école. Beaucoup de personnes en gardent une image assez caricaturale, souvent réduite à l'apprentissage par cœur, au bachotage intensif et aux révisions qui précèdent les interrogations. Et force est de constater que cette forme d'apprentissage n'est pas très populaire et qu'elle est contestée. À quoi bon apprendre des choses par cœur si celles-ci se trouvent en quelques clics sur le net ? De nos jours, il n'est pas rare d'entendre des pédagogues mettre l'accent sur l'acquisition de compétences, tout en dénigrant l'apprentissage de faits et de connaissances brutes. Ceux-ci pensent que les connaissances factuelles en elles-mêmes ne sont pas importantes, vu qu'on peut les retrouver facilement en recherchant sur le net ou dans des livres. Mieux vaut apprendre à un élève des méthodes ou des compétences décontextualisées, qui peuvent s'appliquer en toutes circonstances. Et le fait d'avoir appris beaucoup de connaissances serait sans lien avec les compétences générales ou les capacités intellectuelles.

Mais quiconque a déjà interrogé les spécialistes en sciences cognitives a entendu un autre son de cloche. Pour les spécialistes de la cognition, qu'ils soient psychologues, neuroscientifiques, chercheurs en IA, ou autres, connaissances acquises et compétences sont fortement liées. Ils vous diront que la mémoire est plus « intelligente » qu'il n'y parait, à tel point qu'elle intervient fortement dans les processus mentaux de plus haut niveau, tels que la compréhension orale et écrite, la créativité, la résolution de problèmes ou le raisonnement. Beaucoup de théories qui visent à expliquer ces processus mentaux donnent une grande importance au stock de connaissances emmagasinées. Comme le dit Daniel Willingham, dans son livre de vulgarisation "Pourquoi les enfants n'aiment pas l'école" :

« La culture générale est une condition sine qua non pour l'acquisition de compétences. »

Beaucoup de compétences intellectuelles requièrent en effet d'appliquer des connaissances acquises dans des contextes variés, d'utiliser de manière flexible ce que l'on sait. Comme l'a dit le renommé psychologue Sternberg, auteur de la théorie triarchique de l'intelligence :

« On ne peut appliquer ce qu'on connaît de manière judicieuse si l'on n'a rien à appliquer. »

Certains scientifiques vont même plus loin et réduisent la performance en toute tâche à une simple application de connaissances, celles-ci fondant l'intelligence. Selon Yates :

« Tout ce qui est intelligence n'est qu'application et adaptation de petites unités de connaissances, qui, au total, produisent une cognition complexe. »

Cela fait beaucoup de citations, tout cela pour dire que l'avis des scientifiques sur le sujet est unanime. Cette vision est cependant contre-intuitive, mais elle est basée sur de nombreuses expériences dans des domaines de recherche variés, allant de l'étude de l'expertise, en passant par l'étude de la résolution de problèmes, en passant par l'étude de la compréhension orale/écrite.

Dans ce chapitre, nous allons voir en quoi l'acquisition de connaissance est importante pour les compétences intellectuelles. De plus, nous allons voir comment la mémoire fonctionne, ce qui nous permettra de mieux comprendre ce qui se passe dans la tête d'un élève quand il apprend. Cette introduction théorique servira de base pour la suite du cours et on ne peut pas aller plus loin sans comprendre au mieux les concepts de ce chapitre. Autant vous dire que ce chapitre d'introduction a une importance capitale pour la suite du cours.

Les mémoires à court-terme et à long-terme

[modifier | modifier le wikicode]De nos jours, les scientifiques font la distinction entre trois grandes catégories de mémoires : mémoire sensorielle, mémoire à court terme et mémoire à long terme. Les deux premières sont des mémoires temporaires qui mémorisent des informations pour une durée limitée, qui ne dépasse pas quelques secondes ou quelques minutes. La troisième est la mémoire du langage courant, celle qui mémorise les souvenirs, connaissances et habitudes.

Les trois types de mémoire

[modifier | modifier le wikicode]La mémoire sensorielle est purement perceptive et de très courte durée. Elle conserve temporairement ce que nous venons de voir ou d'entendre durant quelques millisecondes, le temps que nous y prêtions attention. Elle est subdivisée en plusieurs mémoires : les fameuses mémoires auditives, visuelles, et kinesthésiques auxquelles il est parfois fait allusion dans divers écrits de vulgarisation. Mais ces mémoires s'éloignent grandement du portrait qui en est fait dans la vulgarisation grand public. Elles peuvent retenir une grande quantité d'informations sensorielles (sons, images, sensations tactiles) pour une durée de rétention inférieure à 2 ou 3 secondes. Un certain traitement automatique est effectué sur le contenu de ces mémoires, qu'il s'agisse de processus de détection des contours d'objets pour la mémoire visuelle, des processus de détection de la tonalité ou de l’intensité sonore pour la mémoire auditive, etc. L'attention, notre capacité à nous concentrer, fait ensuite un tri pour n'en retirer que les informations essentielles. Nous ne détaillerons pas plus ces mémoires sensorielles, celles-ci étant peu utiles dans le cadre pédagogique.

La mémoire à court terme stocke un nombre limité d'informations durant quelques secondes ou quelques minutes. Elle permet par exemple de mémoriser un numéro de téléphone avant de le composer, mais cette information sera oubliée une fois le numéro composé. L'idée principale est qu'elle a une capacité limitée à environ 7 (±2) informations. Elle correspond à une capacité de maintien temporaire limitée, qui est mise en évidence dans des expériences de mémorisation pure. Mais les scientifiques ont aussi conçu des expériences où les sujets devaient non seulement mémoriser temporairement des informations, mais aussi les manipuler. Dans ces expériences, on observe que le nombre d'items mémorisés temporairement chute à environ 4 items, allant de 3 à 5-6 items. De telles expériences mesurent donc une forme de mémoire légèrement différente de la mémoire à court-terme, appelée la mémoire de travail. Elle correspond à l'ensemble des informations que l'on peut manipuler, celles sur lesquelles on peut réfléchir. C'est cette mémoire de travail qui est utilisée pour comprendre ce que raconte votre interlocuteur dans une conversation, qui permet de faire des calculs complexes qui demandent de garder à l'esprit des résultats temporaires, ou qui permet de résoudre des problèmes qui demandent de garder certaines informations à l'esprit. En milieu scolaire, elle est utilisée pour comprendre ce que raconte le professeur, pour résoudre des exercices et bien d'autres choses.

Ces deux mémoires temporaires sont à opposer à la mémoire à long terme qui correspond à la mémoire du langage courant. Il s'agit d'une mémoire de longue ou moyenne durée qui conserve des informations très longtemps après les avoir apprises. Elle stocke des souvenirs, connaissances et savoir-faire très résistants à l'oubli.

Encodage, stockage et récupération

[modifier | modifier le wikicode]Les informations transitent d'une mémoire à l'autre, de la mémoire sensorielle à la mémoire à court terme, avant d'arriver à la mémoire à long terme. Mais ce chemin est semé d’embûches qui peuvent perturber la mémorisation. Le premier obstacle est le transfert de la mémoire sensorielle vers la mémoire à court terme. Seules les choses auxquelles nous prêtons attention passent dans la mémoire à court terme, le reste ayant peu de chances d'être pris en compte (sauf dans quelques rares exceptions qui ne nous intéressent pas). Se concentrer, faire attention est donc une première étape pour apprendre.

L'étape suivante est de faire passer les connaissances de la mémoire à court terme vers la mémoire à long terme : c'est ce qu'on appelle l'encodage. Ce terme parait barbare, mais il correspond à la mémorisation proprement dite. Ce qui est encodé est tout simplement mémorisé. Pas forcément mémorisé pour longtemps, l'information peut être oubliée en quelques jours ou même heures, mais elle est enregistrée au moins temporairement. L'encodage implique la mémoire de travail, qui n'est autre que la porte d'entrée de la mémoire à long terme. Mais nous en reparlerons à la fin de ce chapitre.

Après l'apprentissage, les connaissances apprises sont temporairement stockées dans un état labile, fragile. Elles vont alors subir des modifications, qui vont les rendre nettement moins sensibles à l'oubli : c'est la phase de consolidation. Sans rentrer dans les détails techniques, une partie de la consolidation a lieu lors du sommeil, ce qui explique l'effet positif du sommeil sur la mémoire. Il faut cependant préciser que la consolidation ne fait pas que solidifier les connaissances apprises, mais qu'elle réorganise les connaissances acquises et les relie entre elles. Les preuves de ce fait sont légion, mais en voici un exemple : si on présente un problème à résoudre à un sujet, celui-ci réussit nettement mieux si on le fait dormir entre la présentation du problème et sa première tentative de résolution, et l'on sait que cela provient d'une réorganisation des informations acquises lors de la journée.

Une fois encodée/mémorisée, l'information peut être rappelée : on peut s'en souvenir et la réutiliser. La facilité de ce rappel est absolument primordiale : elle fait que nous allons oublier quelque chose, ne pas s'en souvenir au moment opportun et donc, ne pas appliquer cette connaissance de manière flexible. Évidemment, plus l'encodage est efficace, plus le rappel ultérieur est facile. Nous verrons comment faciliter un encodage efficace dans les chapitres qui suivent. Encodage et rappel sont extrêmement dépendants l'un de l'autre, aussi il est bon de les présenter plus ou moins ensemble. L'intérêt de détailler ces processus est de comprendre pourquoi les élèves oublient ou pourquoi ils ne peuvent pas réutiliser leurs connaissances dans des contextes opportuns, les deux situations ayant la même cause : une incapacité à récupérer l'information en mémoire. Autant dire que ce que nous allons aborder est de première importance pour la pratique pédagogique.

La mémoire à long-terme : des connaissances variées

[modifier | modifier le wikicode]La mémoire à long-terme contient des connaissances très diverses, au point où en faire la liste complète serait futile. Par contre, dans ce cours, nous allons beaucoup utiliser une distinction entre connaissances sémantiques et procédurales. L'une est celle des connaissances pratiques, l'autre celle des connaissances théoriques, descriptives, relationnelles. L'une est la mémoire du "Comment ?", l'autre celle du "Pourquoi ?". En anglais, on parle de "knowledge-that" pour les connaissances sémantiques, de "know-how, knowing-how" pour les connaissances procédurales.

Les connaissances sémantiques

[modifier | modifier le wikicode]Les connaissances sémantiques sont des connaissances conceptuelles, descriptives et relationnelles, qui permettent de décrire les choses, de savoir ce qu'elles sont, comment elles interagissent, etc. C'est la mémoire des concepts, des catégories, des faits, des définitions, des relations, des associations d'idées, du savoir en général. Et là où les choses deviennent intéressantes, c'est qu'il y en a de plusieurs types.

Le premier type est celui des connaissances déclaratives, que l'on peut verbaliser. Elles se distinguent des autres par le fait qu'on peut les exprimer avec des mots, les restituer à l'oral ou à l'écrit. C'est d'ailleurs de là que vient le terme de connaissances "déclaratives" : on peut les exprimer, les déclarer (verbalement) à quelqu'un d'autre. Pour simplifier les explications, je parlerais parfois de connaissances verbales pour les désigner, afin de bien souligner un point important : ces connaissances se transmettent par voie orale/écrite, par le biais du langage.

Les connaissances verbales sont clairement très importantes lors de la scolarité, et vous pensez peut-être qu'elles sont équivalentes aux connaissances sémantiques. Mais en fait, ce n'est pas le cas. Il existe des connaissances sémantiques qui ne peuvent pas être verbalisées, peu importe comment on s'y prend.

Un bon exemple est celui des objets du quotidien : essayez de m'expliquer ce qu'est un chat, une chaise, un arbre, une arme à feu Vous avez une idée de ce que sont ces choses, vous aurez du mal à verbaliser une définition, mais vous savez parfaitement les reconnaitre. Vous savez à quoi ressemble un chat, une arme à feu, ou une chaise. Un cas extrême est celui de la reconnaissances des visages : vous reconnaissez vos proches ou vos collègues, mais vous n'arriverez jamais à décrire leur visage dans une conversation. En général, il s'agit de connaissances assez concrètes qui permettent de reconnaitre les objets familiers, et de les "classer/catégoriser" dans une certaine mesure. On parle alors de connaissances objectuelles, terme traduit directement de l'anglais.

Et n'allez pas croire que cela ne concerne que des objets concrets, certains concepts abstraits sont dans ce cas. Par exemple, essayez de me définir la justice ? Compliqué, n'est-ce pas ? Définir ce qu'est l'art l'est encore plus, de nombreux philosophes s'y sont cassés les dents. D'autres concepts plus pratiques sont aussi dans ce cas là. Par exemple, demandez à un informaticien ce qu'est un algorithme, il aura du mal à vous répondre. Il y a bien des définitions basées sur le traitement automatique de l'information, sur une séquence d'actions, mais elles sont en réalité assez fausses, la notion est assez vague. Idem pour d'autres concepts pourtant bien intuitifs : demandez à un botaniste de définir un arbre, il vous dira qu'il n'y a pas de définition pour ça et que le fait que ce soit un groupe paraphylétique n'aide pas. Idem pour définir ce qui est vivant : c'est le cauchemar de beaucoup de biologistes.

Et pourtant, on doit bien reconnaitre que même si on ne peut pas les définir, ces concepts sont très utiles. Dans les faits, c'est parce que la notion de définition ne s'applique pas trop à ces concepts. Il s'agit de concepts qui regroupent des choses ayant un air de famille, qui ont des similarités, des points communs, mais au point d'avoir une définition. Par exemple, toutes les activités artistiques se ressemblent un peu : on peut trouver des ressemblances entre la peinture et la sculpture, entre le cinéma et la BD, mais rien de vraiment commun à tous les arts, seulement des airs de familles.

De tels concepts difficilement verbalisables, sont regroupés sous le terme de connaissance tacite, ou encore de connaissance induites. Le dernier terme est assez parlant, bien qu'imparfait. Il trahit le fait que ces concepts tacites se forment en réalité par extraction de similarités entre plusieurs exemples semblables. Notre cerveau est capable d'extraire des informations à partir d'exemples, et notamment d'extraire des semblants de catégories. Ce processus de catégorisation basé sur la similarité entre items est très puissant et à l'origine de nombreux concepts du quotidien, mais aussi de concepts plus abstraits. Mais cela ne signifie pas que ce contenu ne puisse pas être transmis, l'usage d'exemples et de contre-exemples permet de générer de telles connaissances tacites, comme nous le verrons dans un chapitre dédié. Dans les faits, connaissances tacites et verbales sont complémentaires et il n'est pas rare qu'un même concept soit appris avec les deux modes : on en a alors une représentation mentale déclarative, qui complète une autre représentation tacite/induite.

Les connaissances procédurales

[modifier | modifier le wikicode]Pour résumer de manière très simplifiée, les connaissances procédurales sont celles du "comment faire", du "quoi faire", de la pratique, de l'action. Elles sont le plus souvent des procédures, des séquences d'action à effectuer dans un ordre précis. Par exemple, prenez l'algorithme de multiplication posée que vous avez appris à l'école primaire : c'est une procédure, composée d'une série d'étapes à effectuer dans un certain ordre. C'est techniquement une connaissance procédurale. Beaucoup de procédures apprises en cours de math/physique sont dans ce cas.

Les connaissances procédurales s'acquièrent lentement, à grand renfort de répétitions et d'entrainement. On observe alors une augmentation de la performance avec les répétitions, qui progresse lentement mais sûrement. Cependant, l'apprentissage procédural peut être aidé par les connaissances verbales. Le fait est que vous pouvez parfaitement expliquer une procédure à quelqu'un, par oral ou par écrit, mais cela ne signifie pas qu'il saura l'appliquer du premier coup.

Par exemple, vous avez appris à poser des multiplications et des divisions, mais cela a demandé de l'entrainement, de répéter des exercices. Au final, vous avez d'abord appris la procédure sous forme verbale, puis ensuite vous avez acquis une connaissance procédurale de la multiplication à grand coup d'entrainement et de répétition. Pour le dire autrement, vous avez d'abord appris la procédure en tant que connaissance verbale (je fais ceci, puis cela), mais le tout a rapidement été complété par une connaissance procédurale, impossible à transmettre oralement. C'est là une subtilité assez importante à comprendre.

Il faut noter que les connaissances procédurales et sémantiques sont généralement reliées, elles peuvent s’acquérir indépendamment l'une de l'autre. Et peut-être avez-vous pensé qu'il est préférable d'acquérir les connaissances sémantiques adéquates avant de passer aux connaissances procédurales, mais c'est quelque chose qui est encore en débat et n'a pas trop l'air de tenir la route. Beaucoup d'études ont étudié l'influence de l'ordre d'acquisition pour les mathématiques de primaire, notamment l'acquisition du calcul. Les recherches donnent des résultats très variables, avec des études montrant que l'acquisition précoce des connaissances sémantiques aidait grandement l'apprentissage procédural, et d'autres études montrant l'inverse, d'autres études montrant qu'il n'y avait pas d'influence. Il y a des chances que l'ordre idéal dépende du sujet traité et du matériel à apprendre.

Les connaissances conditionnelles

[modifier | modifier le wikicode]Un point important est que les connaissances déclaratives et procédurales interagissent lors de la prise de décision. C'est bien beau d'avoir des connaissances pratiques, mais encore faut-il savoir quand les utiliser, sans quoi on ne les utilise pas de manière pertinente. Et c'est là qu'intervient un nouveau type de connaissances, qui est difficile à classer, qui fait la jonction entre connaissances déclaratives et procédurales : les connaissances conditionnelles. Elles permet de savoir quand utiliser telle ou telle procédure stockée en mémoire procédurale. Formellement, ce sont un sous-type de connaissances déclaratives. Les connaissances conditionnelles sont des règles du type "Si je suis dans telle situation, alors je dois appliquer telle procédure".

Pour donner un exemple, prenons l'apprentissage des quatre opérations à l'école primaire. Les enfants apprennent d'abord à faire des additions, soustractions, multiplications et divisions à froid, sans contexte. Ils effectuent des exercices où on leur demande de faire des calculs bruts, comme 45*7, 12+7, 89-42, etc. Il s'agit là d'exercices très importants qui entrainent des connaissances procédurales. Pourtant, cela ne suffit pas pour que les enfants sachent résoudre des problèmes. Par exemple, un enfant peut très bien savoir faire les calculs, mais ne pas pouvoir résoudre des petits problèmes du style :

- "Jean a 5 bonbons, il en mange 2, il en donne 2 à Emilia, combine lui reste-t-il de bonbons à la fin ?"

La raison à cela est que les enfants doivent comprendre le problème et décider quelle opération appliquer en fonction du problème. Certains se résolvent avec une addition, d'autres avec une soustraction, une multiplication, mais l'opération à effectuer dépend du problème. Mais si l'enfant sait faire le calcul adéquat, cela ne signifie pas qu'il saura qu'il faut l'appliquer pour tel ou tel problème. C'est là qu'interviennent les connaissances conditionnelles.

Pour ce genre de problème, la recherche a confirmé quelque chose que les instituteurs et pédagogues avaient intuité et formalisé depuis longtemps. Les problèmes de ce genre se classent en plusieurs catégories, assez abstraites, chacune étant associée à une opération. Par exemple, les problèmes de partage se résolvent avec une division, tout comme les problèmes de groupement. Dans les problèmes de groupement, on a M items qu'on veut répartir en N groupes, la division est évidente. Et il existe le même genre de problèmes pour l'addition/soustraction, la multiplication, etc. Dans les faits, les psychologues spécialistes de la cognition et les instituteurs n'ont pas exactement les mêmes catégories/classes de problèmes, mais passons.

Toujours est-il que résoudre des problèmes de ce genre est un processus qui se fait comme suit : l'élève reconnait la classe/catégorie à laquelle ce problème appartient, et il en déduit la procédure à adopter. En clair, il doit non seulement développer les connaissances procédurales des opérations, mais aussi une connaissance sémantique des différentes catégories de problèmes, et des connaissances conditionnelles qui lient les deux. Notons que les catégories de problèmes en question sont des connaissances qui s’acquièrent aussi bien verbalement que par induction. A force de réfléchir à ces problèmes, l'élève va forger des catégories en extrayant des similarités entre eux, ce qui générera une connaissance induite pour chaque catégorie de problème. Et il reçoit souvent une connaissance explicite, verbale, de chaque catégorie de problème. Les deux sont importantes et il ne faut pas sous-estimer l'importance des connaissances inductives forgées lors de la résolution des exercices.

Et ce mécanisme est assez général, il est très important dans de nombreux domaines. Les études sur l'expertise ont montré qu'il est à la base des compétences dans le domaine des échecs, des capacités de diagnostic médical, des performances des contrôleurs aériens, et j'en passe. Dans un grand nombre de domaines, les experts reconnaissent qu'un problème/situation appartient à une catégories de problèmes/situation déjà acquise, auquel est associée la solution. Les catégories en question sont généralement acquises aussi bien verbalement que tacitement, les experts reconnaissant de manière presque intuitive qu'un problème colle à une catégorie, sans raisonnement verbal.

L'apprentissage des connaissances conditionnelles se fait en même temps que l'apprentissage procédural, lors de la pratique, les deux ayant lieu en même temps. Il est supposé que les connaissances procédurales/conditionnelles se forment par un processus progressif. Au tout début, les élèves mémorisent les exercices qu'ils font, ou qu'on leur présente. Puis, lors des exercices ultérieurs, ils tendent à raisonner par analogie. Ils tentent de résoudre les exercices présentés en faisant des analogies avec les exemples mémorisés. Si les deux exercices se ressemblent, l'élève utilisera l'exercice mémorisé pour trouver la solution de l'exercice à résoudre. Ce processus d'analogie/similarité/ressemblance est une sorte de seconde étape, mais ne permet pas de résoudre tous les exercices. Après un certain temps, le processus d'analogie/calcul de similarité aura permis de dégager une ou plusieurs catégories de problèmes, qui serviront de connaissances conditionnelles.

Les deux systèmes de mémoire à long-terme : déclarative et procédurale

[modifier | modifier le wikicode]La distinction peut paraitre sortir de nulle part, même si elles est intuitive. Mais dans les faits, diverses observations et expériences nous laissent penser que la mémoire à long-terme fait cette distinction entre procédures et concepts ! D'après les connaissances actuelles, la mémoire à long-terme subdivisée en deux grands sous-ensembles : une mémoire explicite pour les connaissances et souvenirs et une mémoire implicite pour les automatismes acquis. Les deux n'impliquent pas les mêmes aires cérébrales : lobe temporal médian et néocortex pour la mémoire déclarative, cervelet et noyaux gris centraux pour la mémoire procédurale.

De nombreux patients ayant eu un AVC perdent l'une ou l'autre de ces mémoires. Un cas classique est celui du patient Henri Mollaison, atteint d'une lésion au lobe temporal médian. Il était atteint d'un syndrome amnésique assez particulier. Il n'avait pas oublié quoique ce soit d'avant la lésion (ou presque, mais simplifions), mais n'était plus capable de mémoriser ou d'apprendre quoi que ce soit. Il ne formait plus de souvenir, ne pouvait plus apprendre de concepts, il oubliait toutes les explications qu'on lui présentait, il oubliait tout ce qu'on lui disait en à peine quelques minutes. En clair, l'apprentissage pour ce qui est de la mémoire explicite/sémantique/déclarative était fortement endommagé. Pourtant, il était capable d'apprentissages procéduraux assez élaborés. Les scientifiques qui ont étudié son cas lui ont fait apprendre à reproduire un dessin présenté à travers un miroir (donc inversé), à résoudre le problème des tours de Hanoi, et quelques autres apprentissages procéduraux dans le même genre. Sa mémoire procédurale était intacte, l'apprentissage associé l'était aussi !

Le contenu de la mémoire explicite est assez compliqué à expliquer car elle peut mémoriser des informations très diverses. En effet, la mémoire explicite est souvent subdivisée en une mémoire sémantique pour les connaissances sémantiques, et une mémoire épisodique pour les souvenirs. Nous pouvons facilement passer outre la mémoire épisodique et n'allons nous intéresser qu'à la mémoire sémantique, qui est très liée au langage. Elle regroupe les connaissances sémantiques en général, à savoir aussi bien les connaissances verbales et tacites/inductives vues plus haut, avec éventuellement les connaissances conditionnelles.

Dans la mémoire sémantique, les concepts sont représentés par des mécanismes mentaux différents, que nous verrons au cours de ce cours : catégories, concepts, schémas, règles définitionnelles mentales, prototypes, et autres structures mentales aux noms barbares. Notons que la mémoire sémantique mémorise aussi bien des connaissances verbales/déclaratives que des connaissances autres. Une bonne partie du contenu de la mémoire déclarative est tacite, intuitif, non-codifié, difficile à exprimer avec des mots.

La mémoire procédurale, dont le nom trahit là aussi son fonctionnement, mémorise des procédures, à savoir un ensemble d'étapes à effectuer dans un certain ordre. Dès qu'on doit séquencer quelque chose, la mémoire procédurale est impliquée. Elle est impliquée dans les apprentissages moteurs, pour mémoriser des séquences de mouvements, mais elle est aussi impliquée dans des séquences d'actions abstraites, qui ne sont autres que les connaissances procédurales. Pensez aux procédures de calcul en mathématique. La mémoire procédurale a son rôle à jouer dans l'apprentissage de certains automatismes, notamment pour la lecture, l'écriture, le calcul et d'autres contenus.

Les mémoires explicite et procédurale se distinguent par le fait que l'apprentissage ne se fait de la même manière. Pour faire rentrer un automatisme dans la mémoire procédurale, il faut le faire répéter un grand nombre de fois. On observe alors une augmentation de la performance avec les répétitions, qui progresse lentement mais sûrement. À l'inverse, la mémoire explicite se caractérise par la capacité d'apprendre en une seule fois. Il suffit que l'élève soit exposé une première fois au matériel à apprendre pour s'en souvenir. Cela ne marche pas à tous les coups et la répétition aide à consolider les connaissances, mais elle n'est parfois pas nécessaire. Et pour comprendre pourquoi, il faut comprendre comment fonctionne la mémoire explicite, pour l'utiliser plus efficacement. Passons maintenant au fonctionnement de la mémoire explicite.

Le fonctionnement de la mémoire à long-terme (sémantique)

[modifier | modifier le wikicode]La mémoire sémantique/déclarative est constituée d'un réseau de connaissances reliées entre elles. Par exemple, un mot est associé au concept qui porte ce nom, plusieurs idées sont reliées entre elles par un lien logique, etc. L'ensemble de nos connaissances est mémorisé dans un gigantesque réseau de concepts, réseau qui mémorise le sens des choses, les liens entre concepts.

|

|

Reconnaissance, rappel et indices de récupération

[modifier | modifier le wikicode]Il existe plusieurs manières d'étudier le réseau sémantique et la mémoire. Les plus simples demandent à des sujets d'apprendre quelque chose (une liste de mots, une carte géographique ou n'importe quelle autre connaissance), avant de les interroger sur ce qu'ils en ont retenu.

- Les tests de reconnaissance demandent de reconnaître les informations de la liste parmi des pièges, des informations qui n'étaient pas dans la liste à apprendre.

- Les tâches de rappel demandent au sujet de se souvenir du matériel appris. Si le sujet doit réciter les informations apprises, sans aucune contrainte, on dit qu'il doit effectuer un rappel libre. Si le sujet doit réciter les informations apprises, mais qui reçoit des indices sur le matériel appris, il s'agit d'un test de rappel indicé. S'il doit réciter les informations dans l'ordre de présentation, c'est une tâche de rappel sériel.

On observe alors que la reconnaissance est nettement plus facile que le rappel indicé, qui est lui-même plus facile que le rappel libre. Reste à expliquer pourquoi.

Dans les tâches de reconnaissance, l'activation de la connaissance suffit à la récupérer. La reconnaissance d'un item va automatiquement activer celui-ci en mémoire. Il s'agit donc d'un accès direct à l'information mémorisée. Elle se base purement sur un processus de familiarité, qui permet de reconnaître des choses connues. Il s'agit d'un processus relativement primitif et qui échoue rarement. Pour simplifier, le processus de reconnaissance "active" les connaissances : plus l'activation est forte, plus la probabilité de rappel/reconnaissance est grande.

Dans les tâches de rappel, les choses changent. Commençons par les tâches de rappel indicé, qui sont plus simples à comprendre. Avec elles, la tâche de rappel va fournir des indices qui permettent de retrouver l'information demandée (les mots d'un énoncé, par exemple). L'information va devoir être retrouvée dans la mémoire, grâce à un processus de recherche qui parcourt le réseau mnésique de proche en proche, en partant des indices données par la tâche de rappel. On peut faire une analogie avec un moteur de recherche. Quand vous cherchez quelque chose sur le net, vous tapez des mots-clés dans le moteur de recherche et celui-ci récupère les informations sur le réseau en fonction de ces mots-clés. Ces mots-clés sont au réseau ce que les indices de la tâche de rappel indicé sont à notre mémoire. Mais l'analogie s’arrête là : les moteurs de recherche actuels ne fonctionnent absolument pas comme notre mémoire. Ce mécanisme de récupération est tellement efficace que Proust a écrit un livre rien qu'à partir de la perception d'une seule odeur, c'est vous dire ! Cependant, ce processus de recherche reste moins efficace que la familiarité testée en reconnaissance. Tout cela explique pourquoi la reconnaissance est plus facile que le rappel indicé ou libre.

Passons maintenant au rappel libre, qui n'est en soi pas si différent du rappel indicé. Avec le rappel libre, on se souvient forcément des derniers mots de la liste, qui sont encore en mémoire de travail et qui servent d'indices pour récupérer les mots manquants. En réalité, toute tâche de rappel fait intervenir des indices, aussi subtils soient-ils, qui guident la recherche en mémoire. Par exemple, si vous prenez un énoncé de mathématique ou de physique, les mots de l'énoncé sont autant d'indices. Ces indices sont appelés des indices de récupération. Notons que plus on donne d'indices de récupération, plus le sujet a de chances de se rappeler de l'information voulue. Preuve en est que les sujets se souviennent de certaines informations en rappel indicé, qu'ils n'arrivent pas à récupérer en rappel libre. Les informations n'étaient pas oubliées, elles étaient juste inaccessibles. L'oubli de ces informations provient alors d'un raté du processus de rappel, comme quand on a un mot « sur le bout de la langue ».

Le processus de rappel : l'activation diffusante

[modifier | modifier le wikicode]

Détaillons plus en détail le processus de rappel. La reconnaissance d'un indice l'active, et c'est là que le processus de recherche commence. L'activation se propage alors dans le réseau à travers les relations, ce qui peut déclencher le rappel des informations voisines. L'activation diffuse alors de proche en proche et active les concepts voisins de l'indice de récupération. Ce mécanisme s'appelle l'activation diffusante. Si une information est suffisamment activée par ses voisins, il est automatique rappelé. Et plus une information reçoit de l'activation en provenance de plusieurs relations, les activations propagées s'additionnent, facilitant d'autant plus le rappel ultérieur.

Pour résumer, les associations d'idées sont autant de routes qui permettent d’accéder à l'information, de s'en souvenir. Les indices de récupération sont les points de départ de l'activation diffusante, l'information à rappeler étant un des points d'arrivée. Si un concept n’est pas relié à d’autres, il sera totalement isolé dans la mémoire sémantique et ne sera pas accessible. À l'inverse, plus un concept est connecté à un grand nombre de voisins, plus il peut être rappelé facilement : chacun des voisins peut servir de voie d'accès. C'est ce qui explique que plus on donne d'indice, plus le rappel est facile : l'activation d'un indice supplémentaire ajoute de l'activation, favorisant le rappel.

Les mécanismes de l'oubli

[modifier | modifier le wikicode]Plus haut, j'ai dit que les performances sont souvent meilleures dans des tâches de rappel indicé que dans les tâches de rappel libre. La raison est que l'oubli n'est pas forcément lié à l'absence de l'information en mémoire, mais est souvent lié à son inaccessibilité. L'information est bien en mémoire, mais le processus de recherche d'une information en mémoire n'arrive pas à l'atteindre. Les indices de récupération ne permettent pas à l'activation d'arriver en quantité suffisante jusqu'au concept à rappeler. L'inaccessibilité d'une information en mémoire peut provenir de deux mécanismes : ou l'information n'a pas été reliée à beaucoup de voisins, ou elle interfère avec des informations voisines.

Le premier mécanisme fait appel à un encodage peu élaboré, léger, mal fait. Une information fortement intégrée dans un réseau de connaissances est facilement accessible. Des situations très diverses réussiront à activer les indices qui mènent à cette information, quand cela est pertinent. Plus les connaissances sont associées à un réseau sémantique touffu, rempli de connaissances et d'associations d'idées, plus le travail de l'activation est facilité et l'oubli rare. En comparaison, un réseau sémantique contenant peu de connaissances et de relations fera moins bien son travail, certaines informations étant peu accessibles. C'est pour cela que les connaissances abstraites sont facilement transférables dans de nombreuses situations. C'est parce qu'il s'agit de connaissances fortement intégrées dans le réseau mnésique, les rendant facilement accessibles, et donc adaptables/transférables, dans de nombreuses situations.

Le second mécanisme est le phénomène d'interférence, où une information parasite le souvenir d'une autre. Ces interférences ont lieu quand deux informations sont accessibles à partir des mêmes indices de récupération. Elles entrent alors en compétition pour le rappel et le cerveau va devoir choisir l’information à rappeler. Selon l'ordre d’apprentissage des informations interférentes, on distingue deux types d'interférences. L'interférence rétro-active remplace des connaissances anciennes par des connaissances plus récentes, alors que l'interférence pro-active fait que des connaissances anciennes gênent d'acquisition de nouvelles connaissances. La première permet de remplacer des connaissances erronées. Présenter les informations comme un ensemble de faits isolés favorise ce phénomène d'interférence, alors que les relier dans un cadre conceptuel général le diminue fortement.

Une mémoire verbale et une mémoire visuelle

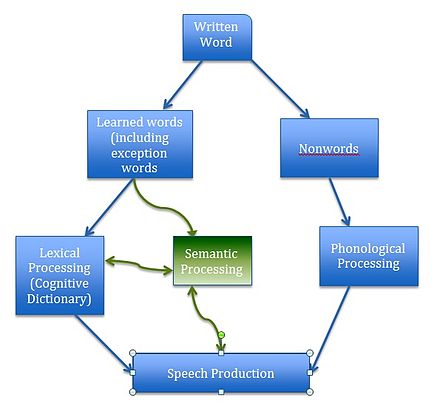

[modifier | modifier le wikicode]Certains chercheurs considèrent que la mémoire déclarative ne mémorise pas que des connaissances proprement dites, mais aussi des informations visuelles, auditives, etc. Par exemple, la théorie du double-codage stipule que la mémoire contiendrait un système verbal qui mémorise des connaissances verbales, et un système visuel qui mémorise des images mentales et des représentations visuelles.

Le système verbal serait lié au langage et mémoriserait des informations comme les mots, leur orthographe, mais aussi leur sens. Il serait formé d'un réseau d'informations interconnectées entre elles. Le système visuel mémoriserait des images abstraites, qui permettent de reconnaître les objets connus, les visages des personnes connues, etc. Les connaissances des deux systèmes seraient reliées entre elles par des associations référentielles, qui permettent de relier les concepts concrets avec leur image. Par exemple, il existe une liaison référentielle entre le concept "chat" et l'image d'un chat.

Cette théorie a été inventée pour expliquer les différences de mémorisation entre concepts concrets et abstraits. Expérimentalement, il est observé que les concepts concrets sont plus faciles à retenir que les concepts abstraits. Cela viendrait du fait que les concepts concrets sont généralement visualisables, contrairement aux concepts abstraits. On peut s'imaginer mentalement à quoi ressemble un chat, alors qu'il est plus difficile de donner une représentation des concepts de liberté ou de justice (pour lesquelles on doit utiliser des métaphores ou des analogies). Ainsi, les concepts concrets seraient mémorisés à la fois sous forme verbale et visuelle, tandis que les concepts abstraits le seraient uniquement dans le réseau verbal. La redondance des concepts concrets/imaginables les rendrait plus mémorables.

Et mine de rien, cette théorie donne des conseils assez utiles pour la création de supports pédagogiques. Le principe est de faire en sorte que les informations soient mémorisées à la fois dans la mémoire verbale et dans la mémoire visuelle, autant que possible. La conséquence est qu'utiliser des illustrations, dessins et schémas est une bonne pratique pédagogique. Évidemment, ce n'est pas possible pour les concepts abstraits, rétifs aux illustrations. Difficile de donner des schémas en cours de philosophie, par exemple. Mais beaucoup de concepts peuvent recevoir une représentation visuelle, et l'usage de schémas, de notations, de graphiques, et autres est clairement un atout. Nous détaillerons davantage ce conseil dans le chapitre consacré aux supports pédagogiques.

L'importance du stock de connaissances acquises sur les capacités intellectuelles

[modifier | modifier le wikicode]On vient de voir que notre mémoire est un gigantesque réseau qui interconnecte des unités de connaissances. Elle contient des connaissances très diverses : mots, connaissances concrètes, images mentales, concepts, catégories d'objets/évènements, propositions, etc. Et ces unités de connaissances sont reliées entre elles par des associations d'idées, des liens logiques, des connexions très diverses. Faire une cartographie des types unités de connaissances et des types de connexion est possible, mais nous n'allons pas le faire maintenant. À la place, nous allons voir en quoi ce fonctionnement en réseau est utile dans notre vie intellectuelle. En quoi cette organisation en réseau est impliquée dans la mémoire, la compréhension orale/écrire, le raisonnement, la résolution de problèmes, etc.

Les connaissances antérieures facilitent l'apprentissage

[modifier | modifier le wikicode]Lorsque l'on apprend de nouvelles connaissances, il se passe toujours la même chose. Les connaissances à apprendre sont d'abord stockées temporairement en mémoire de travail. Là, elles vont alors être associées et connectées entre elles. De plus, et c'est beaucoup plus important, elles vont aussi être connectées à des connaissances antérieures, déjà présentes en mémoire à long-terme. Évidemment, ces associations ne se font pas n'importe comment. Les connaissances se connectent si elles se ressemblent, si elles ont un lien logique entre elles, si elles partagent un élément en commun, etc. Toujours est-il que ces connexions ont quelque chose de logique, elles ont un sens plus ou moins explicite. Et ce sont ces associations qui vont arrimer les connaissances à apprendre en mémoire à long-terme. Apprendre, c'est faire des liens.

A ce propos, plus un élève a de connaissances antérieures, plus il pourra créer d'associations lors de l'apprentissage. Apprendre beaucoup de choses donne une bonne base aux apprentissages futurs[1][2]. Pour le dire autrement, l'apprentissage est un processus cumulatif dans lequel le savoir appelle le savoir. Plus on sait de choses, plus on pourra facilement relier de nouvelles informations à des connaissances antérieures. Une grande partie des mauvais résultats des élèves provient du fait qu'ils n'ont pas assez connaissances antérieures, ce qui ne permet de former beaucoup de connexions. Ce fait est bien illustré par le fait que les résultats scolaires sont bien corrélés aux savoirs acquis, bien plus qu'au QI ou toute autre mesure des capacités cognitives. Pour donner quelques chiffres, une étude d'Alain Lieury nous dit que la corrélation entre connaissances encyclopédiques en classe de 5ᵉ et résultats scolaire l'année suivante est d'approximativement 0,72. La corrélation est la même avec le taux de redoublement 4 ans plus tard. Notons que ces deux corrélations sont plus élevées que les corrélations avec les tests de QI ou de raisonnement (0,50)[3].

Mais alors, qu'en est-il du par cœur, représentation iconique de l'acte de mémoriser ? Difficile d'interpréter cela comme un processus d'association. Quand on apprend des informations par cœur, on n'a pas l'impression de former de nouvelles associations à chaque répétition. Certes, les scientifiques ont observé divers phénomènes qui leur font penser que l'apprentissage par cœur implique malgré tout des phénomènes d'association, mais ceux-ci ne suffisent pas à expliquer pourquoi la répétition marche. En clair, les études scientifiques ont montré que la répétition est une bonne chose pour la mémoire, sans forcément que cela implique la formation de nouvelles associations. La répétition consolide les associations préexistantes, elle les renforce pour les rendre plus efficaces. Mais toutes les formes de répétition ne se valent pas. Nous passerons un chapitre complet sur les méthodes de révision et nous verrons que relire ses cours ou apprendre par cœur n'est pas la méthode la plus efficace pour cela. Certes, apprendre par cœur marche, mais d'autres méthodes fonctionnent bien mieux. Et ces méthodes forcent les élèves à former de nouvelles connections, à donner un sens à ce qui doit être appris. Les procédés mnémotechniques en sont un bon exemple : ils permettent d'associer ce qu'il faut apprendre à des choses connues, ils permettent d'imposer du sens à du matériel qui n'en a pas. Mais on pourrait aussi citer d'autres méthodes : faire un résumé de son cours, poser des questions de réflexion sur son cours, compléter son cours avec des informations extérieures, etc. Difficile d'échapper au fait que la mémoire fonctionne par association.

Les connaissances sont importantes pour la compréhension orale/écrite

[modifier | modifier le wikicode]Le mécanisme d'association décrit précédemment est aussi à la base de la compréhension de texte ou de discours. Quand on lit un texte, les phrases sont traduites dans une représentation mentale qui contient le sens de la phrase : une proposition. Les dernières propositions lues sont mémorisées temporairement en mémoire de travail et sont connectées entre elles, si elles ont un lien logique. Le résultat est ensuite mémorisé en mémoire à long-terme, qui contient un réseau de propositions qui regroupe toutes les informations du texte et les liens qu'elles ont entre elle. Ce dernier est appelé la base de texte. Jusque là, rien d'étonnant, on se doute que le texte lu/écouté est mémorisé en passant par la mémoire de travail et que le lecteur/auditeur connecte les informations du texte entre elles.

Mais les propositions du texte ne sont pas connectées que entre elles. Elles sont aussi connectées avec les connaissances en mémoire à long-terme. L'ensemble des informations du texte, les connaissances antérieures reliées et les connexions entre tout cela forme un gigantesque réseau de propositions, appelée le modèle de situation. Ce dernier contient un grand nombre de connexions, d'inférences, d'associations d'idées qui ne sont pas dans le texte, mais qui ont été créés grâce aux connaissances antérieures. Plus ce réseau est dense, complexe, riche en connexions et informations, plus le lecteur aura compris en profondeur le texte. La différence entre un lecteur qui aura juste mémorisé les informations du texte et celui qui a associé celles-ci à un stock de savoir conséquent se voit facilement dans les expériences de compréhension de texte. Si on fait lire un texte sur la vitamine D, les personnes qui ont des bases en biologie feront plus de connexions et donc d'inférences que ceux qui n'en ont pas. Et cela se verra quand on leur demandera de réfléchir sur le texte lu, quand on leur posera des questions de compréhension, etc.

Les inférences à partir des connaissances antérieures permettent aussi de combler l'implicite qui est naturellement présente dans certains textes. Toute personne qui écrit un texte explicatif l'écrit pour un certain public, qui est censé avoir certaines connaissances. Ce faisant, le rédacteur ne mentionne pas certaines informations, qui sont importantes pour la compréhension du texte, mais qui sont supposées sues du lecteur. Un bon moyen de s'en rendre compte est de lire un texte sur des sujets qu'on ne connait pas du tout et pour lesquels on n'a pas les bases. Même si le vocabulaire est connu, on aura du mal à comprendre un tel texte, car il nous manquera le savoir implicite qui est attendu du lecteur. Mais on peut l'illustrer avec un autre exemple. Prenez cette phrase, par exemple :

- Je l'ai cru quand il m'a dit qu'il avait une maison au bord du lac Léman, mais je me suis rendu compte qu'il mentait quand il m'a dit qu'il péchait dans le lac à marée basse.

Pour comprendre cette phrase, il faut savoir qu'il n'y a pas de marées dans un lac (pour être précis, les marées dans le Lac Léman sont de quelques millimètres, tout au plus). L'information n'est pas marquée dans le texte, mais le rédacteur de la phrase a supposé que le lecteur connaissait cette information. Et ce phénomène se rencontre énormément dans les textes explicatifs. Un bon moyen de s'en rendre compte est de faire lire un journal quotidien généraliste à un enfant. L'enfant n'a pas les connaissances en géographie et en politique nécessaire pour comprendre les articles, même si le vocabulaire est là.

Les connaissances sont le fondement de l'expertise

[modifier | modifier le wikicode]Les connaissances sont très importantes pour devenir un expert dans un domaine. Rien d'étonnant à cela, tant il va de soi qu'un expert a accumulé une grande quantité de connaissances dans son domaine de compétence. Mais on pourrait aussi penser que les experts ont acquis des capacités de réflexion ou des compétences générales bien précises qui peuvent se transférer à d'autres domaines. Les études scientifiques sur ce qui s'appelle le transfert d'apprentissage montrent qu'il n'en est rien. Elles montrent que les experts sont bons dans leur domaine de compétence, mais qu'ils ont les mêmes résultats que les novices dans d'autres domaines, même proches. Les quelques rares cas où un expert a de meilleures performances dans un autre domaine sont ceux où il peut réutiliser ses connaissances directement. Par exemple, un mathématicien sera meilleur en physique qu'un novice, mais c'est parce qu'il peut réutiliser ses connaissances mathématiques en physique.

Les expériences sur l'expertise, à savoir la compétence supérieure qu'ont les experts dans un domaine, ont étudié les joueurs d'échecs, les compétences en développement informatique, en passant par les capacités de diagnostic médical, l'expertise tactique des joueurs professionnels de sports collectifs, l'expertise pédagogique des professeurs de physique, etc. Et elles convergent toutes sur un point : les capacités supérieures des experts dans leur domaine dépendent presque uniquement de leur stock de connaissances acquises. Si un expert est capable de mieux réfléchir qu'un novice dans son domaine de compétence, c'est parce ses connaissances acquises lui permettent d'utiliser des méthodes de raisonnement efficaces que les novices ne peuvent pas utiliser. Par exemple, les experts raisonnent beaucoup par analogie, là où les novices procèdent par essais et erreurs. Les experts se ramènent systématiquement à des situations connues et des classes de problèmes maîtrisés. Mais ces méthodes de raisonnement par analogie ne fonctionnent pas à vide. Elles demandent que l'expert ait fait siens un grand nombre de connaissances, d'exemples, de problèmes résolus. De plus, ces méthodes de raisonnement sont utilisables par les experts pour deux raisons.

Premièrement, les connaissances des experts sont particulièrement organisées. Elles sont fortement reliées entre elles et sont aussi connectées à de nombreuses connaissances concrètes comme des exemples, des situations vécues d'expériences, des problèmes déjà résolus, etc. Les connaissances d'un expert ne se résument pas en un simple catalogue de concepts abstraits, mais sont de véritables réseaux de connaissances, riches aussi bien en savoirs qu'en liens logiques pour les relier. Et il va de soi que plus les connaissances enseignées le sont d'une manière structurée, organisée, plus l'apprentissage par l'élève sera efficace. Comme indice qui tend à valider cette hypothèse, on peut citer l'étude de Sexton et Poling (1973) : celle-ci montre que les élèves qui ont de mauvais résultats voient ce qu'on tente de leur apprendre comme un ensemble de connaissances séparées, non-reliées, non-structurées, alors que les élèves avec de bons résultats relient celles-ci et les intègrent dans des structures, des classifications, des analogies.

De plus, les connaissances des experts peuvent s'appliquer à un grand nombre de situations, là où celles des novices sont trop précises et pointues. Le savoir des personnes expertes est générale, abstrait et flexible. Il prend le plus souvent la forme de catégories d'objets ou de situations, qui permettent de faire des inférences et des déductions. Pour en donner un exemple, on peut citer la fameuse étude de Chi et al. (1981). Dans celle-ci, les expérimentateurs à des experts (des professeurs de physique) et des novices (des étudiants en début de cursus) de catégoriser des exercices de physique. Leur étude a montré que les novices ont tendance à fonder leurs analyses sur des détails présents dans l'énoncé (coefficients numériques, vocabulaire utilisé, ...), alors que les experts ont tendance à penser en fonction d'idées générales et de principes abstraits (la loi de conservation de l'énergie, la quantité de mouvement, ...). Au fur et à mesure que les étudiants progressent dans leurs études, ils classent de plus en plus ces exercices en fonction des caractéristiques générales. Le but de l'apprentissage est donc de permettre à l'élève d'acquérir des concepts généraux, qui se rapportent à un large spectre de situations, seules connaissances réellement « rentables ».

Si les experts ont acquis de nombreuses connaissances différentes, la recherche dans le domaine a mis l'accent sur un type particulier de connaissances abstraites : les schémas. Définir ce qu'est un schéma, au sens de la psychologie cognitive, est assez compliqué, car ce terme regroupe des acceptations diverses. Ici, nous allons définir un schéma comme une construction mentale qui permet de reconnaître toute une classe de problèmes semblables, qui se résolvent avec la même procédure. Les schémas permettent de classer les problèmes en fonction de la manière dont on les résout, et non sur d'autres critères. De plus, ces schémas ne sont pas que ces catégories, mais ils sont reliés à la méthode de résolution, la procédure à appliquer. Quand on les met face à un problème dans leur domaine, les experts vont simplement reconnaître que le problème présenté colle à un type de problème familier et récupérer la procédure associée. Au pire, ils vont découper le problème en sous-problèmes connus, qu'ils savent résoudre. Les schémas permettent cette reconnaissance rapide du type de problème à résoudre.

Les connaissances sont la base de la créativité et de l'imagination

[modifier | modifier le wikicode]L'organisation en réseau de la mémoire joue aussi un grand rôle dans la résolution de problèmes, le raisonnement et la créativité. Prenons l'exemple de la créativité. Comme le disait Steve Jobs :

« creativity is just connecting things (La créativité consiste juste à connecter des choses entre elles). »

Il faut dire qu'engendrer une chose originale demande systématiquement de la fabriquer à partir de connaissances antérieures : les idées ne naissent pas de nulle part ! Imaginer quelque chose consiste juste à activer les bonnes informations en mémoire pour les associer, ce qui implique fatalement une recherche des informations pertinentes en mémoire, via l'activation diffusante.

Mais dans le cas de la créativité, les associations formées relient des concepts lointains, éloignés dans le réseau sémantique, qui partagent peu de propriétés. Être créatif demande donc de passer outre les associations les plus évidentes, pour se concentrer sur des associations éloignées, rares, incongrues. Diverses études ont tenté de mesurer les connexions formées dans les tests de créativité simple. Et le résultat conforte l'intuition : les associations formées dans les tests de créativité relient des informations ou concepts éloignés.

La mémoire de travail et la charge cognitive

[modifier | modifier le wikicode]Si la mémoire à long terme est très importante en milieu scolaire, il ne faut pas oublier le rôle déterminant de la mémoire de travail. Pour rappel, cette mémoire maintient à l'esprit, durant une dizaine de secondes, une quantité limitée d'informations. L'idée principale est qu'elle a une capacité limitée à environ 4 informations. Or, la mémoire de travail est fortement utilisée quand il s'agit de réfléchir, peu importe que l'on doive réfléchir pour comprendre un texte, résoudre un problème, raisonner sur la base d'informations contrefactuelles, ou autre. Toute réflexion manipule des items en mémoire de travail et relie ces derniers pour former une nouvelle combinaison. Lors d'un apprentissage, les informations à apprendre sont maintenues en mémoire de travail, afin d'être associées et reliées à des connaissances antérieures, et afin de faire des déductions. La mémoire de travail est donc primordiale pour l'apprentissage et nous devons en parler en détail.

La charge cognitive

[modifier | modifier le wikicode]Des informations trop complexes font saturer la mémoire de travail, perturbant la réflexion et/ou l'apprentissage, contrairement à des informations simples. Pour prendre un exemple, c'est ce qui fait qu'un calcul trop compliqué est souvent un calcul qui demande de maintenir temporairement trop de résultats temporaires. Par exemple, c'est ce qui fait que vous aurez du mal à résoudre le calcul suivant de tête, vu que votre mémoire de travail ne peut pas stocker tous les résultats temporaires nécessaires pour mener à bien ce calcul :

4565 * 891

De plus, les informations à mémoriser ne sont pas les seules à utiliser la capacité de la mémoire à court terme : les relations qu'elles entretiennent entre elles vont aussi prendre de la place en mémoire de travail. Par exemple essayez de dire si la phrase suivante est vraie ou fausse :

Le grand-père des frères de mon père est-il le fils du frère de mon grand-père ?

Difficile, non ? C'est parce le nombre d’éléments et de relations qu'ils entretiennent est supérieur à ce que peut supporter la mémoire de travail.

Pour résumer, plus une information à apprendre ou une situation à comprendre est composée d'un grand nombre de sous-éléments, plus elle aura tendance à saturer la mémoire de travail. Le nombre d’éléments présents en mémoire de travail s'appelle la charge cognitive : plus elle est élevée, moins la tache ou le concept abordé est facile.

En situation d'apprentissage, la charge cognitive va de très faible pour certaines tâches à très élevée pour d'autres. Pour donner un exemple, apprendre du vocabulaire ou une notation technique ne demande pas une charge cognitive élevée. Par exemple, apprendre que le cuivre se note Cu en chimie, que le mot anglais "useless" veut dire "inutile" en français, sont autant d'apprentissage qui ne demande pas une charge cognitive élevée. Cela ne veut pas forcément dire que ce soit facile, vu qu'il existe des tâches à faible charge cognitive qui sont malgré tout difficiles. Par contre, les situations à forte charge cognitive, dans lesquelles beaucoup d'informations sont reliées entre elles, sont systématiquement plus difficiles. Typiquement, les situations d'apprentissage par cœur de vocabulaire, de notations, de définitions ou de formules, ont une charge cognitive faible. Par contre, comprendre quelque chose implique souvent une charge cognitive élevée.

La charge cognitive est une des raisons qui fait que faire plusieurs choses en même temps est rarement une bonne idée. Contrairement à ce que certains peuvent penser, l'esprit humain n'est pas vraiment conçu pour le multitâche. Vous serez moins performant si vous téléphonez en conduisant, si vous faites vos devoirs en écoutant de la musique ou la télévision, etc. La raison est que si vous essayez de réaliser deux tâches en même temps, la mémoire de travail sera utilisée par les deux tâches. Chaque tâche a sa propre charge cognitive, elle a besoin de maintenir un certain nombre d'items à traiter dans la mémoire de travail. Les charges cognitives des deux tâches vont donc s'additionner, mais la capacité de la mémoire de travail reste la même. En conséquence, la mémoire de travail surcharge, réduisant drastiquement les performances. Et cela aura des conséquences dans la suite du cours, certaines situations d'apprentissage étant techniquement des situations de double tâche, à savoir que votre esprit doit faire deux choses en même temps. Mais laissons cela pour plus tard.

Les connaissances antérieures et l’entraînement influencent la charge cognitive

[modifier | modifier le wikicode]Les limites de la mémoire à court terme semblent s’évanouir quand on est face à une situation familière. Par exemple, les experts dans un domaine peuvent retenir de grandes quantités d’informations, bien au-delà de la capacité de la mémoire de travail. Cela vient du fait que les experts ont acquis de grandes quantités de connaissances en mémoire à long-terme, qu'ils utilisent pour réduire leur charge cognitive. La première raison est que si la mémoire de travail ne peut traiter que quelques données simultanément, la taille de ces données ne semble pas être limitée. Or, les experts ont mémorisé des motifs familiers qui permettent de combiner plusieurs items en un seul, alors qu'un novice n'a pas acquis ces motifs et doit se débrouiller avec des informations élémentaires qu'il doit traiter individuellement. La seconde est qu'ils ont appris à automatiser certaines manipulations, à savoir que leur entraînement leur permet de faire certaines manipulations sans utiliser de mémoire de travail.

Le chunking, la capacité de reconnaître des regroupements

[modifier | modifier le wikicode]Nous allons introduire cette section par un exemple. Prenez la suite de lettres suivante :

XON UCF FTF BIC IAS NCF

Si je vous demande de me restituer cette liste de lettre immédiatement après l'avoir lu, sans vous laisser la possibilité de la relire ou de vous entraîner, vous devriez pouvoir mémoriser 7 lettres environ. Maintenant, réorganisez les lettres comme suit :

X ONU CFDT FBI CIA SNCF

Cette fois-ci, vous arrivez à vous souvenir de toutes les lettres, du moins en moyenne. La raison est que vous n'allez pas mémoriser les lettres individuelles, mais les abréviations. Chaque abréviation sera prise comme un seul item en mémoire de travail. Là où vous deviez mémoriser 18 lettres sans regroupement, sans abréviation, vous n'avez plus que 5 abréviations et une lettre à mémoriser, ce qui fait que vous n'aurez aucun mal à tout mémoriser. Cela ne marche cependant que parce que vous connaissez les abréviations et que vous pouvez les utiliser. Faite l’expérience avec un enfant de 5 ans, qui ne connaît pas ces abréviations et qui ne sait pas ce qu'elles veulent dire, et vous n'aurez pas le même résultat. À la place, l'enfant ne pourra mémoriser que quelques lettres dans les deux cas, guère plus.

L'expérience précédente est certes simple, mais elle illustre à merveille un phénomène appelé chunking. Ce terme est traduit en français par le terme "regroupement", mais le chunking est en réalité différent d'un simple regroupement. En réalité, il s'agit plus de la reconnaissance d'un motif connu et familier, qui est déjà en mémoire à long-terme. Comme exemple, on peut citer l'exemple de l'apprentissage de la géométrie. L'étude de Koedinger et Anderson, datée de 1990 montre que les élèves qui ont de bonnes performances en géométrie ont acquis des regroupements visuels qui leur permettent de reconnaître des figures géométriques particulières (triangles, carrés, angles alternes-internes, etc). Et ces regroupements ne permettent pas de reconnaître des figures dans un schéma, mais permettent aussi de récupérer les informations associées à ces figures, comme la formule de calcul de leur surface, ou certains théorèmes (comme le théorème des angles alternes-internes pour certaines configurations de droites). Ainsi, la capacité à résoudre certains exercices de géométrie dépend en partie de cette capacité à reconnaître des configurations et les informations associées.

On peut aussi citer l'exemple des joueurs d'échec auxquels on demande de mémoriser une configuration de jeu. Un joueur d'échec expert a tendance à mémoriser 4 à 5 fois plus de pièces qu'un novice. La raison à cela est que les novices doivent mémoriser des pièces indépendantes, tandis que les experts reconnaissent des blocs de 3 à 5 pièces qui leur sont familiers. Mieux : ces regroupements sont associés à des informations stratégiques, chaque regroupement étant associé aux meilleurs coups à jouer associés à cette configuration. Notons que l'avantage mnésique des joueurs experts ne vaut que pour des configurations de jeu rencontrées fréquemment. Ils ont des performances similaires à celles des novices pour des configurations de jeu aléatoires. Ce qui prouve bien que les joueurs d'échecs experts reconnaissent des motifs familiers, ils ne créent pas des regroupements de toute pièce.

Pour donner un dernier exemple, on peut prendre les recherches d'Egan and Schwartz, datées de 1979. Ces expériences comparaient les performances entre des spécialistes en électroniques et des novices. Les sujets devaient mémoriser un circuit électronique qui leur était présenté durant quelques secondes. Tandis que les novices se rappelaient de chaque pièce indépendamment, les experts se rappelaient d'ensembles de pièces assez conséquents, chacun de ces ensembles ayant un sens. Par exemple, les experts regroupaient un ensemble de résistances électriques, condensateurs, et bobines dans un sous-circuit qui correspond à un amplificateur de tension ou un amplificateur de courant. Dans cette situation, le regroupement était une catégorie d'objet, à savoir un amplificateur de tension, ou autre.

Les exemples précédents portent sur des regroupements divers. Les regroupements les plus simples portaient autrefois le nom de chunks, mais ce terme est surtout utilisé pour des tâches de mémorisation simples. Pour des tâches plus complexes, les regroupements sont beaucoup plus élaborés et ont une nature purement conceptuelle, au point qu'on ne peut pas les qualifier de regroupements ou de motifs. De tels regroupements sont appelés des schémas, le terme étant réutilisé pour nommer ces regroupements en plus de son sens vu auparavant. Les schémas correspondent ici à des concepts, des connaissances abstraites, des catégories d'objets ou d'évènements. Loin d'être de simples regroupements, les schémas encapsulent les liens logiques et associations entre les informations regroupées. Ce sont de véritables constellations d'informations interconnectées entre elles. De plus, ils ont une organisation hiérarchique : chaque schéma peut contenir des schémas plus élémentaires, qui sont eux-mêmes potentiellement constitués de sous-schémas, et ainsi de suite. Pour résumer :

- un schéma est une abstraction qui mémorise ce qui est commun à plusieurs objets ou situations, comme une catégorie ;

- un schéma relie plusieurs concepts simples et unifie le tout en un seul concept complexe ;

- le schéma contient les relations logiques et les associations d'idées que ses éléments entretiennent entre eux ;

- un schéma a une organisation plus ou moins hiérarchique où chaque schéma peut lui-même contenir des schémas plus élémentaires, qui sont eux-mêmes potentiellement constitués de sous-schémas, et ainsi de suite.

L’entraînement réduit la charge cognitive en automatisant certaines procédures

[modifier | modifier le wikicode]Le processus de regroupement permet de réduire la charge cognitive en regroupant plusieurs items en un seul, libérant ainsi de la place en mémoire de travail. Mais ce n'est pas le seul processus qui permet d'économiser de la mémoire de travail. Il faut aussi lui ajouter l'automatisation. Ce terme barbare désigne le fait que certaines procédures deviennent de plus en plus efficaces avec l’entraînement. Comme exemple de la vie courante, pensez à la conduite, l'apprentissage du calcul mental, la lecture, l'écriture.

Prenons par exemple un élève auquel on apprend une procédure de calcul mental complexe. Au début, il va mettre beaucoup de temps pour faire des calculs simples, et fera beaucoup d'erreurs. L'application de la procédure est lente, utilise la mémoire de travail, est contrôlée consciemment, et requiert toute l'attention du sujet. Mais avec de l’entraînement, il arrivera à faire des calculs extrêmement complexes, sans pour autant faire d'erreurs. La raison à cela ne tient pas dans le phénomène de regroupement, mais dans le fait que l'élève sera capable d'appliquer la procédure en utilisant de moins en moins de mémoire de travail. On dit que la procédure s'automatise : elle devient plus rapide, utilise peu de mémoire de travail, ne requiert plus d'attention et n'est plus contrôlable consciemment.

Ce phénomène d'automatisation peut s'expliquer de plusieurs manières. Mais la principale, celle qui va nous intéresser, est liée à la mémoire. L'automatisation se produit quand le sujet acquiert des connaissances qui lui permettent de prendre des raccourcis. Par exemple, au lieu d'appliquer une procédure longue et avec beaucoup d'étape, le sujet va sauter des étapes, voire utiliser une procédure plus simple qui ne marche dans des cas particuliers. Une autre possibilité est que le sujet peut directement récupérer le résultat depuis sa mémoire, sans avoir à réfléchir pour trouver la solution. Prenons par exemple le cas du calcul mental. Les spécialistes en calcul mental sont capables de multiplier deux nombres à 6 chiffres sans erreur et très rapidement. Cela peut paraître surprenant, mais cela l'est moins quand on sait qu'ils connaissent leurs tables de multiplication pour tous nombres à deux chiffres, là où le commun des mortels ne connaît que les tables de 0 à 10. Cela permet de grandement réduire le nombre d'étapes de calcul. Par exemple, pour multiplier 8546 par 1254, ils n'ont besoin que de combiner les résultats de 85*12, 85*54, 46*12 et 46*54.

Les liens entre expertise et charge cognitive

[modifier | modifier le wikicode]Si on analyse la manière de réfléchir de nombreux experts dans divers domaines, on voit que leur vaste répertoire de connaissances leur permet d'utiliser le regroupement dans des situations très variées. De plus, l'expertise passe par l'automatisation de certaines procédures. Automatisation et regroupement permettent aux experts de faire de la place dans leur mémoire de travail, ce qui libère de la place pour la réflexion. Cette constatation a été vérifiée dans une grande quantité de domaines différents, comme l'expertise médicale, la programmation, la conception de circuits électronique, ou l'expertise mathématique. Les exemples de la section précédente, avec les joueurs d'échecs ou l'analyse de schémas électronique en est un exemple. Mais on en a d'autres, comme pour la compréhension de programmes informatiques ou l'expertise des contrôleurs aériens.

Les différences de performances entre experts et novices proviennent en partie de la mémorisation d’un grand nombre de schémas spécifiques à ce domaine. Comme le dit Mislevy :

« […] comparés aux novices, les experts dominent plus de faits et établissent plus d’interconnexions ou de relations entre eux. Ces interconnexions permettent de surmonter les limitations de la mémoire à court terme. Alors que le novice ne peut travailler qu’avec au maximum sept éléments simples, l’expert travaille avec sept constellations incarnant une multitude de relations entre de nombreux éléments. »

Par exemple, les expériences de Yntema et Mueser montrent que des contrôleurs aériens experts ne peuvent pas faire de regroupements dans des tâches de laboratoires déconnectées de leur expertise : leur mémoire de travail reste limitée à 7 informations en moyenne. Mais les études de Bisseret montrent que pour des tâches liées à leur domaine d'expertise, les contrôleurs aériens peuvent mémoriser jusqu’à 20 voire 30 informations dans leur mémoire de travail. En réalité, ces 20 à 30 informations correspondent à 4/5 regroupements d'informations.

Les liens entre charge cognitive et apprentissage

[modifier | modifier le wikicode]Plus la capacité de la mémoire de travail est élevée, plus l'élève peut faire de connexions et d'inférences. C'est notamment le cas pour la compréhension de la transitivité par les enfants de 4 à 6 ans : les enfants ont souvent du mal à comprendre cette notion et à l'appliquer parce que leur mémoire de travail est trop faible. Il faut dire que comprendre la transitivité A -> B -> C demande de maintenir en mémoire de travail A, B, C, et les relations A->B, et B->C : cela fait beaucoup pour un enfant dont la mémoire de travail est très nettement inférieure à celle des adultes. Et à ce petit jeu, les enfants qui ont une mémoire de travail de plus grande capacité que leurs camarades ont nettement plus de facilité à comprendre la transitivité. De nombreuses expériences ont d'ailleurs relié l'évolution de la pensée chez l'enfant avec la capacité de la mémoire de travail[4].

Le lien avec l'apprentissage est évident, au regard de ce qu'on a appris sur la mémoire déclarative. Si la mémoire de travail est utilisée pour faire des associations et des liens logiques, alors elle a un grand rôle dans la mémorisation et la compréhension, ces deux processus demandant de former des connexions. En conséquence, si une tache d'apprentissage sature la mémoire de travail, l'apprentissage se passe mal, voire n'a pas lieu. Pour le dire autrement, la mémoire de travail est la porte d'entrée de la mémoire à long terme. Toute information doit passer en premier lieu par la mémoire de travail pour y être reliée à des connaissances antérieures. Il s'agit de la première limitation de la mémoire de travail sur l'apprentissage : si la mémoire de travail sature, l'apprentissage se passe mal, voire pas du tout. Il n'est donc pas étonnant que quelques études aient montré que la réussite scolaire est fortement corrélée à la capacité de la mémoire de travail. Par exemple, la capacité de la mémoire de travail à 5 ans est un bon indicateur de la réussite scolaire ultérieure [5]. De même, il existe une forte corrélation entre faible capacité de la mémoire de travail et échec scolaire[6].

Les méthodes pédagogiques ne sont pas égales en termes de charge cognitive

[modifier | modifier le wikicode]La mémoire de travail est donc très importante lors de l'apprentissage. Idéalement, on aimerait trouver des solutions pédagogiques pour la réduire afin d'améliorer les performances d'apprentissage. Ce constat remet sur le devant de la scène une théorie pédagogique assez ancienne : la théorie de la charge cognitive. Créée par Sweller dans les années 1970, cette théorie a reçu de nombreuses vérifications expérimentales. Assez mal connue en France, elle commence à avoir une grande influence dans les pays anglo-saxons. Plusieurs chapitres de ce cours lui seront dédiés.

Par ailleurs, certaines pratiques pédagogiques ne tiennent pas compte la mémoire de travail. Les pédagogies actives, dans lesquelles l'élève doit réfléchir de manière autonome et découvrir le savoir à apprendre, sont une catastrophe de ce point de vue. Et ce pour plusieurs raisons. En premier lieu, elles demandent explicitement que l'élève soit mis face à des situations complexes dès le début de l'apprentissage. Ensuite, elles ont intrinsèquement une charge cognitive plus élevée, à situation équivalente. Prenons l'exemple des pédagogies par problèmes, où les élèves sont mis en face d'un problème complexe dont ils doivent découvrir un savoir spécifique pour le résoudre. Pour simplifier, elles placent les élèves en situation de double tâche : les élèves doivent réfléchir pour "résoudre le problème" et apprendre en même temps. La résolution du problème a une charge cognitive qui s'additionne à celle utile pour l'apprentissage. Et cela entraîne une charge cognitive supérieure à une situation d'apprentissage seule. Les études expérimentales sur le sujet montrent clairement que ces pédagogies ont des résultats inférieurs aux autres [7][8].

Les trois types de charge cognitive : intrinsèque, pertinente et inutile

[modifier | modifier le wikicode]Lorsque l'on soumet un élève face à un apprentissage quelconque, sa mémoire de travail va être occupée par divers items qu'il va relier entre eux et connecter avec des connaissances antérieures. Cependant, il arrive que des items inutiles pour l'apprentissage soient présents en mémoire de travail. Cela arrive si la présentation des informations est mal structurée, ou contient des détails superflus. Cela peut aussi arriver si certains items sont déjà connus de l'élève ou qu'ils sont redondants. D'un autre côté, certains items ne sont pas nécessaires, mais ils améliorent l'apprentissage malgré tout. Dans diverses situations, rajouter certains items bien précis permet de faciliter l'apprentissage si la charge cognitive ne fait pas déborder la mémoire de travail.

Tout cela pour dire qu'on doit distinguer trois types de charge cognitive :

- La charge cognitive intrinsèque : la charge cognitive minimale, obligatoire pour que l'apprentissage ait lieu.

- La charge cognitive pertinente : les informations facultatives, qui améliorent l'apprentissage si on les ajoute.

- La charge cognitive superflue : la charge cognitive superflue qui occupe la mémoire de travail pour inutilement.

- On peut aussi utiliser les termes charge intrinsèque, charge essentielle et charge extrinsèque.

Les charges cognitives intrinsèque et pertinente sont utiles pour l'apprentissage, la superflue ne l'est pas. Idéalement, on doit réduire la charge cognitive superflue au minimum, tout en laissant le reste inchangé. Pour le moment bornons-nous à dire que réduire la charge superflue est une solution plus simple à appliquer que celles qui réduisent la charge intrinsèque.

Réduire la charge cognitive superflue demande de supprimer les informations inutiles pour l'apprentissage, mais déceler ces informations inutiles est souvent compliqué. Un premier conseil est d'éliminer les détails et d'aller à l'essentiel. Une expérience faite par Richard Mayer permet d’illustrer ce phénomène. L’expérience a comparé deux versions d’un texte scientifique, dont l’une était expurgée des informations quantitatives : cette dernière était nettement mieux retenue et comprise. Un autre conseil est d'éviter ce qui s'appelle les détails séduisants. Les détails séduisants sont définis comme des détails qui sont ajoutés pour rendre un cours plus motivant, plus interactif, mais qui n'ont pas un lien direct et manifeste avec le sujet de la leçon. Par exemple, ce peut être des illustrations superflues qui sont placées dans un texte, mais sans pour autant compléter son contenu. Même chose pour des animations décoratives sur un site web d'apprentissage en ligne, ou autres. De nombreuses expériences en compréhension de texte ont montré que de tels détails nuisent à la compréhension et font baisser les performances d'apprentissage, en partie par ce qu'ils augmentent la charge cognitive, en partie parce qu'ils perturbent les processus d'association et de connexion avec les connaissances antérieures.

Il est possible de modifier la charge intrinsèque en utilisant efficacement les processus de regroupement/chunking et l'automatisation. Pour l'utilisation du regroupement, l'idée est d'organiser les connaissances à apprendre de manière à permettre des regroupements. Idéalement, il faut segmenter le cours en unités de petite taille qui sont assemblées pour donner des concepts de plus en plus complexes. Le plan du cours, ou du moins son organisation, est donc organisé de manière hiérarchique, où chaque concept est vue comme une pièce d'un grand tout. Obtenir une telle organisation n'est cependant pas facile, organiser un cours de manière à profiter du regroupement est compliqué et demande de l'expérience. Nous aurons un chapitre entier dédié à cette problématique.