Systèmes sensoriels/Système Visuel

Introduction

Système auditif

Système vestibulaire

Système somatosensoriel

Système olfactif

Système gustatif

Introduction

[modifier | modifier le wikicode]De manière générale, les systèmes visuels s'appuient sur les ondes électro-magnétiques (EM) pour donner à un organisme plus d'informations sur son environnement. Ces informations pourraient porter sur les partenaires potentiels, les dangers et les sources de subsistance. Différents organismes ont différents constituants qui composent ce que l'on appelle un système visuel.

La complexité des yeux va du simple ocelle, qui n'est rien de plus qu'une collection de cellules photosensibles, à un « objectif d'appareil photographique » à part entière. Un organisme qui possède différents types de cellules photosensibles ou de cellules sensibles à différentes gammes de longueurs d'onde est théoriquement capable de percevoir diverses couleurs ou au moins des différences de couleur.

La polarisation, une autre propriété du rayonnement électromagnétique, peut être détectée par certains organismes, les insectes et les céphalopodes ayant la plus grande précision.

Dans ce texte, l'accent a été mis sur l'utilisation des ondes EM dans la vision. Certes, certains organismes ont mis au point d'autres moyens de voir ou d'ajouter à ce qu'ils voient des informations extra-sensorielles, comme les baleines ou les chauves-souris qui utilisent l'écho-localisation pour percevoir leur environnement, mais nous choisirons d'exclure ces techniques de notre étude. En effet, vision et visuel sont les mots les plus souvent associés aux ondes électromagnétiques de la gamme des longueurs d'onde visuelles, qui est habituellement définie comme celle de la vision humaine. Étant donné que certains organismes détectent les ondes électromagnétiques avec des fréquences inférieures et supérieures à celles de l'homme, une meilleure définition doit être établie.

Nous choisirons ici de définir la gamme de longueurs d'onde visuelles comme celles qui sont comprises entre 300 nm et 800 nm. Cela peut sembler arbitraire mais nous pouvons ainsi inclure la vision de certains oiseaux dans le spectre choisi. De plus, avec cette gamme de longueurs d'onde, nous excluons la vision thermique de certains organismes comme les serpents. En effet, les serpents utilisent leurs fossettes sensorielles, qui sont sensibles aux émissions électromagnétiques entre 5 000 et 30 000 nm, donc dans l'infrarouge ; cependant, même s'ils perçoivent de loin ces rayonnements, ils ne les « voient » pas en ce sens qu'il n'y a aucune formation d'image. Cependant, des spécimens aveugles, capables de viser et d'attaquer des parties du corps particulières ont été documentés.

Dans un premier temps, une brève description des différents types d'organes sensoriels du système visuel sera développée, suivie d'une explication approfondie des composants de la vision humaine et du traitement du signal visuel chez l'homme. Puis nous finirons par un exemple des possibilités de perception.

Organes sensoriels

[modifier | modifier le wikicode]La vision, ou capacité de voir, dépend des organes sensoriels du système visuel, les yeux. Les schémas de constitution des yeux sont divers et variés. On les classe selon leur complexité, elle-même dépendante des besoins de l'organisme. Ces différentes constitutions ont des capacités différentes, sont sensibles à différentes longueurs d'onde et présentent différents degrés d'acuité. Elles nécessitent également des traitements différents pour interpréter les données et des paramètres différents pour fonctionner de manière optimale. La capacité de détecter et de déchiffrer les ondes EM est devenue être un atout précieux pour la plupart des formes de vie, augmentant les chances de survie des organismes qui les utilisent. Dans des environnements sans lumière suffisante ou présentant une absence totale de lumière, les formes de vie possédant la vue n'en retirent aucun avantage particulier, ce qui a finalement entraîné une atrophie des organes sensoriels visuels et une dépendance accrue des autres sens. C'est le cas notamment pour certains animaux des cavernes, les chauves-souris, etc. Il est intéressant de noter que les organes sensoriels visuels sont ajustés sur la fenêtre optique, définie comme étant les longueurs d'onde EM entre 300 nm et 1100 nm qui traversent l'atmosphère pour atteindre le sol. Ceci est montré dans la figure ci-dessous. Vous remarquerez peut-être qu'il existe d'autres « fenêtres », une fenêtre infrarouge (IR), qui explique dans une certaine mesure la "vision" thermique des serpents et une fenêtre dans les radiofréquences (RF), qu'aucune forme de vie connue n'est capable de détecter.

Au fil du temps, l'évolution a donné lieu à de nombreux schémas de constitution oculaires qui, à la suite d'évolutions successives, ont amené certains organismes similaires à partager les mêmes spécificités. Indépendamment de l'espèce et de la complexité du type d'organe sensoriel, il existe un élément essentiel que l'on retrouve universellement : l'utilisation des protéines sensibles à la lumière, les opsines. Sans trop se concentrer sur la base moléculaire, les différents schémas de construction peuvent être classés comme suit :

• Yeux simples ou camérulaires : ocelle, œil en trou d'épingle, œil à cristallin sphérique, œil miroir...

• Yeux composés.

La configuration la plus simple des yeux ne permet aux organismes que de détecter la lumière ambiante et donc de savoir s'il y a ou non de la lumière. Il s'agit normalement d'un simple rassemblement de cellules photosensibles formant un groupe, au même endroit, ce que l'on appelle parfois une « tache oculaire » ou stemma. Grâce aux mouvements des yeux, les organismes ont accès aux informations directionnelles, condition essentielle à la formation d'images. Ces fossettes sensorielles sont de loin les types d'organes sensoriels visuels les plus communs et on peut les trouver dans plus de 95 % des espèces connues.

En suivant cette approche jusqu'à l'extrême, on peut considérer que la fossette sensorielle est une simple structure caverneuse qui augmente l'acuité de l'image, contre une perte d'intensité. En d'autres termes, il existe un compromis entre intensité, ou luminosité, et acuité. Considérons maintenant le Nautilus, espèce appartenant à la famille des Nautilidae, organismes considérés comme des « fossiles vivants ». Ce sont les seules espèces connues qui possèdent l’œil à sténopé, comparable à la camera obscura. Tout comme les appareils photo, les Nautilus sont capables d'ajuster la taille de l'ouverture, augmentant ou diminuant la résolution de l’œil lorsque la luminosité de l'image diminue ou augmente. De même, pour régler le compromis intensité-résolution, il convient d'ajouter un objectif, c'est-à-dire une structure qui dirige la lumière vers une zone centrale, celle qui, le plus souvent, contient une plus grande densité de capteurs photoélectriques. En ajustant la forme du cristallin et en la déplaçant, ainsi qu'en contrôlant la taille de l'ouverture de la pupille, les organismes peuvent s'adapter à différentes conditions et fixer leur attention sur des zones d'intérêt particulières. La dernière amélioration apportée aux divers schémas de constitution oculaires déjà mentionnés est l'inclusion d'une cornée réfractrice. Les deux tiers de la capacité visuelle de ce type d’œil résident dans l'utilisation d'un liquide à indice de réfraction élevé situé à l'intérieur de la cornée, permettant une vision à très haute résolution. Ce schéma est celui des yeux des humains et de la plupart des animaux. Au sein d'un même catégorie d'yeux, il existe de nombreuses variations de la structure du cristallin, du nombre de cristallins, de la densité du photocapteur, de la forme de la fovéa, du nombre de fovéas, de la forme de la pupille, etc. afin d'augmenter les chances de survie de l'organisme en question. Ces variations engendrent diverses apparences externes des yeux, au sein d'une même catégorie, comme le montre la série de photographies d'animaux appartenant à la même catégorie d'yeux (à cornée réfractrice) présentée ci-dessous.

Une autre alternative est celle des yeux des mollusques. Au lieu de focaliser la lumière de manière conventionnelle en un seul point à l'arrière de l’œil, grâce à un cristallin ou à un système de cristallins, ces organismes ont à l'intérieur de la chambre oculaire des structures semblables à un miroir qui réfléchissent la lumière dans une partie centrale. Bien qu'il n'existe pas d'exemples d'organismes dont les yeux réfléchissants soient capables de former une image, il existe une espèce de poissons, les revenants (Opisthoproctidae), qui les utilise en combinaison avec des yeux à cristallins.

Le dernier type correspond aux yeux composés des insectes et des crustacés. Ces yeux sont constitués d'un certain nombre de sous-unités fonctionnelles appelées ommatidies, dont chacune est composée d'une facette, ou surface frontale, d'un cône cristallin transparent et de cellules photosensibles. En outre chacune des ommatidies est isolée par des cellules pigmentaires, ce qui garantit que la lumière incidente qu'elle reçoit est formée de rayons aussi aussi parallèles que possible.

La combinaison des sorties de chacune de ces ommatidies forme une image en mosaïque, avec une résolution proportionnelle au nombre d'unités d'ommatidies. Par exemple, si les humains avaient des yeux composés, ceux-ci recouvriraient tout leur visage pour conserver la même résolution. Il convient de noter qu'il existe de nombreux types d'yeux composés différents, mais approfondir ce sujet dépasse le cadre de ce texte.

Chez un animal on peut trouver des yeux de diverses constitution et en nombre variable selon l'espèce. Si les humains disposent de deux yeux, les araignées en possèdent généralement huit, dont la taille dépend des fonctions qui leur sont assignées. Les araignées sauteuses, par exemple, ont deux grands yeux frontaux qui leur donnent une excellente acuité visuelle, utile pour repérer et suivre leurs proies, et six yeux plus petits dont la résolution beaucoup plus faible leur permet de détecter les mouvements qui surviennent dans leur environnement. Deux photographies des yeux d'une araignée sauteuse et d'une araignée-loup illustrent la variabilité de la disposition des yeux des arachnides. Beaucoup d'insectes disposent à la fois d'yeux composés et d'ocelles ; les yeux composés des libellules présentent des structures différentes vers le haut et vers le bas.

Anatomie du système visuel

[modifier | modifier le wikicode]

Nous, êtres humains, sommes des créatures visuelles. Par conséquent, nos yeux sont compliqués et dotés de nombreux composants. Dans ce chapitre, nous essayons de décrire ces composants, donnant ainsi un aperçu des propriétés et des fonctionnalités de la vision humaine.

À l'intérieur du globe oculaire : pupille, iris et cristallin

[modifier | modifier le wikicode]Le flux lumineux qui pénètre dans l’œil par la pupille située à l'avant dépend directement des dimensions de cette ouverture, un « trou » dont l'aspect noir est dû à l'absorption presque totale de la lumière par les tissus intérieurs. L'iris qui entoure la pupille humaine peut être diversement coloré par des pigments.

Outre cette couche de pigments, l'iris possède deux couches de muscles ciliaires : le sphincter pupillaire se contracte pour rendre la pupille plus petite tandis que le dilatateur pupillaire se contracte pour la dilater. La combinaison de ces muscles antagonistes peut ainsi d'ouvrir plus ou moins la pupille en fonction des besoins ou des conditions de la personne. Les muscles ciliaires sont commandés par des zonules ciliaires, des fibres qui modifient également la forme du cristallin et le maintiennent en place.

L'étude comparée de l'iris et du diaphragme d'un objectif photographique fait apparaître de notables différences.

Le cristallin est situé immédiatement derrière la pupille. Sa forme et ses caractéristiques sont similaires à ceux des objectifs d'appareil photo mais il fonctionne différemment. La forme du cristallin est ajustée par la traction des zonules ciliaires, ce qui modifie par conséquent la distance focale. Avec l'aide de la cornée, le cristallin peut modifier la focalisation, une spécificité qui le rend essentiel au fonctionnement de l’œil, même si seulement un tiers de la capacité visuelle est permise par le cristallin lui-même. Il est aussi le filtre principal de l’œil. La majeure partie du cristallin est formée de fibres cristallines : des cellules longues et fines, dépourvues de la plupart des mécanismes cellulaires afin de favoriser la transparence. Avec les protéines hydrosolubles appelées cristallines, elles augmentent l'indice de réfraction du cristallin. Les fibres jouent également un rôle dans la structure et la forme du cristallin elles-mêmes.

La formation des images dans l’œil. La cornée et son agent protecteur, la sclérotique

[modifier | modifier le wikicode]La cornée, responsable des deux tiers restants de la capacité visuelle, recouvre l'iris, la pupille et le cristallin. Elle concentre les rayons lumineux avant qu'ils traversent l'iris avant et le cristallin. La cornée n'a que 0,5 mm d'épaisseur et se compose de 5 couches:

• Épithélium : couche de tissu épithélial recouvrant la surface de la cornée.

• Membrane de Bowman : épaisse couche protectrice composée de fibres de collagène solides qui maintiennent la forme générale de la cornée.

• Stroma : couche composée de fibrilles de collagène parallèles et représentant 90 % de l'épaisseur de la cornée.

• Membrane de Descemet et endothélium : deux couches ajustées à la chambre antérieure de l’œil, remplies d'un fluide produit par le corps ciliaire, l'humeur aqueuse. Ce fluide hydrate le cristallin, le nettoie et maintient la pression dans le globe oculaire. La chambre située entre la cornée et l'iris contient un corps trabéculaire, à l'intérieur duquel le liquide est drainé par le canal de Schlemm, à travers la chambre postérieure.

La surface de la cornée est située sous deux membranes protectrices appelées sclérotique et capsule de Tenon. Ces deux couches protectrices enveloppent complètement le globe oculaire. La sclérotique est constituée de fibres élastiques de collagène qui protègent l’œil des agressions extérieures. Cette couche forme le blanc de l’œil. Elle est traversée de nerfs et de vaisseaux, le plus grand étant le nerf optique. Elle est recouverte par la conjonctive, qui est une membrane muqueuse claire à la surface du globe oculaire. Cette membrane tapisse également l'intérieur de la paupière. Elle est lubrifiée et protégée par les larmes produites par les glandes lacrymales. La couche protectrice restante, la paupière, sert également à répandre ce lubrifiant autour du globe oculaire.

Faire bouger les yeux. Les muscles extra-oculaires

[modifier | modifier le wikicode]Le globe oculaire se déplace grâce à une structure musculaire compliquée comprenant quatre muscles droits : inférieur, médial, latéral et supérieur et deux muscles obliques : inférieur et supérieur. Le positionnement de ces muscles est présenté ci-dessous, avec les fonctions suivantes :

Comme vous pouvez le constater, les muscles extra-oculaires (2,3,4,5,6,8) sont attachés à la sclérotique du globe oculaire et prennent naissance dans l'anneau de Zinn, un tendon fibreux entourant le nerf optique. Un système de poulie est créé avec la trochlée (la trochlée étant la poulie et le muscle oblique supérieur étant la corde), permettant d'orienter correctement la force musculaire. Les muscles extra-oculaires restants ont un chemin direct vers l’œil et ne nécessitent donc pas de systèmes de poulies. En utilisant ces muscles extra-oculaires, l’œil peut pivoter vers le haut, le bas, la gauche, la droite et des mouvements alternatifs sont possibles.

Les mouvements sont également très importants pour que nous puissions voir. Les mouvements de vergence permettent le bon fonctionnement de la vision binoculaire. Les mouvements rapides inconscients, appelés saccades, sont essentiels pour que les personnes puissent garder la mise au point sur un objet. La saccade est une sorte de mouvement nerveux effectué lorsque les yeux balayent le champ visuel afin de déplacer légèrement le point de fixation. Lorsque vous suivez un objet en mouvement avec votre regard, vos yeux exécutent ce que l'on appelle une poursuite visuelle. Des mouvements involontaires supplémentaires, appelés nystagmus, sont causés par les signaux du système vestibulaire. Ensemble, ils forment les réflexes vestibulo-oculaires.

Le tronc cérébral contrôle tous les mouvements des yeux, différentes zones étant responsables de différents mouvements.

• Pons : mouvements horizontaux rapides, tels que saccades ou nystagmus

• Mésencéphale : mouvements verticaux et de torsion

• Cervelet : réglage précis

• Noyau Edinger-Westphal : mouvements de vergence

Où se produit la réception de la vision - La rétine

[modifier | modifier le wikicode]Avant d'être transmises, les ondes EM entrantes passent à travers la cornée, le cristallin et la macula. Ces structures agissent également en tant que filtres pour réduire les ondes EM indésirables, protégeant ainsi l’œil de rayonnements nocifs. La réponse de filtrage de chacun de ces éléments est visible dans la figure Filtrage de la lumière effectuée par la cornée, le cristallin et l'épithélium pigmentaire. Comme on peut le constater, la cornée atténue les longueurs d'onde les plus basses, laissant les longueurs d'onde les plus hautes presque intactes. Le cristallin bloque environ 25 % des ondes EM inférieures à 400 nm et plus de 50 % des ondes EM inférieures à 430 nm. Enfin, l'éphithélium pigmentaire, dernière étape de filtrage avant la photoréception, affecte environ 30 % des ondes EM entre 430 et 500 nm.

La partie de l’œil qui marque la transition entre la région non photosensible et la région photosensible, est appelée ora serrata. La région photosensible est appelée la rétine, qui est la structure sensorielle du fond de l’œil. La rétine se compose de plusieurs couches présentées ci-dessous avec des millions de photorécepteurs, appelés bâtonnets et cônes, qui réagissent aux rayons lumineux et les convertissent en impulsions électriques. La transmission de ces impulsions part des cellules ganglionnaires et se fait par le nerf optique, la seule voie par laquelle l'information quitte l’œil.

Une illustration conceptuelle de la structure de la rétine est présentée à droite. Comme on peut le constater, il existe cinq types de cellules principales :

• cellules photoréceptrices

• cellules horizontales

• cellules bipolaires

• cellules d'amécrine

• cellules ganglionnaires

Les cellules photoréceptrices peuvent être subdivisées en deux sous-catégories : les bâtonnets et les cônes. Dans la plupart des régions de la rétine, les cônes sont beaucoup moins nombreux que les bâtonnets mais il en existe une énorme concentration dans la macula, en particulier dans sa partie centrale appelée fovéa. Dans cette région centrale, chaque cône photosensible est connecté à une cellule ganglionnaire. De plus, les cônes de cette région sont légèrement plus petits que les autres ; on observe donc d'autant plus de cônes pour cette zone. C'est grâce à ce ratio et à la forte densité de cônes que nous avons l'acuité visuelle la plus élevée.

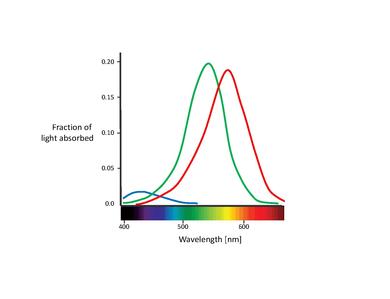

Il existe chez l'être humain trois types de cônes, chacun étant sensible à un intervalle spécifique de longueurs d'onde. Les cônes se distinguent par la présence de trois types de pigments appelés photopsines, respectivement sensibles aux longueurs d'onde des lumières rouge, bleue ou verte. Nous avons donc des cônes « bleus », « verts » et « rouges », également appelés cônes S, M et L en raison de leur sensibilité respective aux longueurs d'onde courtes, moyennes et longues. Cela se compose d'une protéine appelée opsine et d'un chromophore lié appelé rétinal. Les principales composantes de la cellule conique sont le terminal synaptique, les segments interne et externe, le noyau interne et les mitochondries.

Les sensibilités spectrales des 3 types de cônes:

• Les cônes S sont sensibles aux ondes courtes, c'est-à-dire à la lumière bleu-violet. La longueur d'onde d'absorption maximale pour les cônes S est de 420 nm.

• Les cônes M sont sensibles à la lumière allant de bleu-vert à jaune. Dans ce cas, la longueur d'onde d'absorption maximale est de 535 nm.

• Les cônes L sont sensibles à la lumière allant de jaune à rouge. La longueur d'onde d'absorption maximale est de 565 nm.

La couche interne contient les organites, le noyau et les organelles de la cellule. Le pigment est situé dans la couche externe, attaché à la membrane sous forme de protéines transmembranaires de la membrane cellulaire qui forment les disques membraneux, clairement visibles sur la figure présentant la structure de base des cellules à cône et à tige. Les disques maximisent la zone de réception des cellules. Les photorécepteurs à cône de nombreux vertébrés contiennent des organites sphériques appelées gouttelettes d'huile, censées constituer des filtres intra-oculaires pouvant servir à augmenter le contraste, à réduire l'éblouissement et à atténuer les aberrations chromatiques causées par le gradient (???), de la taille d'une mitochondrie de la périphérie aux centres.

Les bâtonnets ont une structure similaire à celle des cônes mais ils contiennent à la place un pigment appelé rhodopsine qui leur permet de percevoir la lumière de faible intensité avec une sensibilité 100 fois plus grande que celle des cônes. La rhodopsine est le seul pigment que l'on trouve dans les bâtonnets humains. On la retrouve sur la face externe de l'épithélium pigmentaire, qui, de la même manière que les cônes, maximise la zone d'absorption en utilisant une structure de disque. De la même manière que les cônes, la borne synaptique de la cellule la relie à une cellule bipolaire et les segments interne et externe sont reliés par du cilium.

La rhodopsine absorbe la lumière entre 400 et 600 nm, avec une absorption maximale vers 500 nm. Cette longueur d'onde correspond à la lumière bleu verdâtre, ce qui signifie que la nuit, les couleurs bleues apparaissent plus intenses que les rouges.

Les ondes électromagnétiques dont la longueur d'onde est en dehors de la plage de 400 à 780 nm ne sont détectées ni par des bâtonnets ni par des cônes, et sont donc habituellement invisibles pour les êtres humains.

Remarque : il ne faut toutefois pas oublier que les valeurs de l'efficacité lumineuse, qui caractérise l'intensité de la sensation ressentie par rapport à l'énergie reçue, ne sont que des moyennes considérées pour des raisons pratiques comme une « norme ». En fait, de nombreuses personnes, surtout des hommes, ont une vision des couleurs qui s'écarte de ces moyennes. Par ailleurs, des lumières situées en-dehors des intervalles « normaux », comme la raie ultra-violette du mercure à 365 nm, peuvent être perçues si elles sont suffisamment intenses.

Les cellules horizontales occupent la couche nucléaire interne de la rétine. Il existe deux types de cellules horizontales et les deux types hyper-polarisent en réponse à la lumière, c'est-à-dire qu'ils deviennent plus négatifs (???). Le type A consiste en un sous-type appelé HII-H2 qui interagit principalement avec les cônes en S. Les cellules de type B ont un sous-type appelé HI-H1, qui comporte un arbre à dendrites et un axone. Le premier est en contact principalement avec les cellules à cônes M et L et les dernières cellules à tige (???).

Les contacts avec les cônes sont établis principalement par des synapses prohibitives, tandis que les cellules elles-mêmes sont reliées à un réseau avec des jonctions.

Les cellules bipolaires ont des dendrites uniques dans la couche plexiforme externe et le péricaryon, leurs corps cellulaires se trouvent dans la couche nucléaire interne. Les dendrites s'interconnectent exclusivement avec des cônes et des bâtonnets et nous pouvons distinguer une cellule bipolaire à un bâtonnet ainsi que neuf ou dix cellules bipolaires à cône. Ces cellules se ramifient avec des cellules amacrines ou ganglionnaires dans la couche plexiforme interne en utilisant un axone. Les cellules bipolaires à tige se connectent par des synapses à triades ou à 18 à 70 cellules de tige. Leurs axones s'étendent autour des terminaisons synaptiques de la couche plexiforme interne, qui contiennent des synapses à ruban et entrent en contact avec une paire de processus cellulaires dans les synapses de dyade. Ils sont connectés aux cellules ganglionnaires avec des liaisons de cellules amacrines AII.

Les cellules d'amécrine peuvent être trouvées dans la couche nucléaire interne et dans la couche de cellules ganglionnaires de la rétine, parfois aussi dans la couche plexiforme interne, où elles agissent en tant que modulatrices de signal. Elles ont été classées en champs étroits, petits champs, champs moyens ou champs larges en fonction de leur taille. Cependant, il existe de nombreuses classifications conduisant à plus de 40 types différents de cellules amécrines.

Les cellules ganglionnaires sont les émetteurs terminaux du signal visuel allant de la rétine au cerveau. Les cellules ganglionnaires les plus courantes dans la rétine sont les cellules ganglionnaires de petite taille et les cellules ganglionnaires du parasol. Après avoir traversé toutes les couches rétiniennes, le signal est transmis à ces cellules qui constituent l'étape finale de la chaîne de traitement du signal par la rétine. Toutes les informations sont rassemblées ici, transmises aux fibres nerveuses rétiniennes et aux nerfs optiques. Le point où les axones ganglionnaires fusionnent pour créer un nerf optique s'appelle le disque optique. Ce nerf est construit principalement à partir des axones ganglionnaires de la rétine. La majorité des axones transmettent des données au noyau géniculé latéral, qui est un lien de terminaison pour la plupart des parties du nerf et qui transmet l'information au cortex visuel. Certaines cellules ganglionnaires réagissent également à la lumière mais comme cette réponse est plus lente que celle des bâtonnets et des cônes, on pense qu'elle est liée à la détection des niveaux de lumière ambiante et au réglage de l'horloge biologique.

Le traitement du signal

[modifier | modifier le wikicode]Comme mentionné précédemment, la rétine est le composant principal de l’œil car elle contient toutes les cellules sensibles à la lumière. Sans elle, l’œil serait comparable à un appareil photo dépourvu de film ou de capteur. Cette partie montre comment la rétine perçoit la lumière, comment le signal optique est transmis au cerveau puis comment le cerveau traite le signal pour élaborer suffisamment d'informations en vue de la prise de décision.

La création initiale du signal - Les cellules photosensibles

[modifier | modifier le wikicode]La vision commence invariablement par la lumière frappant les cellules photosensibles présentes dans la rétine. Les pigments visuels absorbant la lumière, une variété d'enzymes et de transmetteurs dans des bâtonnets et des cônes rétiniens vont initier la conversion des stimuli électromagnétiques visibles en impulsions électriques, selon un processus appelé transduction photoélectrique. En prenant des bâtonnets à titre d'exemple, l'EM visible visible frappe les molécules de rhodopsine, molécules transmembranaires présentes dans la structure du disque externe des bâtonnets. Chaque molécule de rhodopsine consiste en un groupe d'hélices appelé opsine, qui enveloppent et entourent le rétinal 11-cis, qui est la partie de la molécule qui changera en raison de l'énergie des photons entrants. Dans les molécules biologiques, les fractions ou parties de molécules qui provoqueront des changements de conformation dus à cette énergie sont parfois appelées chromophores. Le 11-cis rétinien se redresse en réponse à l'énergie entrante, se transformant en rétinien (rétinien tout trans), ce qui force les hélices à opsine à se séparer, provoquant la découverte de sites réactifs particuliers. Cette molécule de rhodopsine "activée" est parfois appelée métarhodopsine II. À partir de ce moment, même si la stimulation par la lumière visible cesse, la réaction se poursuivra. La métarhodopsine II peut alors réagir avec environ 100 molécules d'une protéine Gs appelée transduction, ce qui aboutit alors à l'as and ßs. Ensuite le GDP est converti en GTP. Le GTP as activé se lie ensuite à la cGMP-phosphodiestérase (PDE), supprimant les fonctions normales d'échange d'ions, ce qui entraîne une faible concentration en cytosol des ions cationiques, et par conséquent une modification de la polarisation de la cellule.

La réaction de transduction photoélectrique naturelle possède un incroyable pouvoir d'amplification. Une seule molécule de rhodopsine rétinienne activée par un seul quantum de lumière provoque l'hydrolyse d'un maximum de 106 molécules de GMPc par seconde.

La phototransduction

[modifier | modifier le wikicode]1.Un photon lumineux interagit avec le rétinal dans un photorécepteur. Le rétinal subit une isomérisation, passant de la configuration 11-cis à la configuration tout-trans.

2.Le rétinal ne s'adapte plus dans le site de liaison à l'opsine.

3.L'opsin subit donc un changement de conformation en métarhodopsine II.

4.La métarhodopsine II est instable et se scinde, donnant de l'opsine et du rétinal tout-trans.

5.L'opsine active la transducine régulatrice de la protéine. Ce qui provoque la dissociation de la transducine se dissocie de son PIB lié et lie le GTP, puis la sous-unité alpha de la transducine se dissocie des sous-unités bêta et gamma, le GTP étant toujours lié à la sous-unité alpha.

6.Le complexe sous-unité alpha-GTP active la phosphodiesterase.

7.La phosphodiesterase décompose le GMPc en 5'-GMP. Cela diminue la concentration de GMPc et donc la fermeture des canaux sodiques.

8.La fermeture des canaux sodiques provoque une hyperpolarisation de la cellule en raison du courant de potassium en cours.

9.L'hyperpolarisation de la cellule provoque la fermeture des canaux calciques dépendants du voltage.

10.Lorsque le niveau de calcium dans la cellule photoréceptrice diminue, la quantité de glutamate de neurotransmetteur libérée par la cellule diminue également. Cela est dû au fait que le calcium est nécessaire pour que les vésicules contenant du glutamate fusionnent avec la membrane cellulaire et libèrent leur contenu.

11.Une diminution de la quantité de glutamate libérée par les photorécepteurs provoque une dépolarisation des cellules bipolaires centrées (cellules bipolaires à bâtonnets et à cônes) et une hyperpolarisation des cellules bipolaires à cône éteint.

Sans stimulation électromagnétique visible, les cellules en bâtonnets contenant un cocktail d'ions, de protéines et d'autres molécules présentent des différences de potentiel membranaire d'environ -40 mV. Comparé aux autres cellules nerveuses, ce potentiel est assez élevé (-65 mV). Dans cet état, le glutamate de neurotransmetteur est libéré en continu des terminaisons axonales et absorbé par les cellules bipolaires voisines. Avec l'EM visible et la réaction en cascade mentionnée précédemment, la différence de potentiel chute à -70 mV. Cette hyper-polarisation de la cellule provoque une réduction de la quantité de glutamate libéré, affectant ainsi l'activité des cellules bipolaires et, par la suite, les étapes suivantes de la voie optique.

Des processus similaires existent dans les cellules du cône et dans les cellules ganglionnaires photosensibles, mais utilisent des opsines différentes. Les photopsines I à III (respectivement vertes-jaunâtres, vertes et bleues-violettes) se trouvent dans les trois différentes cellules du cône et on peut trouver la mélanopsine (bleue) dans les cellules ganglionnaires photosensibles.

Le traitement du signal dans la rétine

[modifier | modifier le wikicode]Différentes cellules bipolaires réagissent différemment aux modifications du glutamate libéré. Les cellules bipolaires ON et OFF sont utilisées pour former le flux de signal direct des cônes aux cellules bipolaires. Les cellules bipolaires ON vont se dépolariser par stimulation électromagnétique visible et les cellules ganglionnaires ON correspondantes seront activées. D'autre part, les cellules bipolaires OFF sont hyper polarisées par la stimulation EM visible et les cellules ganglionnaires OFF sont inhibées. C'est la voie de base du flux de signal direct. Le flux de signal latéral commencera à partir des bâtonnets, puis ira aux cellules bipolaires, puis aux cellules amacrines, et les cellules bipolaires OFF inhibées par les cellules Rod-amacrine et les cellules bipolaires ON seront stimulées via une synapse électrique, après toutes les étapes prévues, le signal arrivera aux cellules ganglionnaires activées ou désactivées et ainsi l'ensemble du trajet du flux de signal latéral est établi.

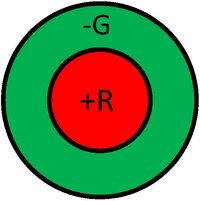

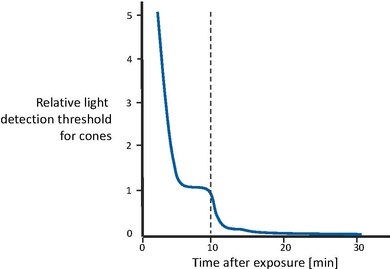

Lorsque le potentiel d'action (PA) est activé, les cellules ganglionnaires seront déclenchées par le stimulus EM visible. La fréquence AP augmentera lorsque le potentiel du capteur augmente. En d'autres termes, AP dépend de l'amplitude du potentiel du capteur. La région des cellules ganglionnaires où les effets stimulants et inhibiteurs influencent la fréquence des AP s'appelle le champ récepteur (RF). Autour des cellules ganglionnaires, le RF est généralement composé de deux régions: la zone centrale et la zone périphérique en forme d'anneau. Ils se distinguent lors de l'adaptation visible aux EM. Une stimulation électromagnétique visible sur la zone centrale pourrait entraîner une augmentation de la fréquence du PA et la stimulation sur la zone périphérique diminuerait la fréquence du PA. Lorsque la source de lumière est éteinte, l'excitation se produit. Le nom du champ ON (champ central ON) fait donc référence à ce type de région. Bien entendu, la RF des cellules ganglionnaires OFF agit dans le sens opposé et est donc appelée "champ OFF" (champ central OFF). Les RF sont organisés par les cellules horizontales. L'impulsion sur la région périphérique sera impulsée et transmise à la région centrale, là où le contraste appelé stimulus est formé. Cette fonction rendra l'obscurité plus sombre et la lumière plus brillante. Si tout le RF est exposé à la lumière. l'impulsion de la région centrale prédominera.

La transmission du signal au cortex

[modifier | modifier le wikicode]Comme mentionné précédemment, les axones des cellules ganglionnaires convergent vers le disque optique de la rétine, formant le nerf optique. Ces fibres sont positionnées à l'intérieur du faisceau dans un ordre spécifique. Les fibres de la zone maculaire de la rétine se trouvent dans la partie centrale et celles de la moitié temporale de la rétine occupent la partie périphérique. Une décussation ou un croisement partiel se produit lorsque ces fibres se trouvent en dehors de la cavité oculaire. Les fibres des moitiés nasales de chaque rétine se croisent vers les moitiés opposées et s'étendent jusqu'au cerveau.

Celles des moitiés temporales restent à la périphérie. Ce croisement partiel s'appelle le chiasma optique, et les nerfs optiques au-delà de ce point s'appellent les voies optiques, principalement pour les distinguer des nerfs rétiniens simples. Le croisement partiel a pour fonction de transmettre le champ visuel de la main droite produit par les deux yeux à la moitié gauche du cerveau uniquement et inversement. Par conséquent, les informations de la moitié droite du corps et du champ visuel droit sont toutes transmises à la partie gauche du cerveau lorsqu'elles atteignent la partie postérieure de l'avant-cerveau (diencephale).

Le relais d'information entre les fibres du tractus optique et les cellules nerveuses se produit dans les corps géniculés latéraux, la partie centrale du traitement du signal visuel, situé dans le thalamus du cerveau. C'est d'ici que l'information est transmise aux cellules nerveuses vers le cortex occipital du côté correspondant du cerveau. Les connexions de la rétine au cerveau peuvent être séparées en une "voie parvocellulaire" et une "voie magnocellulaire". Les voies parvocellulaires signalent la couleur et les détails fins, tandis que les voies magnocellulaires détectent les stimuli en mouvement rapide.

Les signaux des appareils photo numériques standard correspondent approximativement à ceux de la voie parvocellulaire. Pour simuler les réponses des voies parvocellulaires, les chercheurs ont développé des systèmes sensoriels neuromorphes, qui tentent d'imiter le calcul basé sur les pointes dans les systèmes neuronaux. Pour ce faire ils utilisent un schéma appelé "représentation d'adresse-événement" pour la transmission du signal dans les systèmes électroniques neuromorphes (Liu et Delbruck 2010 [1]).

Sur le plan anatomique, les cellules ganglionnaires de Magno et de Parvo rétiniennes projettent respectivement 2 couches magnocellulaires ventrales et 4 couches parvocellulaires dorsales du noyau géniculé latéral (LGN). Chacune des six couches de LGN reçoit des entrées de l’œil ipsilatéral ou contralatéral, c'est-à-dire que les cellules ganglionnaires de l’œil gauche se croisent et se projettent sur les couches 1, 4 et 6 de la LGN droite. Et les cellules ganglionnaires de l’œil droit se projettent (sans se croiser) sur les couches 2,3 et 5. À partir de là, les informations provenant de l’œil droit et de l’œil gauche sont séparées.

Bien que la vision humaine soit combinée par deux moitiés de la rétine et que le signal soit traité par les hémisphères cérébraux opposés, le champ visuel est considéré comme une unité lisse et complète. Par conséquent, les deux aires corticales visuelles sont considérées comme étant intimement liées. Cette connexion, appelée corpus callosum, est constituée de neurones, d'axones et de dendrites. Comme les dendrites établissent des connexions synaptiques avec les points correspondants des hémisphères, la simulation électrique de tout point d'un hémisphère indique la simulation du point interconnecté de l'autre hémisphère. La seule exception à cette règle est le cortex visuel primaire.

Les synapses sont fabriquées par le tractus optique dans les couches respectives du corps géniculé latéral. Ensuite, ces axones de ces cellules nerveuses de troisième ordre sont transmis à la fissure calcarine dans chaque lobe occipital du cortex cérébral. Comme les bandes des fibres blanches et des paires d'axones des cellules nerveuses de la rétine le traversent, on l'appelle le cortex strié, qui est d'ailleurs notre principal cortex visuel, parfois appelé V1. À ce stade, les impulsions des yeux séparés convergent vers les neurones corticaux communs, ce qui permet ensuite l'entrée complète des deux yeux dans une région afin d'être utilisée pour la perception et la compréhension. La reconnaissance des formes est une fonction très importante de cette partie du cerveau, les lésions causant des problèmes de reconnaissance visuelle ou de vision aveugle.

Si l'on se fonde sur la manière ordonnée selon laquelle les fibres du tractus optique transmettent des informations aux corps géniculés latéraux et ensuite vers la zone striée, et si un seul point de stimulation sur la rétine était trouvé, la réponse qui s'est produite électriquement à la fois dans le corps géniculé latéral et le cortex strié se trouverait dans une petite région de la tache rétinienne. Ceci est la manière évidente de traiter le signal point à point. Et si toute la rétine est entièrement stimulée, les réponses se produiront à la fois sur les deux corps géniculés latéraux et sur la zone de matière grise du cortex strié. Il est possible de dresser une carte de cette région du cerveau jusqu'aux champs rétiniens, ou plus généralement jusqu'aux champs visuels.

Toute autre étape dans cette voie sort du cadre de ce livre. Soyez assuré que de nombreux autres niveaux et centres existent, en vous concentrant sur des tâches spécifiques, telles que la couleur, les orientations, les fréquences spatiales, les émotions, etc.

Le traitement de l'information dans le système visuel

[modifier | modifier le wikicode]Équipé d'une compréhension plus fine de certains des concepts les plus importants du traitement du signal dans le système visuel, la compréhension ou la perception de l'information sensorielle traitée est la dernière pièce importante du puzzle. La perception visuelle est le processus de traduction des informations reçues par les yeux dans la compréhension de l'état extérieur des choses. Cela nous rend conscients du monde qui nous entoure et nous permet de mieux le comprendre. Sur la base de la perception visuelle, nous apprenons des modèles que nous appliquons plus tard dans la vie et nous prenons des décisions en fonction de ces informations perçues. En d'autres termes, notre survie dépend de la perception. Le champ de la perception visuelle a été divisé en différents sous-champs, en raison du fait que le traitement est trop complexe et nécessite divers mécanismes spécialisés pour percevoir ce qui est vu. Ces sous-champs incluent: la perception des couleurs, la perception du mouvement, la perception de la profondeur, la reconnaissance des visages, etc.

Le cortex visuel des primates

[modifier | modifier le wikicode]Malgré la puissance de calcul sans cesse croissante des systèmes électroniques, il existe encore de nombreuses tâches pour lesquelles les animaux et les humains dépassent de loin les ordinateurs, notamment la perception et la contextualisation de l'information. L'ordinateur classique, que ce soit celui de votre téléphone ou celui d'un supercalculateur occupant toute la pièce, est essentiellement un calculateur de chiffres. Il peut effectuer une quantité incroyable de calculs en un temps infime. Ce qui lui manque, c'est de créer des abstractions de l'information avec laquelle il travaille. Si vous connectez une caméra à votre ordinateur, l'image qu'elle perçoit n'est qu'une grille de pixels, un tableau de nombres en 2 dimensions. Un humain reconnaîtrait immédiatement la géométrie de la scène, les objets de la photo et peut-être même le contexte de ce qui se passe. Cette capacité que nous avons, nous est fournie par une machinerie biologique dédiée - le système visuel du cerveau.

Il traite tout ce que nous voyons de manière hiérarchique, depuis les fonctionnalités les plus simples de l'image jusqu'aux plus complexes, en passant par la classification des objets en catégories. On dit donc que le système visuel a une hiérarchie profonde. La hiérarchie profonde du système visuel des primates a incité les informaticiens à créer des modèles de réseaux de neurones artificiels comportant également plusieurs couches, chacune d'elles créant des généralisations plus élevées des données d'entrée.

Environ la moitié du néocortex humain est dédiée à la vision. Le traitement des informations visuelles s'effectue sur au moins 10 niveaux fonctionnels. Les neurones dans les premières zones visuelles extraient des caractéristiques d'image simples sur de petites régions locales de l'espace visuel. Lorsque les informations sont transmises aux zones visuelles supérieures, les neurones répondent à des caractéristiques de plus en plus complexes. Avec des niveaux plus élevés de traitement de l'information, les représentations deviennent plus invariantes - moins sensibles à la taille, à la rotation ou à la position exactes des caractéristiques. De plus, la taille du champ récepteur des neurones dans les zones visuelles supérieures augmente, indiquant qu'ils sont réglés sur des caractéristiques d'image plus globales. Cette structure hiérarchique permet un calcul efficace: différentes zones visuelles supérieures peuvent utiliser les mêmes informations calculées dans les zones inférieures. La description générique de la scène qui est faite dans les premières zones visuelles est utilisée par d'autres parties du cerveau pour effectuer diverses tâches, telles que la reconnaissance et la catégorisation d'objets, la saisie, la manipulation, la planification de mouvements, etc.

La vision sous-corticale

[modifier | modifier le wikicode]

Le traitement neuronal de l'information visuelle commence déjà avant toute structure corticale. Les photorécepteurs sur la rétine détectent la lumière et envoient des signaux aux cellules ganglionnaires de la rétine. La taille du champ récepteur d'un photorécepteur est d'un centième de degré (un champ récepteur d'environ un degré correspond à peu près à la taille de votre pouce lorsque vous avez le bras tendu devant vous). Le nombre d'entrées dans une cellule ganglionnaire et donc la taille de son champ récepteur dépendent de son emplacement: au centre de la rétine, elle reçoit des signaux provenant de cinq récepteurs seulement, tandis qu'à la périphérie, une seule cellule peut contenir plusieurs milliers d'entrées. Cela implique que la résolution spatiale la plus élevée se situe au centre de la rétine, également appelée fovéa. En raison de cette propriété, les primates possèdent un mécanisme de contrôle du regard qui dirige la vue de sorte que les caractéristiques intéressantes se projettent sur la fovéa.

Les cellules ganglionnaires sont réglées de manière sélective pour détecter diverses caractéristiques de l'image, telles que le contraste de luminance, le contraste de couleur, la direction et la vitesse de déplacement. Toutes ces caractéristiques constituent les informations principales utilisées ultérieurement dans le pipeline de traitement. S'il existe des stimuli visuels qui ne sont pas détectables par les cellules ganglionnaires, ils ne sont également disponibles pour aucun espace visuel cortical.

Les cellules ganglionnaires se projettent dans une région du thalamus appelée noyau géniculé latéral (LGN), qui à son tour relaie les signaux au cortex. Il n'y a pas de calcul significatif connu dans LGN - il y a presque une correspondance un-à-un entre le ganglion rétinien et les cellules LGN. Cependant, seulement 5% des entrées de LGN proviennent de la rétine - toutes les autres entrées sont des projections à rétroaction corticale. Bien que le système visuel soit souvent considéré comme un système à feed-forward, les connexions de rétroaction récurrentes ainsi que les connexions latérales sont une caractéristique commune observée dans tout le cortex visuel. Le rôle de la rétroaction n'est pas encore complètement compris, mais il est proposé de l'attribuer à des processus tels que l'attention, les attentes, l'imagination et le remplissage des informations manquantes.

La vision corticale

[modifier | modifier le wikicode]Le cortex visuel peut être divisé en trois grandes parties: la partie occipitale qui reçoit les entrées de LGN puis envoie les sorties par le flux dorsal et ventral. La partie occipitale comprend les zones V1-V4 et MT, qui traitent divers aspects de l'information visuelle et donne lieu à la représentation générique des scènes. La voie dorsale est impliquée dans l'analyse de l'espace et dans la planification de l'action. La voie ventrale participe à la reconnaissance et à la catégorisation des objets.

V1 est la première zone corticale qui traite les informations visuelles. Elle est sensible aux contours extérieurs, aux réseaux, aux fins de ligne, au mouvement, à la couleur et aux disparités (différence angulaire entre les projections d'un point sur les rétines gauche et droite). L'exemple le plus simple du traitement hiérarchique ascendant est la combinaison linéaire des entrées de plusieurs cellules ganglionnaires avec des champs récepteurs centraux pour créer la représentation d'une barre. Ceci est fait par les cellules simples de V1 et a été décrit pour la première fois par les neuroscientifiques renommés Hubel et Wiesel. Ce type d'intégration d'informations implique que les cellules simples sont sensibles à l'emplacement exact de la barre et ont un champ de réception relativement petit. Les cellules complexes de V1 reçoivent les entrées des cellules simples et, bien que répondant également à des modèles orientés de manière linéaire, elles ne sont pas sensibles à la position exacte de la barre et ont un champ de réception plus grand. Le calcul présenté à cette étape pourrait être une opération de type MAX produisant des réponses d'amplitude similaire à la plus grande des réponses des stimuli. Certaines cellules simples et complexes peuvent également détecter la fin d'une barre et une fraction des cellules V1 sont également sensibles au mouvement local dans leurs champs récepteurs respectifs.

La zone V2 offre une représentation plus sophistiquée des contours, notamment des contours définis par une texture, des contours illusoires et des contours qui possèdent une bordure. V2 s'appuie également sur la détection de la disparité absolue dans V1 et présente des cellules sensibles à la disparité relative, qui correspond à la différence entre les disparités absolues de deux points de l'espace. La zone V4 reçoit les entrées de V2 et la zone V3, mais on sait très peu de choses sur le calcul effectué dans V3. La zone V4 contient des neurones sensibles aux contours de courbure différente et aux sommets d'angles particuliers. Une autre caractéristique importante est le codage de la teinte invariante de la luminance. Cela contraste avec V1 où les neurones réagissent à une opposition de couleur le long des deux axes principaux (rouge-vert et jaune-bleu) plutôt que la couleur réelle. La V4 est ensuite transmise au flux ventral vers le cortex temporal inférieur (IT), ce qui a été démontré par des études sur les lésions comme étant essentiel pour la discrimination d'objet.

Le cortex temporal inférieur: différenciation des objets

[modifier | modifier le wikicode]

Le cortex temporal inférieur (IT) est divisé en deux zones: TEO et TE. La région TEO intègre des informations sur les formes et les positions relatives d'éléments aux multiples contours et comprend principalement des cellules répondant à de simples combinaisons de caractéristiques. La taille du champ récepteur des neurones TEO est d'environ 3 à 5 degrés. Area TE comporte des cellules avec des champs récepteurs beaucoup plus grands (10 à 20 degrés) qui correspondent aux visages, aux mains et aux configurations complexes. Les cellules de TE répondent à des caractéristiques visuelles qui sont une généralisation plus simple de l'objet d'intérêt, mais plus complexe que de simples barres ou points. Ceci a été démontré en utilisant une méthode de réduction de stimulus par Tanaka et al. dans laquelle une réponse à un objet est tout d'abord mesurée, puis l'objet est remplacé par des représentations plus simples jusqu'à ce que la caractéristique critique à laquelle répondent les neurones TE soit réduite.

Il semble que les neurones informatiques combinent diverses caractéristiques de complexité moyenne à partir des niveaux inférieurs du flux ventral pour créer des modèles de parties d'objet. Les neurones de TE qui sont sélectifs pour des objets spécifiques doivent remplir deux exigences apparemment contradictoires: la sélectivité et l'invariance. Ils doivent faire la distinction entre différents objets au moyen de la sensibilité aux caractéristiques des images rétiniennes. Cependant, le même objet peut être vu sous différents angles et à différentes distances dans différentes conditions d'éclairage, ce qui donne des images rétiniennes extrêmement différentes du même objet.

Si l'on considère toutes ces images comme équivalentes, il faut dériver des caractéristiques invariantes qui résistent à certaines transformations, telles que des changements de position, d'éclairage, de taille sur la rétine, etc. Les neurones dans la zone TE montrent une invariance de position et de taille ainsi que dans l'occlusion partielle, de la position en profondeur et direction de l'éclairage. Il a été démontré que la rotation en profondeur avait la plus faible invariance, à l'exception si l'objet est un visage humain.

Les catégories d'objets ne sont pas encore explicitement présentes dans la zone TE. Un neurone peut généralement correspondre à plusieurs exemples de la même catégorie (par exemple, des images d'arbres), mais pas à tous.

Il peut également correspondre à des exemples de différentes catégories (par exemple, les arbres et les non-arbres). La reconnaissance et la classification des objets impliquent très probablement un échantillonnage d'une population plus large de neurones TE ainsi que la réception d'entrées d'autres zones du cerveau, par exemple celles responsables de la compréhension du contexte de la scène. Des expériences de lecture récentes ont montré que des classificateurs statistiques (par exemple, des machines à vecteurs de support) peuvent être formés à la classification d'objets en fonction des réponses d'un petit nombre de neurones TE. Par conséquent, une population composée essentiellement de neurones TE peut en principe indiquer de manière fiable grâce à la combinaison de leur activité. De manière intéressante, il existe également des rapports sur des neurones hautement sélectifs dans le lobe temporal médial qui répondent à des signaux très spécifiques, par exemple à la tour de Pise, dans différentes photos ou au visage d'une personne donnée.

L'apprentissage dans le système visuel

[modifier | modifier le wikicode]L'apprentissage peut altérer la sélectivité visuelle des neurones, ce qui a pour effet de rendre plus difficile l'apprentissage aux niveaux hiérarchiques supérieurs. Il n'existe aucune preuve d'apprentissage dans la rétine et les schémas d'orientation de V1 semblent être génétiquement largement prédéterminées. Cependant, la pratique de l'identification d'orientation améliore le codage d'orientation dans les neurones V1 en augmentant la pente de la courbe de réglage. Des effets similaires mais plus importants ont été observés dans V4. En zone TE, relativement peu d'entraînement visuel a produit des effets physiologiques notables sur la perception visuelle, aussi bien au niveau d'une cellule unique, qu'en IRMf. Par exemple, transformer deux objets l'un en l'autre augmente leur similarité perçue. Globalement, il semble que même le cortex visuel adulte soit considérablement plastique et le niveau de plasticité peut être considérablement accru, par exemple en administrant des médicaments spécifiques ou en vivant dans un environnement enrichi.

Les réseaux d'apprentissage profond

[modifier | modifier le wikicode]À l'instar de la hiérarchie profonde du système visuel des primates, les architectures d'apprentissage approfondi tentent de modéliser des abstractions de haut niveau des données d'entrée en utilisant plusieurs niveaux de transformations non linéaires. Le modèle proposé par Hubel et Wiesel dans lequel les informations sont intégrées et propagées en cascade de la rétine et du LGN aux cellules simples et complexes en V1 a inspiré la création de l'une des premières architectures d'apprentissage en profondeur, le néocognitron -un modèle de réseau neuronal artificiel multicouche. Il a été utilisé pour différentes tâches de reconnaissance de formes, y compris la reconnaissance de caractères manuscrits. Cependant, la formation du réseau a pris beaucoup de temps (de l'ordre de plusieurs jours) et, depuis sa création dans les années 1980, l'apprentissage en profondeur n'a pas attiré l'attention jusqu'au milieu des années 2000 avec l'abondance des données numériques et l'invention des algorithmes d'entraînement accéléré. Les réseaux de neurones profonds se sont révélés très efficaces dans des tâches qui, il n'y a pas si longtemps, semblaient être réservées aux humains, telles que la reconnaissance des visages de personnes particulières sur des photos, la compréhension du discours humain (dans une certaine mesure) et la traduction de textes à partir de langues étrangères . En outre, ils se sont révélés très utiles dans l'industrie et la science pour rechercher des médicaments potentiels, cartographier les réseaux de neurones réels dans le cerveau et prédire les fonctions des protéines. Il faut noter que l'apprentissage en profondeur n'est inspiré que très vaguement par le cerveau et constitue bien davantage une réussite du domaine de l'informatique / apprentissage automatique que de celui des neurosciences. Les parallèles de base sont que les réseaux de neurones profonds sont composés d'unités qui intègrent les entrées d'informations de manière non linéaire (neurones) et s'envoient des signaux (synapses) et qu'il existe différents niveaux de représentations de plus en plus abstraites des données.

Les algorithmes d'apprentissage et les descriptions mathématiques des neurones utilisés dans l'apprentissage en profondeur sont très différents des processus réels se déroulant dans le cerveau. Par conséquent, la recherche en apprentissage en profondeur, tout en donnant une impulsion considérable à une intelligence artificielle plus sophistiquée, ne peut donner que des informations limitées sur le cerveau.

Sources

[modifier | modifier le wikicode]- Apprentissage profond dans le système visuel

- N. Kruger, « Deep Hierarchies in the Primate Visual Cortex: What Can We Learn for Computer Vision? », dans IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 35, no 8, August 2013, p. 1847–1871 [lien DOI]

- Tomaso Poggio, « (1 novembre 1999) », dans Nature Neuroscience, vol. 2, no 11, 1 November 1999, p. 1019–1025 [lien DOI](1 novembre 1999)

- Expérience d'inhibition des stimuli

- Keiji Tanaka, « Inferotemporal Cortex and Object Vision », dans Annual Review of Neuroscience, vol. 19, no 1, March 1996, p. 109–139 [lien DOI]

- Preuves de l'apprentissage dans le système visuel

- Nuo Li, « Unsupervised Natural Visual Experience Rapidly Reshapes Size-Invariant Object Representation in Inferior Temporal Cortex », dans Neuron, vol. 67, no 6, 23 September 2010, p. 1062–1075 [lien DOI]

- S. Raiguel, « Learning to See the Difference Specifically Alters the Most Informative V4 Neurons », dans Journal of Neuroscience, vol. 26, no 24, 14 June 2006, p. 6589–6602 [lien DOI]

- A Schoups, « Practising orientation identification improves orientation coding in V1 neurons. », dans Nature, vol. 412, no 6846, 2 August 2001, p. 549-53 [lien PMID]

- Vue d'ensemble récente et accessible de l'apprentissage profond

- Nicola Jones, « Computer science: The learning machines », dans Nature, vol. 505, no 7482, 8 January 2014, p. 146–148 [lien DOI]

Perception du mouvement

[modifier | modifier le wikicode]La perception du mouvement est le processus de déduction de la vitesse et de la direction des objets en mouvement. La zone V5 chez l'homme et la zone MT (région temporale moyenne) chez les primates sont responsables de la perception corticale du mouvement. La zone V5 fait partie du cortex extrastrié, qui est la région située dans la région occipitale du cerveau, à côté du cortex visuel principal. La zone V5 a pour fonction de détecter la vitesse et la direction des stimuli visuels et d’intégrer les signaux de mouvement visuels locaux au mouvement global. La région V1 ou cortex visuel primaire est située dans le lobe occipital du cerveau dans les deux hémisphères. Il traite la première étape du traitement cortical de l'information visuelle. Cette zone contient une carte complète du champ visuel couvert par les yeux. La différence entre la zone V5 et la zone V1 (Cortex visuel principal) est que la zone V5 peut intégrer le mouvement de signaux locaux ou de parties individuelles d'un objet dans le mouvement global d'un objet entier. La zone V1, en revanche, répond au mouvement local qui se produit dans le champ récepteur. Les estimations de ces nombreux neurones sont intégrées dans la zone V5.

Le mouvement est défini comme des changements dans l'illumination de la rétine dans l'espace et dans le temps. Les signaux de mouvement sont classés en mouvements de premier ordre et en mouvements de second ordre. Ces types de mouvement sont décrits brièvement dans les paragraphes suivants.

La perception du mouvement de premier ordre fait référence au mouvement perçu lorsque deux stimuli visuels ou plus s’allument et s’éteignent avec le temps et produisent des perceptions de mouvement différentes. Le mouvement de premier ordre est également appelé mouvement apparent, et est utilisé à la télévision et au cinéma. Le mouvement Beta en est un exemple, une illusion dans laquelle les images fixes semblent bouger, même si elles sont en réalité immobiles. Ces images donnent l’apparence d’un mouvement, car elles changent et se déplacent plus rapidement que ce que l’œil peut détecter. Cette illusion d'optique se produit parce que le nerf optique humain réagit à des changements de lumière à dix cycles par seconde, signifiant que tout changement plus rapide que cette fréquence sera enregistré comme un mouvement continu, et non comme des images séparées.

Le mouvement de second ordre fait référence au mouvement qui se produit lorsqu'un contour en mouvement est défini par un contraste, une texture, un scintillement ou toute autre qualité qui n'entraîne pas une augmentation de la luminance ou de l'énergie de mouvement de l'image. Différentes preuves suggèrent que le traitement initial des requêtes de premier ordre et des requêtes de second ordre est effectué par des voies distinctes. Les mécanismes de second ordre ont une résolution temporelle plus faible et se comportent en tant que filtre passe-bas en termes de gamme de fréquences spatiales auxquelles ils répondent. Le mouvement de second ordre produit un effet postérieur de mouvement plus faible. Les signaux de premier et de second ordre sont combinés au sein de la zone V5.

Dans ce chapitre, nous allons analyser les concepts de la perception du mouvement et de l’analyse du mouvement, et expliquer pourquoi ces termes ne doivent pas être utilisés de manière interchangeable. Nous analyserons les mécanismes par lesquels le mouvement est perçu, tels que les capteurs de mouvement et le suivi de charactéristiques. Il existe trois principaux modèles théoriques qui tentent de décrire la fonction des capteurs neuronaux de mouvement. Des tests expérimentaux ont été effectués pour confirmer l'exactitude de ces modèles. Malheureusement, les résultats de ces tests ne sont pas concluants et on peut dire qu'aucun de ces modèles ne décrit complètement le fonctionnement des capteurs de mouvement. Cependant, chacun de ces modèles simule certaines fonctionnalités des capteurs de mouvement. Certaines propriétés de ces capteurs sont décrites. Enfin, ce chapitre présente des illusions de mouvement, qui démontrent que notre sens du mouvement peut être induit en erreur par des facteurs externes statiques qui stimulent les capteurs de mouvement de la même manière que le ferait un vrai mouvement.

Analyse et perception du mouvement

[modifier | modifier le wikicode]Les concepts d'analyse de mouvement et de perception du mouvement sont souvent confondus. La perception et l'analyse du mouvement sont importantes l'une pour l'autre, mais elles ne sont pas identiques.

L'analyse de mouvement fait référence aux mécanismes dans lesquels les signaux de mouvement sont traités. De la même manière que la perception du mouvement ne dépend pas nécessairement des signaux générés par le mouvement des images dans la rétine, l'analyse du mouvement peut ou non conduire à la perception du mouvement. Un exemple de ce phénomène est la vection, qui se produit lorsqu'une personne perçoit qu'elle bouge alors qu'elle est immobile, mais qu’en vérité, l'objet qu'elle observe est en mouvement. La vection montre que le mouvement d'un objet peut être analysé, même s'il n'est pas perçu comme un mouvement provenant de l'objet. Cette définition de l'analyse de mouvement suggère que le mouvement est une propriété fondamentale de l'image. Dans le champ visuel, il est analysé à chaque point. Les résultats de cette analyse sont utilisés pour dériver des informations perceptuelles.

La perception du mouvement désigne le processus d’acquisition de connaissances perceptuelles sur le mouvement d’objets et de surfaces dans une image. Le mouvement est perçu soit par des capteurs locaux délicats dans la rétine, soit par suivi de caractéristiques. Les capteurs de mouvement locaux sont des neurones spécialisés sensibles au mouvement et analogues aux capteurs spécialisés de couleur. Le suivi de charactéristiques est un moyen indirect de percevoir le mouvement. Il consiste à déduire le mouvement des modifications de la position rétinienne des objets au fil du temps. On parle également d'analyse de mouvement de troisième ordre. Le suivi de charactéristiques fonctionne en focalisant l'attention sur un objet particulier et en observant l'évolution de sa position au fil du temps.

Capteurs de mouvement

[modifier | modifier le wikicode]La détection de mouvement est la première étape du traitement visuel. Elle se produit grâce à des processus neuronaux spécialisés, qui répondent aux informations concernant les changements locaux d'intensité des images au fil du temps. Le mouvement est détecté indépendamment des autres propriétés de l'image à chaque point de l'image. Il a été prouvé que des capteurs de mouvement existent et fonctionnent localement à tous les points de l’image. Les capteurs de mouvement sont des capteurs neuronaux dédiés situés dans la rétine et capables de détecter un mouvement produit par deux brefs et faibles flashs lumineux si proches qu'ils ne pourraient pas être détectés par le suivi de caractéristiques. Il existe trois modèles principaux qui tentent de décrire le fonctionnement de ces capteurs spécialisés. Ces modèles sont indépendants les uns des autres et tentent de modéliser les caractéristiques spécifiques de la perception du mouvement. Bien qu’il n’existe pas suffisamment de preuves permettant de penser qu’un de ces modèles représente la façon dont le système visuel (en particulier les capteurs de mouvement) perçoit le mouvement, ils modélisent néanmoins correctement certaines fonctions de ces capteurs.

Le Détecteur Reichardt

Le détecteur Reichardt est utilisé pour modéliser la façon dont les capteurs de mouvement répondent aux signaux de mouvement du premier ordre. Lorsqu'un objet se déplace d'un point A du champ visuel à un point B, deux signaux sont générés: un avant le début du mouvement et un autre après la fin du mouvement. Ce modèle perçoit ce mouvement en détectant les changements de luminance en un point de la rétine et en le corrélant avec un changement de luminance en un autre point à proximité après un court délai. Le détecteur Reichardt fonctionne selon le principe de corrélation (relation statistique qui implique une dépendance). Il interprète un signal de mouvement par corrélation spatio-temporelle des signaux de luminance aux points voisins. Il utilise le fait que deux champs récepteurs situés à différents points de la trajectoire d'un objet en mouvement reçoivent une version décalée du même signal - un diagramme de luminance se déplace le long d'un axe et le signal en un point de l'axe est une version décalée du temps un signal précédent dans l'axe. Le modèle de détecteur Reichardt comporte deux détecteurs voisins séparés dans l'espace. Les signaux de sortie des détecteurs sont multipliés (corrélés) de la manière suivante: un signal multiplié par un deuxième signal qui est la version décalée dans le temps de l'original. La même procédure est répétée mais dans le sens inverse du mouvement (le signal qui a été décalé dans le temps devient le premier signal et inversement). Ensuite, la différence entre ces deux multiplications est prise en compte et le résultat donne la vitesse du mouvement. La réponse du détecteur dépend de la phase, du contraste et de la vitesse du stimulus. De nombreux détecteurs réglés à différentes vitesses sont nécessaires pour coder la vitesse réelle du motif. La preuve expérimentale la plus convaincante de ce type de détecteur provient d'études sur la discrimination de la direction de cibles à peine visibles.

Filtrage d'énergie de mouvement

Le filtre d’énergie de mouvement est un modèle de capteurs de mouvement basé sur le principe des filtres invariants de phase. Ce modèle construit des filtres spatio-temporels orientés dans l'espace-temps pour correspondre à la structure des motifs en mouvement. Il est constitué de filtres séparables, pour lesquels les profils spatiaux conservent la même forme dans le temps mais sont mis à l'échelle par la valeur des filtres temporels. Les filtres d'énergie de mouvement correspondent à la structure des motifs en mouvement en ajoutant des filtres séparables. Pour chaque direction de mouvement, deux filtres espace-temps sont générés: un filtre symétrique et un filtre asymétrique. La somme des carrés de ces filtres est appelée énergie de mouvement. La différence de signal entre les deux directions s'appelle l'énergie adverse. Ce résultat est ensuite divisé par la sortie au carré d'un autre filtre, qui est réglé sur le contraste statique. Cette division est effectuée pour prendre en compte l'effet de contraste dans le mouvement. Les filtres d'énergie de mouvement peuvent modéliser un certain nombre de phénomènes de mouvement, mais ils produisent une mesure indépendante de la phase, qui augmente avec la vitesse mais ne donne pas une valeur fiable de la vitesse.

Gradients spatio-temporels

Ce modèle de capteurs de mouvement a été développé à l'origine dans le domaine de la vision par ordinateur. Il est basé sur le principe que le rapport de la dérivée temporelle de la luminosité de l'image sur la dérivée spatiale de la luminosité de l'image correspond à la vitesse de déplacement. Il est important de noter que dans les pics et les creux de l'image, ce modèle ne calculera pas une réponse adéquate, car la dérivée du dénominateur serait zéro. Afin de résoudre ce problème, les dérivées spatiales du premier ordre et d'ordres supérieurs en termes d'espace et de temps peuvent également être analysées. Les gradients spatio-temporels sont un bon modèle pour déterminer la vitesse de déplacement en tout point de l'image.

Les capteurs de mouvement sont sélectifs en orientation

[modifier | modifier le wikicode]L'une des propriétés des capteurs de mouvement est la sélectivité par rapport à l'orientation, qui limite l'analyse de mouvement à une seule dimension. Les capteurs de mouvement ne peuvent enregistrer le mouvement que dans une dimension le long d'un axe orthogonal à l'orientation préférée du capteur. Un stimulus contenant des caractéristiques d’une seule orientation ne peut se déplacer que dans une direction orthogonale à l’orientation du stimulus. Les signaux de mouvement unidimensionnels fournissent des informations ambiguës sur le mouvement des objets bidimensionnels. Une deuxième étape d'analyse du mouvement est nécessaire afin de déterminer la direction réelle du mouvement d'un objet ou modèle à deux dimensions. Les signaux de mouvement 1-D provenant de capteurs réglés selon différentes orientations sont combinés pour produire un signal de mouvement 2-D non ambigu. L'analyse du mouvement 2D dépend des signaux des capteurs locaux à orientation large ainsi que des signaux des capteurs à orientation étroite.

Suivi de charactéristiques

[modifier | modifier le wikicode]Une autre façon de percevoir le mouvement consiste à utiliser le suivi de charactéristiques. Le suivi de charactéristiques consiste à analyser si les caractéristiques locales d'un objet ont changé de position et à en déduire un mouvement. Dans cette section, certaines fonctionnalités des suivis de fonctionnalités sont mentionnées.

Les outils de suivi de charactéristiques échouent lorsqu'un mouvement-stimulus se produit très rapidement. Par rapport aux capteurs de mouvement, les détecteurs de suivi de charactéristiques ont l'avantage qu'ils peuvent percevoir le mouvement d'un objet même si le mouvement est interrompu par des intervalles intermittents sans réel signal. Ils peuvent également séparer ces deux phases (mouvements et intervalles vides). Les capteurs de mouvement, d'autre part, intégreraient simplement les phases vides avec le stimulus en mouvement et observeraient un mouvement continu. Les détecteurs pour suivi de charactéristiques opèrent sur la localisation des charactéristiques identifiées. Pour cette raison, ils ont un seuil de distance minimum qui correspond à la précision avec laquelle les emplacements des charactéristiques peuvent être distingués.

Les détecteurs pour suivi de charactéristiques ne montrent pas les effets secondaires de mouvement, qui sont des illusions visuelles causées par une adaptation visuelle. Les effets secondaires de mouvement se produisent lorsque, après avoir observé un stimulus en mouvement, un objet immobile semble se déplacer dans la direction opposée de celle du stimulus en mouvement observé précédemment. Il est impossible pour ce mécanisme de surveiller plusieurs mouvements simultanément et dans différentes parties du champ visuel. D'autre part, les mouvements multiples ne posent pas de problème aux capteurs de mouvement, car ils fonctionnent en parallèle sur tout le champ visuel.

Des expériences ont été menées en utilisant les informations susmentionnées pour parvenir à des conclusions intéressantes sur les détecteurs de suivi de caractéristiques. Des expériences avec de brefs stimuli ont montré que les motifs de couleur et les motifs de contraste très contrastés ne sont pas perçus par les suiveurs de caractéristiques, mais par les capteurs de mouvement. Des expériences avec des phases sans signal ont confirmé que le suivi de charactéristiques peut se produire avec des intervalles sans signal dans l'affichage. Ce n'est qu'à contraste élevé que les capteurs de mouvement perçoivent le mouvement de stimuli chromatiques et de stimuli de motifs de contraste. À faible contraste, les détecteurs analysent le mouvement des motifs chromatiques et des enveloppes de contraste et, à fort contraste, les capteurs de mouvement analysent les enveloppes de contraste. Les expériences dans lesquelles les sujets jugent plusieurs mouvements suggèrent que le suivi des caractéristiques est un processus qui se déroule sous contrôle conscient et que c'est le seul moyen d'analyser le mouvement des enveloppes de contraste dans des conditions à faible contraste. Ces résultats sont cohérents avec l’idée selon laquelle le mouvement des enveloppes et des motifs de couleur contrastés dépend du suivi des caractéristiques, sauf lorsque les couleurs sont bien supérieures au seuil de détection ou que le contraste moyen est élevé. La principale conclusion de ces expériences est que le suivi des caractéristiques permet probablement de percevoir les enveloppes de contraste et les motifs de couleur.

Illusions de mouvement

[modifier | modifier le wikicode]

En conséquence du processus de détection de mouvement, certaines images statiques peuvent nous sembler bouger. Ces images donnent un aperçu des hypothèses exprimées par le système visuel et sont appelées illusions visuelles.

Une illusion de mouvement célèbre liée aux signaux de mouvement de premier ordre est le phénomène Phi, qui est une illusion d'optique qui nous fait percevoir un mouvement au lieu d'une séquence d'images. Cette illusion de mouvement nous permet de regarder des films comme un continuum et non comme des images séparées. Le phénomène phi permet à un groupe d'images figées qui sont modifiées à une vitesse constante d'être considéré comme un mouvement constant. Le phénomène Phi ne doit pas être confondu avec le mouvement Bêta, car il s’agit d’un mouvement apparent provoqué par des impulsions lumineuses successives, tandis que le dernier est un mouvement apparent causé par des impulsions stationnaires lumineuses.

Les illusions de mouvement se produisent lorsque la perception du mouvement, l'analyse du mouvement et l'interprétation de ces signaux sont trompeuses et que notre système visuel crée des illusions concernant le mouvement. Ces illusions peuvent être classées selon le processus qui les cause. Les illusions sont classées comme des illusions liées à la détection de mouvement, à l'intégration 2D et à l'interprétation 3D.

Les illusions les plus courantes concernant la détection de mouvement sont les mouvements à quatre temps, les «Random Dot Kinetmatograms» et les illusions de signaux de mouvement de second ordre. Les illusions de mouvement les plus populaires en matière d'intégration 2D sont «Motion Capture», «Plaid Motion» et «Direct Repulsion». De la même manière, celles qui concernent l'interprétation 3D sont les suivantes: «Transformational Motion», «Kinetic Depth», «Shadow Motion», «Biological Motion», «Stereokinetic motion», «Implicit Figure Motion» et la «2 Stroke Motion». Il y a beaucoup plus d'illusions de mouvement, et elles montrent toutes quelque chose d'intéressant concernant les mécanismes de détection, de perception et d'analyse du mouvement humain. Pour plus d'informations, visitez le lien suivant: http://www.lifesci.sussex.ac.uk/home/George_Mather/Motion/

Problèmes ouverts

[modifier | modifier le wikicode]Bien que nous ne comprenions toujours pas la plupart des spécificités de la perception du mouvement, comprendre les mécanismes par lesquels le mouvement est perçu ainsi que les illusions de mouvement peuvent donner au lecteur un bon aperçu de l’état de l’art dans le sujet. Certains des problèmes ouverts concernant la perception du mouvement sont les mécanismes de formation des images 3D dans le mouvement global et le problème de l'ouverture.

Les signaux de mouvement global de la rétine sont intégrés pour aboutir à un signal de mouvement global à 2 dimensions; cependant, on ignore comment se forme le mouvement global 3D. Le problème de l'ouverture se produit parce que chaque champ réceptif dans le système visuel ne couvre qu'une petite partie du monde visuel, ce qui crée des ambiguïtés dans la perception. Le problème de l'ouverture concerne le problème qu'un contour en mouvement qui correspond à différentes possibilités de mouvement, lorsqu'il est observé localement. Cette ambiguïté est d'origine géométrique - les mouvements parallèles au contour ne peuvent pas être détectés, car les modifications apportées à cette composante du mouvement ne modifient pas les images observées par l'ouverture. La seule composante pouvant être mesurée est la vitesse orthogonale à l’orientation du contour; pour cette raison, la vitesse du mouvement pourrait être quelque chose de la famille des mouvements le long d'une ligne dans l'espace de la vitesse. Ce problème de l’ouverture n’est pas seulement observé dans les contours droits, mais également dans les contours aux courbes douces, puisqu’ils sont approximativement rectilignes lorsqu’ils sont observés localement. Bien que les mécanismes permettant de résoudre le problème d’ouverture soient encore inconnus, il existe certaines hypothèses sur la manière de le résoudre. Par exemple, il pourrait être possible de résoudre ce problème en combinant des informations sur l’espace ou à partir de contours différents du même objet.

Conclusions