Mémoire/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/M%C3%A9moire

L'apprentissage

Les premières études sur la mémoire humaine ont été réalisées par Hermann Ebbinghaus, un philosophe/psychologue allemand des années 1885, qui a été le premier à créer une méthode expérimentale fiable pour étudier la mémoire. Le protocole expérimental d'Ebbinghaus consistait à mémoriser une liste de mots appris par cœur. Pour éviter tout biais ayant trait à la complexité des mots ou aux associations qu'ils peuvent entretenir, il décida de n'utiliser que des syllabes sans aucun sens, organisées en consonne-voyelle-consonne, dont la consonne ne se répète pas. Cela donnait des mots comme YAT, DUS, MIK, etc. Il créa ainsi 2300 de ces mots, écrits sur des morceaux de papier, et commença les expériences. Les expériences se passaient comme suit : il choisissait un morceau de papier au hasard, lisait le mot à haute voix, avec la même intonation à chaque fois, et rangeait le papier avant de passer au mot suivant. À chaque fois, le nombre de mots tirés du box était choisi au hasard. À la fin de la procédure, il prenait un morceau de papier et notait dessus tous les mots dont il se rappelait. Ses investigations lui prirent un grand nombre de répétition, mais elles ne furent pas vaines. Ebbinghaus remarqua quelques régularités dans les mots dont il se rappelait.

De nos jours, les scientifiques utilisent des protocoles similaires à celui d'Ebbinghaus, mais utilisent des items différents. Les scientifiques ne s'interdisent plus d'utiliser des items qui ont un sens, comme des mots, des phrases, des textes complets, des images, etc. De plus, les protocoles utilisés sont un peu plus nombreux que la simple tâche d'Ebbinghaus, chaque protocole étudiant une forme particulière de mémorisation. Ces protocoles sont différents et les sujets n'ont naturellement pas les mêmes performances selon le protocole utilisé. Les résultats peuvent changer du tout au tout suivant le protocole utilisé, ce qui donne des indices quant au fonctionnement de la mémoire.

Lorsque le sujet doit apprendre une liste d'items et qu'il est interrogé immédiatement après l'apprentissage, on parle de rappel immédiat. Ce rappel immédiat est à opposer aux tâches de rappel différé, où le sujet est testé après quelques minutes après l'apprentissage de la liste. Le rappel immédiat est largement plus facile que le rappel différé. Avec le rappel différé, le sujet a le temps d'oublier la liste apprise avec le rappel différé, mais pas en rappel immédiat. De plus, le rappel peut se faire dans un ordre différent de celui de la liste : on parle de rappel libre, à opposer au rappel sériel où le sujet doit rappeler les items dans l'ordre de présentation. Le rappel libre est nettement plus facile que le rappel sériel, pour diverses raisons : l'ordre des items n'est pas à mémoriser, l'oubli d'un item ne nuit par au rappel des suivants, etc.

L'effet de la répétition

[modifier | modifier le wikicode]Il semble évident que la répétition est importante pour la mémorisation. On se souvient tous de notre scolarité, des heures passées à réviser nos cours, à revoir sans cesse les notions et exercices déjà vus ou faits. Beaucoup d'élèves ont souvent pesté sur la difficulté qu'il y a à apprendre un cours parfaitement. Il faut dire qu'apprendre par cœur un grand nombre d'informations prend du temps, beaucoup de répétitions et d'efforts. Beaucoup aimeraient que ce ne soit pas le cas et il n'est pas rare que les élèves recherchent des méthodes plus efficaces pour mémoriser, afin d'y passer moins de temps. Mais force est de constater que la répétition est malgré tout un bon moyen pour mémoriser des informations, surtout si celles-ci n'ont pas vraiment de sens. Il va de soi que plus de temps passé à réviser quelque chose a un effet positif : mieux vaut passer quatre heures à revoir quelque chose que d'y passer seulement une heure. Et si les intuitions sont souvent trompeuses, ce n'est pas le cas ici. Plus on répète quelque chose, plus on s'en souvient : la répétition consolide les connaissances et souvenirs acquis.

Cela n'étonnera sans doute pas grand monde, mais les sciences demandent que toute hypothèse soit vérifiée, confirmée. Ebbinghaus a été le premier à confirmer l'effet de la répétition sur l'apprentissage, avec ses expériences. D'autres vérifications sont venues d'expériences plus récentes, et notamment par l'étude de Bahrick et Al. Pour cette étude, les chercheurs ont regroupé plusieurs élèves de leur ancienne université et leur ont fait passer des tests pour vérifier ce qu'ils avaient retenu de leurs anciens cours d'espagnol. Certains élèves avaient eu peu de cours d'espagnol, alors que d'autres en avaient eu beaucoup plus (une histoire d'années d'études et d'options, assez spécifique aux universités américaines). Les tests étaient assez simples et se limitaient à des questions de vocabulaire du style : "Comment dit-on le mot chien en espagnol ?" ou inversement. En plus des résultats aux tests, les chercheurs ont amassé des données sur le nombre d'heures de cours suivis par les sujets, ainsi que d'autres variables. Les chercheurs ont alors analysé les résultats et ont remarqué une bonne corrélation entre les résultats des tests et le nombre de cours passés par les participants. Ceux qui avaient vu une seule fois les mots dans leur scolarité avait un taux de rappel de presque zéro, ceux qui les avaient vu trois fois atteignaient 30 %, et deux qui avaient vu cinq fois ces mots durant leur scolarité atteignaient 60 % de réussite.

L'influence du nombre de répétitions

[modifier | modifier le wikicode]Cependant, on peut se demander si la répétition a un rendement stable, croissant ou décroissant. Prenons l'exemple d'un élève qui étudie une langue étrangère et doit mémoriser une liste de 500 mots étrangers (cela doit vous rappeler des souvenirs des cours d'anglais/allemand/espagnol au collège). Mettons qu'il ait réussi à mémoriser 50 mots suite à une heure d'apprentissage. À votre avis, quel est l'effet d'une heure de révision supplémentaire sur la mémorisation ? Il y a alors trois possibilités, selon qu'on envisage un rendement stable, croissant ou décroissant. Avec un rendement stable, chaque heure supplémentaire permettra de mémoriser 50 mots. L'élève aura donc mémorisé 50 mots à l'issue de la première heure d'apprentissage, 100 après la seconde, 150 après la troisième, etc. Dit autrement, l'effet du temps d'apprentissage est linéaire, chaque répétition ayant le même effet que les précédentes. Si on double le temps d'apprentissage, on peut alors apprendre deux fois plus de choses. La qualité de mémorisation dépend alors du temps passé à revoir, à répéter le matériel à apprendre. Derrière cette constatation, se cache une hypothèse assez intéressante : la mémorisation dépend essentiellement du nombre de répétitions, du temps passé à revoir ce qu'on a appris.

Une telle hypothèse est appelée l'hypothèse du temps total. Une autre possibilité est que le rendement est décroissant. Pour reprendre l'exemple précédent, l'élève aura appris 50 mots après la première heure, mais moins de 100 mots après la seconde heure, bien moins de 150 mots après la troisième heure, etc. Chaque heure d'apprentissage a alors moins d'effet que les précédentes. Au bout d'un certain temps, il ne sert plus à grand-chose de continuer à revoir ce qu'on a appris. À l'inverse, on peut supposer un effet croissant avec le temps : l'élève aura appris 50 mots après une heure, 110 après 2 heures, 190 après trois heures, etc. Dans ce cas, plus on sait de choses, plus on peut en apprendre de nouvelles facilement. L'apprentissage a alors un effet cumulatif et chaque heure d'apprentissage supplémentaire a un rendement supérieur aux précédentes.

Départager ces possibilités demande naturellement des expériences scientifiques contrôlées comme il se doit. Ebbinghaus chercha à savoir quel était l'influence du nombre de répétitions. Pour le savoir, il compara le taux de rappel obtenu un jour après l'apprentissage de plusieurs listes de 16 syllabes. Ces listes étaient revues respectivement 8, 16, 24, 32, 42, 53, et 64 fois. Le bilan était clair : le taux de rappel d'une liste était directement proportionnel au nombre de répétitions de celle-ci. Cela semble donc confirmer l'hypothèse du temps total. Mais on pourrait rétorquer que les items à apprendre pourraient biaiser quelque peu les résultats. Peut-être que l'hypothèse du temps total marche bien pour l'apprentissage de listes de syllabes sans aucun sens, mais échouerait pour d'autres formes d'apprentissage. Aussi, d'autres formes d'expériences sont nécessaires pour conclure. Et force est de constater que l'hypothèse du temps total, bien qu'assez réaliste, ne fonctionne pas dans de nombreux cas. Le reste du chapitre sera d'ailleurs consacré à mettre en défaut cette hypothèse.

La méthode du Sur-apprentissage

[modifier | modifier le wikicode]Dans les premières expériences utilisant les courbes de l'oubli, Ebbinghaus a remarqué que le sur-apprentissage, à savoir continuer à revoir le matériel à apprendre une fois que celui-ci est totalement su, permettait de mémoriser plus longtemps et de diminuer l'oubli avec le temps. Expérimentalement, cette technique marche, mais les effets semblent s'estomper après quelques semaines, voire quelques mois. L'étude ("The Effect of Overlearning on Long-Term Retention") a demandé à des étudiants de retenir des faits géographiques et des définitions de mots. Les étudiants qui avaient sur-appris retenaient mieux, mais les effets s'estompaient assez rapidement, quelques semaines plus tard. Une autre de ces études (The Effects of Overlearning and Distributed Practise on the Retention of Mathematics Knowledge) a testé la même chose, mais pour des exercices de mathématique. Le bilan est le même : pas d'effets à long terme.

Le ré-apprentissage est plus facile que l'apprentissage initial

[modifier | modifier le wikicode]Dans ses expériences, Ebbinghaus remarqua aussi que le ré-apprentissage était plus facile suivant le nombre de répétitions. Dans ses expériences, il apprenait des listes de syllabes, en contrôlant le nombre de répétitions, et regardait combien de temps il lui fallait pour réapprendre l'intégralité de la liste, une fois celle-ci totalement oubliée. Les résultats montrent le réapprentissage est plus rapide que le premier apprentissage. Tout que tout se passe comme si les informations oubliées n'étaient pas totalement perdues et effacées de la mémoire : il en subsisterait une trace dans le cerveau qui peut faciliter les ré-apprentissages ultérieurs. On verra que cette interprétation a un sens particulièrement profond dans les théories récentes de la mémoire.

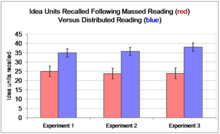

L'effet de distribution de l'apprentissage

[modifier | modifier le wikicode]Ebbinghaus a aussi regardé s'il y avait une différence entre l'apprentissage massé, et l'apprentissage distribué. L'apprentissage massé consiste à apprendre le matériel sur une durée continue, tandis que l'apprentissage distribué consiste à faire de nombreuses pauses et à voir le matériel morceau par morceau. Expérimentalement, il a constaté que l'apprentissage distribué devançait de loin l'apprentissage massé : le seul fait de distribuer l'apprentissage peut permettre d'améliorer la mémorisation de plusieurs ordres de grandeurs. Cette supériorité de la distribution sur l'apprentissage massé s'appelle l'effet de distribution de l'apprentissage. Les origines de cet effet ne sont pas claires : il semblerait que cet effet aurait plusieurs explications. Ceci dit, ce phénomène est particulièrement robuste, et apparait dans de nombreuses formes d'apprentissage.

Le Testing effect

[modifier | modifier le wikicode]D'autres observations de la même trempe, bien que non-découvertes par Ebbinghaus, sont cependant intéressantes à étudier. Celle qui va suivre en fait partie. Expérimentalement, on constate que le fait de se rappeler de quelque chose le consolide en mémoire, le rendant plus résistant à l'oubli : c'est ce qu'on appelle le Testing effect. En somme, les informations qu'on retient le mieux sont celles dont on s'est rappelées souvent, pas celles que l'on a revues ou relues souvent.

Pour donner un exemple, prenons une expérience effectuée par des chercheurs de l'université de St-Louis, aux USA. Ils ont demandé à trois groupes d'élèves de mémoriser une liste de 50 mots. Le premier devait bachoter durant 8 séances, le second devait bachoter durant 6 séances et se faire tester dans deux autres, et le troisième groupe devait bachoter durant 4 séances et se faire tester durant 4 séances. Une semaine plus tard, plus un groupe s'était fait tester, meilleurs étaient ses résultats. Autre expérience, réalisée par Roediger & Karpicke. On demande à des étudiants de lire des textes scientifiques relativement courts. Le premier groupe devait lire le texte 4 fois, le second groupe lisait le texte trois fois et se faisait tester une fois, tandis que le troisième groupe avait droit à une seule lecture et trois interrogations. Une semaine plus tard, les trois groupes étaient testés : plus un groupe avait été testé, mieux c'était : le troisième groupe réussissait même à rappeler 50 de mots en plus que le premier groupe. Les raisons de cet effet ne sont pas très claires à l'heure actuelle.

L'effet de génération

[modifier | modifier le wikicode]Les recherches sur la mémoire ont aussi mis en évidence un effet appelé effet de génération. Celui-ci fait que l'on retient mieux quelque chose que l'on a créé soi-même, comparé à du matériel simplement lu ou écouté. Cet effet fût découvert par Slamecka & Graf, en 1978, dans une étude comportant cinq expériences. Celle-ci était basée sur un protocole simple : quatre groupes de sujets devaient étudier une liste de mots, chacun d'une manière différente. Les premiers groupes devaient simplement lire une liste de paires de mots donnée par l'expérimentateur. Les autres groupes recevaient la même liste de mots, mais qui était partiellement remplie : ils devaient générer le second mot de chaque paire en suivant certaines règles (trouver un mot qui rime, qui est de la même catégorie, ou qui était opposé, etc). Quelques lettres étant données en indice : unhappy - s _ _, not slow - f _ _ t, etc. Si l'on compare les groupes "lecture" et "génération", on s’aperçoit que le groupe qui a créé les seconds mots d'une paire a un taux de rappel supérieur aux autres groupes. Dans une seconde expérience, les chercheurs ont montré que cet effet demeurait quand les sujets n'étaient pas prévenus qu'ils seraient interrogés sur leur mémorisation du matériel (dans une tâche de rappel incident). Une troisième expérience fondée sur un protocole similaire a permis de réfuter le fait que l'effet de génération pourrait avoir des causes attentionnelles.

D'autres expériences ont cherché à évaluer cet effet de génération sur d'autres formes de matériel : images, résolution de problèmes arithmétiques, génération des mots-clés d'un paragraphe, etc. L'effet semble marcher, mais pas pour tout type de matériel. Par exemple, les mots peuvent donner lieu à un effet de génération, mais pas les suites de syllabes sans signification, comme les pseudo-mots (bragab, chmorglub, etc). De manière générale, on trouve un effet de génération dans certaines circonstances, mais pas dans d'autres. L'apparition de l'effet de génération semble très lié au protocole d'études, à la manière dont les sujets sont testés. Beaucoup de détails influencent l'intensité de l’effet de génération et son apparition demande que diverses conditions soient réunies.

Notons que dans toutes les expériences sur l'effet de génération, la consigne donnée aux sujets contient des contraintes qui guident le sujet pour générer ce qui est demandé, ce qui est voulu par l'expérimentateur. Et en plus de cela, les quelques lettres données en indice aident le sujet à trouver la bonne solution. Par exemple, l'expérimentateur peut fournir un mot, fournir quelques lettres en indice et demander à ce qu'on donne un antonyme : le fait de demander un antonyme est la contrainte de l'énoncé. Le nombre de contraintes varie beaucoup suivant l'expérience, et il semblerait que cela influence l'intensité de l'effet de génération. Une bonne partie de la recherche sur le sujet se penche sur l'effet modérateur du nombre de contraintes.

Les explications de l'effet de génération ne sont pas encore bien comprises. Les théories sur l'effet de génération sont au nombre d'une dizaine, mais les données ne permettent pas encore de trancher franchement. L'explication la plus simple est simplement que générer un item demande plus d'efforts mental, ce aurait un effet positif sur la mémorisation. Aussi vague que soit cette théorie, elle est quand testable : il suffit de demander aux sujets de noter l'effort fournit pour générer tel ou tel item et d'étudier la corrélation entre effort demandé et résultats, pour chaque item. Elle est assez faible, ce qui ne va pas dans le sens de la théorie. Une autre explication, assez similaire, est que l'effet de génération serait juste un artefact du protocole d'étude. Cette explication sert surtout à expliquer pourquoi le même sujet aurait de meilleures performances dans les expériences où on lui demande de générer certains items et d'en mémoriser d'autres. Les sujets se focaliseraient sur les items à générer, au lieu des items à mémoriser, en leur allouant plus de "ressources cognitives" (plus d'attention, notamment). D'autres explications se basent sur le caractère fortement associatif et relationnel de la mémoire, que nous aborderons dans les prochains chapitres, et ne peuvent pas être abordées pour le moment.

Les effets de position sérielle

[modifier | modifier le wikicode]Ebbinghaus fût aussi le premier à découvrir les effets de position sérielle, qui apparaissent dans les tâches de rappel libre. On observe alors que les items au début et à la fin de la liste sont nettement plus rappelés que ceux du milieu.

Le fait que les mots au début de la liste soient mieux mémorisés s'appelle le l'effet de primauté. Il apparaît aussi bien dans les tâches de rappel immédiat que différé. Il provient du fait que les éléments du début de la liste ont pu être répétés mentalement par le cobaye plus souvent que les autres, durant toute la durée de l'expérience, facilitant leur mémorisation. Pour obtenir une véritable preuve expérimentale, les psychologues ont demandé à des groupes de cobayes de prononcer à haute voix les mots qu'ils répétaient lors de la présentation de la liste. Le bilan est clair : les premiers éléments de la liste sont répétés plus souvent que les autres. Qui plus est la corrélation entre nombre de répétition et taux de rappel est presque parfaite.

Les mots présentés en dernier sont aussi rappelés plus souvent que les autres : c'est l'effet de récence. La probabilité de rappel est même supérieure à celle observée avec l'effet de primauté. Cet effet de récence est sensible à plusieurs paramètres. Par exemple, augmenter la longueur de la liste ou diminuer la vitesse de lecture n'a aucune incidence sur l'effet de récence. Le nombre d'éléments rappelés dans ces conditions est relativement stable chez une même personne. Il ne dépasse jamais les 10 mots, la moyenne tournant autour de 7 items, + ou - 2.

Enfin, un troisième effet apparaît souvent dans les tâches de rappel libre, où le sujet n'est pas censé rappeler les items dans l'ordre de la liste. On pourrait croire que celui-ci les rappellera dans le désordre total, ou tout du moins sans les rappeler dans l'ordre. Mais le fait est que le sujet a tendance à rappeler des items consécutifs les uns après les autres, que ce soit par paires ou par blocs d'items consécutifs. Rien d'étonnant, mais cela reste une régularité à expliquer et les scientifiques lui ont donné le nom d'effet de contiguïté.

Le modèle modal d'Atkinson et Shiffrin

Bien que connu depuis Ebbinghaus, l'explication des effets de récence et de primauté est longtemps resté un mystère. Murdock, dans son étude de 1962, a suggéré une hypothèse intéressante, qui permet d'expliquer l'effet de récence : l'existence d'une mémoire à court terme de capacité limitée, qui ne dure que quelques secondes. Cette mémoire à court-terme serait à opposer à la mémoire plus durable, celle du langage commun, appelée mémoire à long-terme. Les derniers éléments rappelés seraient accessibles depuis la mémoire à court terme, tandis que les autres doivent être repêchés depuis la mémoire à plus long terme. L'effet de récence étant de 7 items, on en déduit facilement que la taille de la mémoire à court-terme serait de cet ordre : 7 items, plus ou moins deux. Cette interprétation est aujourd'hui nuancée, pour des raisons que nous aborderons plus tard.

Reste que l'existence d'une telle mémoire restait à confirmer. Ce fut fait par l'étude de Glanzer et Cunitz, datée de 1966. Dans cette expérience, deux groupes de sujets devaient apprendre une liste de mots. Cependant, le premier groupe était testé dans une tâche de rappel immédiat, alors que l'autre était testé via un rappel différé. Plus précisément, le second groupe recevait une tâche entre l'apprentissage de la liste de mots et son rappel. Les sujets devaient compter à l'envers de trois en trois, à voix haute, durant un certain temps. Une telle tache, intercalée entre rappel et apprentissage, porte le nom de tâche de Brown-Peterson. Le fait est que l'effet de récence apparaît bien en rappel immédiat, mais disparaît presque totalement en rappel différé avec tâche de Brown-Peterson. L'interprétation de ce résultat est que la tâche de Brown-Peterson a vidé la mémoire à court-terme, supprimant ainsi l'origine de l'effet de récence. Ceci dit, la tâche de Brown-Peterson ne supprime pas totalement l'effet de récence. Il est un effet de récence résiduel, extrêmement faible mais existant. Celui-ci aurait une origine indépendante de l'existence de la mémoire à court-terme, mais celle-ci est encore mal connue.

Par la suite, d'autres expériences ont amené à la conceptualisation d'un autre type de mémoire temporaire, encore plus bref que la MCT : la mémoire sensorielle. De cette constatation, le modèle modal d'Atkinson et Shiffrin est apparu. Dans ce modèle, on retrouve aussi bien les mémoires sensorielles, que la mémoire à long terme et la mémoire à court terme. La mémoire à long-terme, abréviée MLT, est peu développée dans la théorie d'Atkinson et Shiffrin. La théorie dit juste qu'il s'agit d'une mémoire de longue durée, dont la capacité est très importante. Il faut dire que la théorie s'intéresse seulement au transfert des informations de la MCT vers la MLT, à savoir la mémorisation, aussi appelée encodage. L'idée est notamment que l'encodage dépend essentiellement du temps que l'item à mémoriser passe dans la MCT. Plus ce temps est long, plus l'encodage a de chances d'avoir lieu. La répétition mentale, en permettant de rafraîchir les items en MCT, favoriserait l'encodage.

Le registre sensoriel

[modifier | modifier le wikicode]

La mémoire sensorielle a été mise en évidence par diverses expériences, au début du siècle dernier. Dans les grandes lignes, elle peut retenir une quantité d'informations sensorielles impressionnante, mais la durée de rétention est très brève, inférieure à la seconde. Le contenu de cette mémoire n'est pas perçu consciemment. Un certain traitement automatique est effectué sur le contenu de ces mémoires, avant leur transfert en mémoire à court-terme. Ce peut être des processus de détection des contours d'objets pour la mémoire visuelle, des processus de détection de la tonalité ou de l’intensité sonore pour la mémoire auditive, etc. Le transfert en MCT des informations sensorielles se fonde essentiellement sur l'attention, notre capacité à nous concentrer. Celle-ci va faire un tri des items sensoriels pour n'en retirer que les informations essentielles, celle-ci passant en MCT. Le reste n'atteint pas la conscience et est oubliée.

Dans la théorie originale d'Atkinson et Shiffrin, le registre sensoriel est vu comme un système unitaire, capable de mémoriser aussi bien des informations visuelles qu'auditives. De nos jours, les scientifiques ont de très bonnes raisons de penser que le registre sensoriel est subdivisé en registres indépendants, un par modalité sensorielle. Un registre visuel complémenterait ainsi un registre tactile et un registre auditif. Dans ce qui va suivre, nous allons détailler ces différents registres.

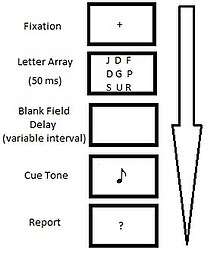

La mémoire sensorielle iconique

[modifier | modifier le wikicode]La mémoire sensorielle visuelle est aussi appelée mémoire iconique (son nom vient d’icône, qui veut dire petite image). Les observations qui ont mené à concevoir ce concept de mémoire iconique sont fondées sur des tâches de mémorisation partielle. La toute première date de 1960, et a été effectuée par George Sperling. Son expérience a nécessité deux groupes de cobayes, qu'il a placé devant un écran d'ordinateur. Les volontaires du premier groupe devaient d'abord fixer une croix sur l'écran afin de fixer la position de leur regard. Ensuite, un tableau de 12 lettres s'affichait à l'écran durant 50 millisecondes, et était suivi par un écran totalement blanc. Une sonnerie retentissait alors quelques instants plus tard, et les cobayes devaient alors se remémorer les lettres qu'ils avaient vues. Durant cette expérience, les cobayes étaient capables de citer seulement trois à cinq lettres, pas plus. Les volontaires du second groupe subissaient la même expérience, à un détail prêt : la sonnerie leur indiquait une des trois lignes. Suivant le ton de la sonnerie, les cobayes devaient se rappeler les lettres situées sur la première, deuxième ou troisième ligne. Le taux de réussite montait à 75 %, et ce quelle que soit la ligne. Ce qui montre que les sujets pouvaient se souvenir du tableau de lettre alors qu'il avait disparu.

|

|

La mémoire iconique a été mise en évidence avec des expériences sur des pilotes de chasse. Dans ces expériences, on projetait sur un écran une image d'avion de chasse durant un temps très faible. En dehors de cette période, l'écran était blanc, pour forcer la persistance rétinienne à effacer l'image de l'avion. Les pilotes de chasse arrivaient tout de même à dire quel était le modèle de l'avion si son image était présenté durant 1/224 de secondes. Difficile d'expliquer ce genre de résultat sans mémoire iconique.

Les expériences citées ci-dessus ont permis, avec quelques modifications, de mieux connaître les caractéristiques de la mémoire iconique. Comme toutes les autres mémoires sensorielles, elle possède deux caractéristiques : sa durée de mémorisation et sa capacité. Pour la capacité, les expériences ne permettent pas de conclure, si ce n'est que celle-ci est énorme. En revanche, sa durée de rétention est mesurée avec précision. Pour cela, les chercheurs ont fait varier l'intervalle entre la présentation du tableau de lettre et la sonnerie. Visiblement, plus le temps augmente, plus le taux de réussite des sujets s'écroule. Une petite analyse semble montrer que la mémoire visuelle devient inefficace au-delà de 100 à 500 millisecondes. C'est approximativement la durée de rétention en mémoire iconique. Bien sûr, cette durée varie selon les personnes. L'âge semble faire varier les résultats, la durée de rétention semblant diminuer un petit peu avec l'âge. Des expériences d'eye-tracking ont montrées que la mémoire iconique était fonctionnelle chez les bébés à partir de 6 mois.

Cette mémoire iconique provient (au moins en grande partie) de la fameuse persistance rétinienne de la rétine, qui permet de maintenir temporairement une image sur la rétine durant un temps limité. Celle-ci vient du fait que les cellules de la rétine mettent un certain temps avant de réagir à un changement de luminosité. Ce temps de réaction des cellules de la rétine fait que l'image perçue sur la rétine va rester durant quelque temps imprimée, et accessible au cerveau. Typiquement, les cellules de la rétine mettent un certain temps avant de détecter des tons plus sombres, alors qu'une augmentation soudaine de la luminosité est prise en compte plus vite. Mais outre la rétine, la mémoire iconique implique aussi le cerveau, dans une certaine mesure. Les aires cérébrales de la vision restent activées suite à la perception de l'image et mettent quelques millisecondes à revenir à la normale. Notons que le cerveau est très sensible aux motifs de l'image, et assez peu à sa luminosité ou son contraste, alors que c'est l'inverse pour la rétine.

La mémoire iconique est utile pour la perception du mouvement. C'est elle qui nous permet de ne pas voir le monde comme une suite de diapositives. D'ailleurs, la durée de la mémoire iconique est similaire à la durée maximale entre deux images au-delà de laquelle on commence à voir les saccades. En somme, cette mémoire iconique sert d'accumulateur, qui mélange les images entre elles, et donne une impression de perception de mouvement.

La mémoire sensorielle échoïque

[modifier | modifier le wikicode]À côté de la mémoire iconique, on trouve la mémoire échoïque, dédiée aux sons (son nom vient de "écho", qui a un rapport avec le "son"). Sa mise en évidence provient des expériences d'écoute dichotiques, qui se basent sur l'écoute simultanée de deux bandes sonores, une dans chaque oreille. Dans ces conditions, les cobayes doivent se concentrer sur une seule bande sonore. Toutefois, si jamais un mot familier (notre prénom, par exemple) est prononcé sur la bande sonore à ne pas écouter, le cobaye s'en rendra compte et son attention se focalisera dessus. C'est la preuve que même si l'attention du sujet n'est pas portée sur la seconde bande sonore, il a quand-même mémorisé les informations de celle-ci, celles-ci pouvant ressurgir suivant la situation. D'où l'existence d'une mémoire échoïque.

Sa durée de rétention est estimée avec les expériences d'écoute dichotique. Pour cela, il suffit de faire varier l'intervalle entre deux présentations d'un mot/chiffre/lettre sur chaque bande. On peut aussi demander à deux cobayes si deux voyelles prononcées consécutivement sont identiques ou différentes. Plus le temps entre la prononciation des deux voyelles est long, plus les cobayes ont du mal à faire la différence. Dans ces conditions, on remarque que la capacité de discrimination diminue pour se stabiliser après quatre secondes de séparation. On voit que la durée est nettement plus importante que pour la mémoire iconique. Cette durée de rétention varie suivant l'âge : elle augmente lors de l'enfance, et finit par se stabiliser assez rapidement vers six ans.

La mémoire à court-terme

[modifier | modifier le wikicode]La mémoire à court-terme, abréviée MCT, est une mémoire qui mémorise un nombre limité d'informations pour une durée de quelques secondes. La différence principale avec la mémoire sensorielle est que sa capacité est limitée, là où la mémoire sensorielle peut mémoriser beaucoup d'informations. De plus, sa durée de rétention est légèrement supérieure à celle de la mémoire sensorielle : des millisecondes, on passe à la dizaine de secondes. Pour donner un exemple, c'est la MCT qui est utilisée pour mémoriser un numéro de téléphone juste avant de le composer.

Une durée de rétention de quelques dizaines de secondes

[modifier | modifier le wikicode]Il est évident que le contenu de la MCT semble s'effacer avec le temps. Pour mesurer cette vitesse d'effacement, les chercheurs doivent tenir compte du fait que le cobaye peut répéter mentalement les informations à mémoriser, augmentant la durée de rétention en MCT. Pour supprimer ce biais, ils utilisent une tâche de Brown-Peterson, dont ils contrôlent la durée. Dans cette situation, plus la durée de la tâche de Brown-Perterson est longue, plus l'empan diminue. Le rappel est d'environ 90 % quand le délai entre les deux est inférieur à 1/2 seconde. Il tombe à 50 % après 3 secondes, 40 % après 6 secondes, 20 % après 9 secondes, et il tombe à 10/8 % après. La durée de conservation semble donc proche de la dizaine de secondes, un peu plus ou un peu moins suivant les personnes. L'origine de cet oubli n'est pas encore bien élucidée et deux théories s'affrontent : une qui dit que les informations s'effacent progressivement, et une autre qui dit que les informations interfèrent entre elles. Nous reviendrons sur ce débat dans le chapitre sur l'oubli en mémoire déclarative.

Une capacité de moins d'une dizaine d'items

[modifier | modifier le wikicode]La mémoire à court terme ne peut pas retenir un nombre illimité d'informations du fait de sa capacité finie. On peut tenter d'estimer la capacité de la MCT en se basant sur l'effet de récence. Puisque la mémoire à court terme est à l'origine du rappel des derniers éléments, on peut en estimer sa capacité en regardant le nombre d’éléments concernés par l'effet de récence. Celui-ci tombe rapidement au-delà d'un certain seuil : ce seuil est appelé l'empan mnésique. Dans les expériences faites sur des adultes, ce nombre ne dépasse pas 10, et a une moyenne de 7 +/- 2.

Pour obtenir une estimation de votre empan mnésique, vous pouvez passer le test suivant, connu sous le nom de digit span task. Lisez chaque séquence de chiffres comme s'il s'agissait d'un numéro de téléphone, fermez les yeux et essayez de répéter celle-ci. Si vous avez réussi à répéter celle-ci sans faute, passez à la séquence suivante. Arrêtez-vous à la première séquence où vous faites une erreur. La capacité de votre empan mnésique est égal à la longueur de la chaîne de chiffres, moins un item.

- 0215 ;

- 4657 ;

- 1857 ;

- 12457 ;

- 07458 ;

- 16895 ;

- 057698 ;

- 014562 ;

- 076931 ;

- 0457289 ;

- 0168345 ;

- 0487965 ;

- 04612785 ;

- 01369874 ;

- 97854631 ;

- 014785236 ;

- 987512346 ;

- 123658749.

La majorité des personnes arrive à atteindre 7 items. Certaines peuvent faire plus et atteindre les 9 à 10 chiffres, tandis que d'autres sont limitées à 4 ou 5 chiffres. Néanmoins, l'empan varie selon l'âge. Dans les 20 premières années de la vie, l'empan augmente progressivement avec l'âge, avant de se stabiliser et de diminuer avec le temps.

Ce test mesure deux choses différentes : la capacité à mémoriser les items et leur ordre. Ce test n'est pas très compliqué pour ce qui est de mémoriser les items eux-mêmes : les chiffres sont des choses bien connues qui ne demandent pas vraiment d'efforts pour être mémorisés. Seule la capacité à mémoriser l'ordre sera donc réellement mesurée dans le test précédent. Cependant, les choses peuvent changer si l'on remplace les chiffres par des items non-familiers.

Un accès séquentiel

[modifier | modifier le wikicode]La mémoire à court terme est une mémoire rapide. Ceci dit, on peut se demander si le temps d'accès à la mémoire dépend de son occupation. Fonctionne-elle séquentiellement ou en parallèle ? Pour vérifier cela, Sternberg a créé une expérience assez simple. Il a demandé à quelques cobayes de mémoriser de petites suites de chiffres, tenant en MCT. Ensuite quelques secondes plus tard, un signal lumineux demandait aux cobayes de répéter à haute voix un des chiffres, la tonalité indiquant la position du chiffre dans la liste. Bilan : tant qu'on reste dans les limites de la MCT, plus la liste est longue, plus le rappel est long. Ainsi, plus la MCT est encombrée, plus le rappel prend de temps. Cela peut laisser penser que la MCT est fondamentalement séquentielle : on peut scanner celle-ci pour se rappeler de son contenu, mais pas y accéder en parallèle.

Un codage des informations essentiellement verbal

[modifier | modifier le wikicode]On peut se demander ce que peut bien contenir la mémoire à court-terme : s'agit-il d'une mémoire acoustique, sémantique, lexicale , ... ? Divers résultats semblent indiquer que la MCT mémorise principalement des informations auditives. Par exemple, on peut citer l'étude de Conrad (1960). Dans cette étude, des sujets devaient lire des suites de lettres et les rappeler immédiatement après (rappel libre). L'étude des erreurs des sujets a alors montré quelque chose d’intéressant. Les suites de lettres sont plus difficiles à mémoriser quand les lettres se prononcent de manière similaire. Par exemple, la suite P D C T G B sera plus difficile à mémoriser que A W Z E T L D. La tâche étant une tache de rappel libre faisant appel à la MCT, on peut en déduire que la MCT mémorise des informations acoustiques, qui peuvent interférer entre elles lors du rappel.

Le phénomène de regroupement/chunking

[modifier | modifier le wikicode]Il faut signaler que les limites de la mémoire à court terme semblent s’évanouir (ou tout du moins fortement augmenter) quand on est face à une situation familière. La raison tient dans la possibilité de regrouper plusieurs items en un seul, dans la mémoire à court-terme. De tels regroupements sont appelés des chunks.

Historiquement, le premier scientifique à avoir découvert cela était Miller, celui qui a découvert que la mémoire à court terme pouvait retenir 7 +- 2 items. Son expérience était simple : il devait retenir un maximum de chiffres binaires, présentés les uns après les autres. Pour information, le binaire est un système d'écriture des nombres qui n'utilise que deux chiffres : 0 et 1. Dans son expérience, il devait retenir une suite de 0 et de 1, dans ce genre : 1011110011010101100000. En travaillant sur des chiffres isolés, il arrivait à retenir 7 chiffres. Néanmoins, il eut l'idée d'utiliser des groupements de deux, trois, ou quatre chiffres binaires. Il pensa alors à interpréter chacun de ces groupes comme un nombre écrit en décimal. Il lui suffisait d'apprendre la correspondance entre groupes de chiffres et nombres, et de l'utiliser pour mémoriser les chiffres.

- 0 = 0000

- 1 = 0001

- 2 = 0010

- 3 = 0011

- 4 = 0100

- 5 = 0101

- 6 = 0110

- ...

Pour vous rendre compte par vous-même de ce phénomène de chunking, essayez de mémoriser le numéro de téléphone suivant, sans regrouper les chiffres :

- 0 3 2 4 5 3 4 6 7 8

Et maintenant essayez en regroupant les chiffres deux à deux :

- 03 24 53 46 78

La seconde suite était plus facile : le fait de regrouper les chiffres fait que le nombre de chunks à mémoriser était plus faible.

Il faut cependant préciser que ce phénomène a été observé pour des informations très différentes, qui dépassent de loin de simples suites de lettres ou de chiffres. Par exemple, quand on présente une configuration de jeu à un joueur d'échec expert, il a tendance à mémoriser 4 à 5 fois plus de pièces qu'un novice. Cela vient du fait que les novices doivent mémoriser des pièces indépendantes, tandis que les experts les regroupent en blocs de 3 à 5 pièces. Mieux : ces regroupements permettent de catégoriser des ensembles de pièces suivant leur sens stratégique, chaque regroupement étant associé au meilleur coup à jouer associée à cette configuration. Ce phénomène de regroupement est aussi utile en géométrie (Koedinger et Anderson, 1990) : les élèves qui ont de bonnes performances en géométrie ont acquis des regroupements visuels qui leur permettent de reconnaître des figures géométriques particulières (triangles, carrés, angles alternes-internes, etc), et d’accéder aux informations associées à ces figures. Ainsi, la capacité à résoudre certains exercices de géométrie dépend en partie de cette capacité à reconnaître des figures, comme des angles alternes-internes, des figures géométriques, et ainsi de suite. On voit que le phénomène de regroupement peut se produire pour des stimulus visuels.

Mieux : certains regroupements sont des regroupements non pas perceptifs, mais conceptuels. Pour donner un exemple, on peut prendre les recherches d'Egan and Schwartz, datées de 1979. Ces expériences comparaient les performances entre des spécialistes en électronique et des novices : les cobayes devaient mémoriser un circuit électronique qui leur était présenté durant quelques secondes. Tandis que les novices se rappelaient de chaque pièce indépendamment, les experts se rappelaient d'ensembles de pièces assez conséquents, chacun de ces ensembles ayant un sens. Par exemple, les experts regroupaient un ensemble de résistances électriques, condensateurs, et bobines dans un sous-circuit qui correspond à un amplificateur de tension ou un amplificateur de courant.

Notons que la capacité à faire des regroupements est dépendante des connaissances antérieures. Par exemple, les expériences de Yntema et Mueser montrent clairement que des contrôleurs aériens experts ne peuvent pas faire de regroupements dans des tâches de laboratoires déconnectées de leur expertise : leur mémoire de travail reste limitée à 7 informations en moyenne. Mais les études de Bisseret montrent que pour des tâches liées à leur domaine d'expertise, les contrôleurs aériens peuvent mémoriser jusqu’à 20 voire 30 informations dans leur mémoire de travail. Cette constatation a été vérifiée dans une grande quantité de domaines différents, comme l'expertise médicale, la programmation, la conception de circuits électronique, ou l'expertise mathématique. Pour reprendre l'exemple des joueurs d'échec experts, leur avantage mnésique ne vaut que pour des configurations de jeu rencontrées fréquemment, ceux-ci ayant des performances similaires à celles des novices pour des configurations de jeu aléatoires.

Pour résumer, les chunks sont des connaissances mémorisées en mémoire à long terme. La recherche dans le domaine de l'expertise a d'ailleurs montré que les performances des experts dans un domaine proviennent en partie de la mémorisation d’un grand nombre de regroupements spécifiques à ce domaine. On observe ce phénomène dans des domaines très divers, mais les premières études sur le sujet étaient celles des experts du jeu d'échecs. Comme le dit Mislevy : « […] comparés aux novices, les experts dominent plus de faits et établissent plus d’interconnexions ou de relations entre eux. Ces interconnexions permettent de surmonter les limitations de la mémoire à court terme. Alors que le novice ne peut travailler qu’avec au maximum sept éléments simples, l’expert travaille avec sept constellations incarnant une multitude de relations entre de nombreux éléments ».

Quelques critiques du modèle

[modifier | modifier le wikicode]Le modèle modal a été l’une des meilleures synthèses qui soient des connaissances sur la mémoire du siècle dernier. Ses hypothèses sont diverses, mais peuvent se résumer simplement : existence de trois mémoires ayant chacune ses caractéristiques, transfert entre registre sensoriel et MCT basé sur l'attention, encodage basé sur le temps de maintien en MCT. Néanmoins, divers pans du modèle ont depuis été remis en cause. L'existence du registre sensoriel et sa subdivision en mémoire iconique et échoïque a remarquablement bien résisté, et fait depuis partie des acquis de la science. Mais les autres hypothèses sont aujourd'hui remises en cause. L'hypothèse de l'existence d'une MCT séparée, ou du moins indépendante de la MLT est aujourd'hui quelque peu réductrice, de même que l'unité de la mémoire à court-terme.

Le processus d'encodage

[modifier | modifier le wikicode]Le modèle modal d'Atkinson et Shiffrin postule que la qualité de l'encodage dépend uniquement du temps passé par l'item en MCT. La répétition mentale, en augmentant le temps passé en MCT par l'item, favorise donc l'encodage. Mais les expériences faites sur le sujet ont montré que la répétition avait non seulement un effet relativement faible, mais aussi que d'autres mécanismes favorisent un encodage de qualité. Dans les grandes lignes, donner du sens aux items, les relier à des connaissances antérieures, ou organiser/classer les items favorise leur encodage. Chose que le modèle modal ne peut pas permettre de rendre compte.

La passivité du stockage en MCT

[modifier | modifier le wikicode]La vision de la MCT comme simple lieu de stockage passif est aussi remise en cause par les résultats d'expériences de double tâche, où un sujet doit traiter simultanément des informations et les mémoriser. Elles montrent que traitement et mémorisation entrent en conflit, une forte charge de traitement diminuant les performances de mémorisation et réciproquement. De nos jours, la mémoire à court-terme est vue non seulement comme une forme de mémoire, mais aussi comme une capacité cognitive plus générale liée à l'attention, indispensable pour des tâches comme le raisonnement, la résolution de problème, ou l'apprentissage. Cette nouvelle forme de mémoire est appelée la mémoire de travail et nous la détaillerons dans le chapitre suivant.

L'unité de la mémoire à court-terme

[modifier | modifier le wikicode]De nos jours, diverses expériences et observations sur des patients cérébrolésés ont montré que la mémoire à court-terme n'est pas une mémoire unique, mais est elle-même subdivisée en plusieurs sous-mémoires indépendantes. Cette hypothèse permet de rendre compte des expériences où les sujets doivent mémoriser à la fois des informations verbales et visuelles. Dans sa première expérience de ce type, Baddeley utilisa plusieurs groupes de cobayes. Ceux-ci devaient mémoriser les informations présentées sur un écran et les rappeler quelques secondes plus tard. Le premier groupe de cobaye ne voyait que des mots sur l'écran, le second des icônes carrées dont il devait prononcer la couleur, et le troisième voyait à la fois icônes et mots et devait prononcer soit les couleurs, soit les mots affichés. Les différents groupes n'avaient pas exactement la même performance à ce test : le groupe 1 est capable de mémoriser environ 4 icônes, le groupe 2 peut mémoriser 7 mots, et le groupe 3 peut rappeler environ 7 mots et 4 icônes. Cette observation ne va pas dans le sens d'une mémoire à court terme unitaire, à capacité limitée fixe.

Ces constatations sont de plus renforcées par les observations sur certains patients cérébrolésés. Certains patients ont une mémoire de travail verbale déficitaire, alors que leur mémoire de travail visuelle est intacte. D'autres ont le déficit inverse. Cette double dissociation montre donc que mémoires de travail verbale et visuelle sont séparées. Les patients dont la mémoire de travail verbale est lésée ont des déficits de l'apprentissage du vocabulaire, ainsi que des déficits d'apprentissage phonologique. On peut citer le cas d'une patiente, étudiée par Baddeley, dont la mémoire de travail phonologique/articulatoire est atteinte à la suite d'un accident vasculaire cérébral. La patiente n'avait aucun problème pour lire des mots familiers ou qui ressemblaient à des mots connus, mais l'apprentissage de nouveaux mots d'une autre langue était laborieux, quand il était seulement possible. On voit donc que l'apprentissage de nouveaux mots dépend de la mémoire de travail auditive, du moins dans les premières étapes de l'apprentissage de la lecture. Par la suite, cette influence diminue, l'élève apprenant de nouveaux mots en les reliant à des mots déjà présents en mémoire à long terme, par analogie.

L'indépendance de la MCT et de la MLT serait un résultat en trompe-l’œil

[modifier | modifier le wikicode]Le modèle des processus emboîtés de Cowan postule que la MCT et la MLT seraient en réalité beaucoup plus liées qu'on ne peut le croire. L'idée du modèle est que la MCT est la portion activée de la MLT. Par activée, on veut dire que les informations en MLT ont un niveau d'activation qui correspond à leur facilité à être rappelée. Plus une information est active, plus elle a de chances de nous venir à l'esprit. Cependant, il ne suffit pas qu'une information soit activée pour qu'elle soit en MCT. Il faut aussi qu'on y fasse attention et qu'on décide de se focaliser dessus. Pour cela, il existe dans le cerveau un superviseur attentionnel, qui gère notre attention, notre concentration et toutes les capacités mentales associées. L'activation, peu importe son origine, pré-sélectionne les informations pouvant entrer dans la MCT, et le superviseur attentionnel s'occupe de la sélection finale. En quelque sorte, la MCT serait le résultat de l'interaction entre notre capacité d'attention et la mémoire à long-terme.

Le modèle de Baddeley

Dans le chapitre précédent, nous avons constaté que le modèle modal de la mémoire a quelques défauts. Nous avons évoqué le fait que la vision de la MCT a largement été amendée depuis, et ce chapitre propose de vous montrer en quoi. De nos jours, la MCT est plutôt vue comme une mémoire de travail, dans le sens où celle-ci n'est pas seulement un lieu de stockage passif, mais un mécanisme mêlant mémorisation et capacités de traitement, les deux interagissant fortement. Pour expliquer son fonctionnement et sa structure, Alan Baddeley et Graham Hitch ont proposé un modèle contenant plusieurs MCT distinctes, qui interagissent et échangent des informations. Dans ce modèle, la mémoire à court terme est scindée en plusieurs sous-systèmes :

- un sous-système verbal : la boucle phonologique ;

- un sous-système visuel : le calepin visuo-spatial ;

- un sous-système indépendant de la modalité sensorielle : le tampon épisodique ;

- et un dernier un sous-système généraliste : le superviseur attentionnel, aussi appelé administrateur central, chargé de gérer les autres sous-mémoires.

L'existence de mémoires séparées se fonde autant sur des arguments expérimentaux que de l'étude de cas cliniques. Nous verrons bientôt les arguments expérimentaux, mais nous allons d'abord évoquer les cas cliniques de dissociations. Quelques patients ayant subi un AVC ou une lésion cérébrale ont une MCT verbale parfaitement conservée couplée avec de lourds déficits de la MCT visuo-spatiale. L'exemple typique est celui du patient KF, étudié par Elisabeth Warrington. Il a un empan mnésique de 2, avec une absence totale d'effet de récence en MCT, qui n’apparaît qu'avec une présentation orale des items et disparaît lorsque les items sont présentés visuellement. Le déficit inverse, à savoir une MCT verbale altérée avec préservation de la MCT visuo-spatiale, existe aussi. Le cas classique est celui du patient LE, un ancien sculpteur aujourd'hui incapable de mémoriser temporairement des informations visuelles. Cependant, il faut signaler que sa capacité à mémoriser des informations spatiales est conservée : il sait se repérer dans son environnement, se déplacer dans des lieux connus, etc. D'autres cas montrent une dégradation de leur mémoire spatiale, alors que leur mémoire visuelle est conservée.

La boucle phonologique

[modifier | modifier le wikicode]La boucle phonologique est une mémoire temporaire verbale, spécialisée dans le stockage et le traitement des informations auditives et la parole. Elle est impliquée dans la lecture, l'écriture, la compréhension orale, le calcul mental, l'apprentissage de la langue maternelle, et des autres langues. Des études ont montré une corrélation entre le développement de la boucle phonologique et développement du langage. De plus, des études faites sur des patients ayant une boucle phonologique atteinte par des lésions cérébrales montrent que ceux-ci ont de fortes difficultés à acquérir le vocabulaire d'un nouveau langage, alors que leur mémoire verbale à long terme n'est pas touchée. La boucle phonologique serait composée de deux sous-systèmes :

- un entrepôt phonologique, une mémoire temporaire verbale de quelques secondes,

- et un système de répétition, chargé de répéter mentalement le contenu de l’entrepôt phonologique.

L'existence de ce système a été postulée pour rendre compte d'expériences sur les listes de mots, chiffres, lettres. À vrai dire, c'est cette mémoire à court terme qui était étudiée dans les expériences mentionnées jusqu'à présent.

L'effet de similarité phonologique

[modifier | modifier le wikicode]Les expériences d'interférences semblent montrer que cet entrepôt phonologique stocke bel et bien des informations verbales. Des mots phonétiquement proches interférent fortement, tandis que des listes de mots proches sémantiquement proches n’interfèrent pas. Pour vous en rendre compte, testez votre empan sur les listes de mots suivantes :

- chat, tas, mât, cas, rat ;

- vidoc, moche, stupide, vieux, long ;

- mot, pro, seau, beau, lin ;

- vide, rance, large, mieux, centre.

Vous remarquerez que les listes 1 et 3 sont plus difficiles que les autres. Il faut dire que les mots qu'elles contiennent se prononcent de la même façon. Du fait de leur prononciation similaires, les mots de la liste interfèrent entre eux, diminuant l'empan. En revanche, ce n'est pas le cas dans les autres listes, dont les mots se prononcent différemment. Cet effet est supposé provenir lors du rappel des informations depuis la mémoire à court-terme. Les informations n’interfèrent pas dans la boucle phonologique, lors de leur stockage. Cependant, le mécanisme de rappel des informations depuis la boucle phonologique n'est pas parfait et a tendance à confondre les informations similaires.

Cependant, cet effet disparaît sous certaines conditions. Premièrement, il disparaît avec des listes de mots très longues, qui dépassent de loin la taille de l'empan mnésique usuel. Ensuite, il disparaît dans les tâches de répétition articulatoire, où les sujets doivent mémoriser une liste de mots, tout en prononçant à voix haute un mot en boucle. Dans de telles conditions, la boucle articulatoire n'est plus utilisée, la mémoire à long-terme prenant la relève.

L'effet de longueur du mot

[modifier | modifier le wikicode]Les séries de mots qui se mémorisent le plus facilement sont celles dont les mots sont courts à prononcer. Dit autrement, l'empan est supérieur pour des mots courts, comparé à des mots plus longs : c'est l'effet de longueur des mots (word length effect). Pour vous en rendre compte, essayez de mémoriser les deux listes suivantes :

- cas, mot, don, mort, stop ;

- éléphant, misérable, médiocrité, anticonformiste, dépravation.

La première est nettement plus facile que la seconde, ses mots étant plus courts et contenant moins de syllabes.

L'effet de la suppression de la répétition subvocale

[modifier | modifier le wikicode]Pour vérifier que la boucle phonologique est bien impliquée dans l'effet précédent, il suffit d’empêcher le cobaye de répéter mentalement les mots qui lui sont donnés. Pour cela, on ajoute une tâche de Brown-Peterson entre chaque mot. L'effet de la longueur du mot disparaît : les mots longs sont alors aussi bien rappelés que les mots courts. Pour estimer la durée de ce processus de répétition subvocale, on peut essayer de se fonder sur la longueur à partir de laquelle un mot commence à être difficilement mémorisable. Cette longueur dépend des personnes, qui peuvent lire ou parler plus ou moins vite. Mais dans tous les cas, le taux de mémorisation chute brutalement pour les mots qui mettent plus de deux secondes à prononcer.

Ensuite, d'autres expériences ont testé la suppression de la répétition à haute voix. Il apparaît que l'on mémorise mieux les listes de mots quand elles sont prononcées à haute voix que silencieusement. De même, on observe un phénomène d'interférence avec la parole. Si, juste après chaque présentation d'un mot, on demande aux cobayes de prononcer un autre mot que celui à mémoriser à haute voix, la mémorisation dans la boucle phonologique est alors fortement affectée, et devient inférieure à celle obtenue avec une tâche de Brown-Peterson.

L'effet des sons distracteurs

[modifier | modifier le wikicode]Enfin, on peut mentionner les expériences faisant appel à des sons distracteurs. Dans ces expériences, les sujets doivent mémoriser une liste écrite de mots/chiffres. Ceux-ci sont présentés en même temps qu'un son (un bruit blanc ou un mot d'une langue étrangère), que les sujets doivent ignorer. Un exemple de ce type d'étude est celle de Colle et Welsh (1976), dont les résultats ne s'expliquent correctement qu'avec un système de répétition articulatoire. Dans cette étude, les mots présentés en même temps qu'un bruit blanc sont mémorisés avec des performances identiques à celle d'un groupe contrôle. En revanche, les mots présentés en même temps que de la parole sont nettement moins bien mémorisés. L'explication est que le système de répétition articulatoire est utilisé pour traduire l'écrit en oral, transduction perturbée par les distracteurs verbaux.

Le calepin visuo-spatial

[modifier | modifier le wikicode]Outre nos capacités verbales, le cerveau gère aussi des images mentales, ses capacités d'imagerie étant impressionnantes. Autant dire que l'existence d'une mémoire de travail visuelle, où les informations sont encodées par des images mentales, n'est pas étonnante. Elle se nomme le calepin visuo-spatial.

Un codage visuel

[modifier | modifier le wikicode]Pour prouver l'existence d'un tel codage visuel, les chercheurs ont utilisé des expériences de parcours mental. On fait mémoriser aux cobayes la carte d'une île contenant un lac, une hutte et un rocher. On leur demande de parcourir mentalement le chemin qui mène de la hutte au rocher, ou tout autre endroit de l’île. Le temps mis par les cobayes pour faire cette traversée est proportionnel à la distance du trajet : le trajet s'effectue toujours à la même vitesse. D'autres expériences utilisées sont les expériences de rotation mentale. Dans ces expériences, on montre deux formes géométriques à des cobayes, et on leur demande de vérifier si ces deux formes sont différentes, ou s'il s'agit de la même forme présentée sous un angle différent. Pour faire cette vérification, le cobaye va devoir faire tourner mentalement l'objet, et appuyer sur un bouton poussoir quand il a fini. Statistiquement, le temps mis pour faire la rotation est presque proportionnel à l'angle de rotation.

Une autre expérience, réalisée par Shepard et Feng, a montré une autre forme de traitement visuo-spatial dans la mémoire de travail. Dans leur étude, les chercheurs présentaient des figures qui ressemblaient à des patrons de cube à leurs sujets. Certaines faces avaient des flèches dessinées dessus et les sujets devaient dire si les deux flèches se rencontraient tête contre tête quand on pliait le patron. Certaines figures demandaient un simple pliage, tandis que d'autres en demandaient plusieurs pour réussir la tâche. Il s'est avéré que le temps de réponse des sujets était proportionnel au nombre de plis à effectuer, preuve que les sujets utilisaient une représentation visuelle pour résoudre le problème.

Une capacité limitée à quelques items

[modifier | modifier le wikicode]L'étude de la capacité de la MDT visuelle se fonde sur des expériences dites de détection de changement. On présente une image au sujet durant un certain temps, suivie par une seconde image après quelques secondes de noir entre les deux. Le sujet doit dire si les deux images présentées sont identiques ou non. Le sujet doit catégoriser ainsi une succession de paires d'images, certaines paires ayant des images identiques, d'autres des images différentes. Pour donner un exemple, on peut prendre l'étude de Phillips, datée de 1974. Les sujets de cette étude se voyaient présenter des plateaux d'échec de complexité variable : de 4 * 4 cases pour les plus simples à 8 * 8 cases pour les plus complexes. Les délais de présentation entre les deux plateaux variaient entre 0 et 9 secondes. Il se trouve que dans cette expérience (et dans toutes les autres du même type), les performances diminuaient avec le délai inter-image. D'une détection quasi-parfaite avec un délai inférieur à la seconde, les performances chutaient au-delà. Cela suggère que la MDT visuelle a une capacité limitée.

L'ensemble des expériences de ce type semble indiquer une capacité proche de 3 à 4 items. Pour donner un exemple de ces expériences, qui visent à mesurer précisément la capacité de la MDT visuelle, on peut citer l'étude de Luck et Vogel (1997). Dans celle-ci, on présentait des images contenant des carrés colorés aux sujets. Là encore, les sujets devaient détecter un changement dans la couleur des carrés, ou dans leur position. En augmentant le nombres de carrés, la performance suivait un motif assez simple : la performance décline doucement à moins de 4 carrés, mais devient abrupte pour de courtes durées au-delà.

Le calepin est subdivisé en deux sous-systèmes

[modifier | modifier le wikicode]Certains psychologues pensent que ce calepin est lui aussi composé de plusieurs sous-systèmes. Un pour mémoriser les couleurs et caractéristiques visuelles d'un objet, et un autre pour mémoriser la position de l'objet sur le champ de vision. D'un côté, le cache visuel spécialisé dans les formes et les couleurs, et de l'autre, l'inner scribe pour la localisation et la vitesse des objets. Ce découpage est cohérent avec le fait que ces deux informations sont gérées par des zones du cerveau séparées : une voie ventrale pour la reconnaissance des formes, et une voie dorsale pour la position des objets. Cela se voit sur les IRM : les zones du cerveau activées ne sont pas les mêmes. De plus, certaines lésions cérébrales empêchent la reconnaissance des formes, mais pas leur localisation dans le champ de vision, et réciproquement. Là encore, certains patients ayant une lésion cérébrale particulière sont capables de retenir des informations spatiales en MCT, mais pas des informations visuelles, et réciproquement.

Le tampon épisodique

[modifier | modifier le wikicode]Si l'on soumet des cobayes à des tâches demandant de retenir des listes de mots, l'ajout d'une tâche de Brown-Peterson ou l'utilisation d'une tâche de suppression articulatoire va supprimer les phénomènes d'interférences phonétiques. Cependant, on voit apparaître des interférences sémantiques : plus les mots appartiennent à la même catégorie ou sont proches sémantiquement, plus le taux de rappel est mauvais. Cette observation peut être attribuée à l'existence d'une mémoire à long-terme dans une certaine mesure, mais sans être vraiment compatible avec le modèle précédent. D'autres observations ne peuvent s'expliquer simplement avec le modèle précédent. De plus, dans les tâches de répétition articulatoire, les cobayes arrivent tout de même à retenir quelques mots en mémoire à court terme. De même, la taille de cet empan est différente de la taille de la boucle phonologique : les cobayes retiennent environ 4 items, au lieu des 7 que la boucle phonologique peut permettre. Enfin, les expériences d'apprentissage de listes de mots et de phrases donnent des empans totalement différents : de 5 à 6 mots dans une liste de mots à 15 à 20 mots pour l'apprentissage d'une phrase. Une telle capacité dépasse de loin celle de la boucle phonologique verbale et du calepin visuo-spatial.

Finalement, quand on lit un texte, qu'on réfléchit, ou qu'on cherche à résoudre un problème, il est évident que notre mémoire de travail est mise à contribution. Néanmoins, les données sur lesquelles on travaille ne sont ni des images, ni des données verbales : ce sont des concepts, des informations qui ont une signification. Dans ces conditions, le calepin visuo-spatial et la boucle phonologique ne peuvent pas servir à stocker ces concepts. Pour gérer les éléments porteurs de signification, la mémoire de travail doit fatalement contenir un sous-composant, en plus de la boucle phonologique et du calepin visuo-spatial.

Rendre compte de ces observations demande de postuler une nouvelle forme de mémoire. Pour cela, le modèle de la mémoire de travail a été adapté dans les années 2000, par ses auteurs, pour rajouter une autre MCT contenant des informations épisodiques ou sémantiques. Cette MCT s'appelle le tampon épisodique, ou encore l'executive buffer. Il est supposé que cette mémoire serait en lien direct avec la mémoire à long terme. Ce tampon épisodique aurait une capacité de quatre items maximum, capacité qui serait cependant influencée par le phénomène de morcelage, qui aurait lieu dans cette mémoire. Il est aussi supposé que les informations dans ce tampon seraient autant visuelles que verbales ou conceptuelles. Le tampon permettrait de lier entre elles ces représentations afin de former des morceaux cohérents.

Le superviseur attentionnel

[modifier | modifier le wikicode]Les composants précédents sont des "sous-mémoires" distinctes, dédiées à des formes d'informations spécialisées. Ces mémoires suffiraient pour rendre compte des expériences qui considèrent la mémoire comme un processus purement passif. Mais la vision actuelle de la mémoire de travail est que celle-ci est un dispositif de traitement de l'information plus que de stockage passif. Cette vision implique fatalement un système de contrôle, non-mnésique, dans la mémoire de travail. Ce système de contrôle est un système attentionnel, qui se charge de l'allocation de l'attention dans les différentes sous-mémoires vues précédemment. De par sa nature attentionnelle et son rôle de contrôle, celui-ci est appelé le superviseur attentionnel.

Les tâches d’empan complexe

[modifier | modifier le wikicode]L'existence de ce superviseur attentionnel est utile pour rendre compte des résultats dans les expériences d'empan complexe. Les expériences du chapitre précédent étaient relativement simples : il s'agit d'expériences d'empans basiques, qui n'impliquent que la mémorisation d'items. Pour mieux évaluer la capacité et le fonctionnement de la mémoire à court terme, les psychologues ont créé des tâches d'empan complexes, où l'on introduit une tâche de traitement entre chaque item à retenir. Par exemple, on peut demander à un cobaye d'effectuer un calcul mental entre chaque mot d'une liste.

La mesure la plus simple de l'empan complexe consiste à intercaler des calculs entre paires de mots.

- Château | 4 * 70 | Martien

- Combat | 25 * 15 | Nul

- Fin | 12 * 41 | Discriminatoire

- ...

D'autres épreuves demandent de mémoriser des résultats de traitements mentaux. Par exemple, faites les calculs suivants, et essayez de les mémoriser :

- 4 * 70

- 25 * 15

- 12 * 46

- 49 * 73

- 13 * 40

- 76 * 16

- 44 * 22

- 79 * 46

Ces expériences montrent clairement que la mémorisation est bien plus difficile quand elle est effectuée avec des traitements intercalés. Ces tâches font intervenir le superviseur attentionnel, et montrent clairement que celui-ci a une forte importance dans la gestion des sous-systèmes de la mémoire à court terme.

La répartition entre traitement et mémorisation

[modifier | modifier le wikicode]Pour décrire les résultats des expériences d'empan complexe, divers modèles ont été créés. Le plus abouti à l'heure actuelle est le modèle TBRS (Time Based Resource Sharing), créé par des chercheurs français (Barrouillet, Bernardin et Camos, 2004). Ce modèle se fonde sur quatre axiomes de base.

- Premièrement, les tâches d'empan complexes utilisent l'attention pour maintenir et traiter les informations en mémoire de travail. Les items à retenir s'effacent avec le temps, mais il est possible de contrer cet effacement progressif est de rafraîchir les items. Ce rafraîchissement n'a rien à voir avec la répétition articulatoire de la boucle phonologique, mais est en réalité un processus de répétition séparé, capable d'intervenir dans toutes les mémoires à court terme. Il s'agit d'un mécanisme qui consomme de l’attention et est donc le fait du superviseur attentionnel. Pour résumer, l'attention sert justement à rafraîchir les informations en MCT, afin de contrer leur oubli.

- Deuxièmement, les traitements et le rafraîchissement des informations s'effectuent les uns après les autres : l'attention est focalisée sur un objet à la fois. La mémoire de travail utilise traitements et rafraîchissement de manière séquentielle. L'administrateur central va ainsi constamment basculer entre traitements et rafraîchissement, rafraîchissant et traitant les morceaux les uns après les autres en mémoire de travail.

- Troisièmement, l'attention est disponible en quantité limitée, et ne peut traiter ou rafraîchir qu'un seul morceaux à la fois. Cette capacité à ne pouvoir maintenir qu'une quantité limitée de morceaux sous le feu de l'attention fait que l'on parle de focus attentionnel : on peut focaliser son attention sur un morceau en particulier.

- Et enfin, quand l'attention n'est pas portée sur un objet, que ce soit pour rafraîchissement ou pour traitement, celui-ci se désactive progressivement et finit par être oublié s'il n'est pas rafraîchi par le focus attentionnel.

Sur une tâche qui dure un temps limité, une partie de la durée de la tâche sera dédiée aux traitements, et une autre partie servira pour le rafraîchissement. La difficulté de mémorisation ne dépend alors pas tellement du nombre d'informations qu'il faut mémoriser, mais surtout du pourcentage de temps passé à faire les traitements. Plus les traitements prennent de temps, plus le temps disponible pour rafraîchir les autres regroupements en mémoire de travail sera faible : cela peut empêcher de rafraîchir à temps les morceaux en dehors du focus attentionnel.

Le fonctionnement supposé du superviseur attentionnel

[modifier | modifier le wikicode]Le fonctionnement de ce superviseur est basé sur l'attention, la capacité de concentration. Ce superviseur contiendrait une certaine quantité finie d'attention, qu'il pourrait utiliser pour diverses choses. Tout le travail du superviseur attentionnel demande de répartir l'attention dans les diverses tâches qui lui sont confiées. Si cette répartition est mal faite, les performances s'en ressentent. Une modélisation complète du superviseur attentionnel a été réalisée par Norman et Shallice, modèle considéré comme cardinal par Baddeley. Ce modèle part des acquis de la psychologie cognitive, qui distingue des comportements contrôlés des comportements automatiques.

Les comportements automatiques sont des comportements habituels, appris et acquis avec l’entraînement, la répétition ou l'habitude. Ces comportements sont mémorisés en mémoire à long-terme, sous la forme de ce que les psychologues appellent des schémas. Ces derniers sont des ensembles unifiés d'actions et de pensées reliés entre eux qui permettent d'appliquer une procédure, une méthode ou une routine. Ceux-ci sont activés automatiquement par la perception ou la pensée, cette activation permettant à ceux-ci de s'"exécuter". Lorsque plusieurs schémas s'activent en même temps, un dispositif de contention sélectionne le bon schéma à appliquer. Lors de cette étape de contention, chaque schéma va tenter d'inhiber les schémas concurrents, seul le plus activé restant activé suite à cette étape.

Cependant, quand les schémas activés ne permettent pas de répondre aux exigences de la situation, le superviseur attentionnel prend la relève. Le processus de pensée quitte alors le domaine de la pensée automatique et tombe dans le registre de la pensée contrôlée : le superviseur utilise les ressources cognitives comme la mémoire de travail pour trouver une solution. Ces processus contrôlés sont assez stratégiques, basés sur des algorithmes, des méthodes générales de résolution de problèmes. Ce superviseur a un rôle de contrôle des schémas, que ce soit pour désactiver les schémas inadaptés (rôle d'inhibition) ou pour en créer de nouveaux (rôle dans l'apprentissage).

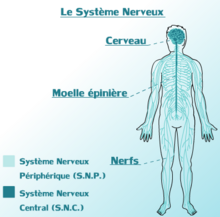

La subdivision de la mémoire à long-terme

Dans les chapitres précédents, nous avons considéré la mémoire à long terme (MLT) comme une entité unique. C'était une hypothèse secondaire du modèle d'Atkinson et Shiffrin, qui visait à simplifier le modèle et qui paraissait crédible pour l'époque. Mais les connaissances scientifiques actuelles nous disent qu'il existe deux systèmes de mémoire : un système pour les souvenirs et connaissances, et un autre pour les automatismes moteurs, cognitifs et sensoriels. La terminologie utilisée pour nommer ces deux systèmes de mémoire est assez simple, même si il y a deux acceptations distinctes. La première terminologie distingue la mémoire déclarative de la mémoire non déclarative. La mémoire déclarative correspond à la mémoire dont on peut verbaliser le contenu, alors que la mémoire non-déclarative comprend des apprentissages qu'on ne peut pas mettre en mots. Pour faire simple, il s'agit d'une distinction entre une mémoire verbale, liée au langage, d'une mémoire non-verbale indépendante du langage. La seconde terminologie distingue une mémoire explicite d'une mémoire implicite. La différence entre les deux tient dans le fait que l'apprentissage soit conscient ou non. Ce qui est appris en mémoire explicite l'est de manière consciente, alors que la mémoire implicite est celle des apprentissages inconscients (apprentissage perceptifs ou moteurs). Concrètement, les deux distinctions sont identiques : mémoire explicite et déclarative sont deux termes interchangeables, de même que mémoire implicite et non-déclarative.

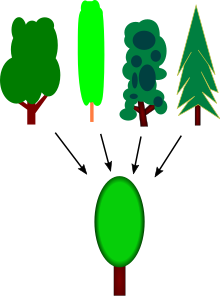

Il est apparu que mémoire déclarative et implicite sont elles-mêmes subdivisées en mémoires séparées. Le découpage est encore mal connu, surtout pour la mémoire implicite et toutes les classifications ne sont pas d'accord. Pour la mémoire déclarative, le consensus actuel est qu'elle est séparée en deux : une mémoire sémantique pour les connaissances (conceptuelles ou factuelles) et une mémoire épisodique pour les souvenirs. Pour ce qui est de la mémoire implicite, les choses sont plus compliquées et le consensus plus complexe. Ce qui ne fait pas débat est la présence de quatre sous-systèmes distincts : une mémoire procédurale pour les automatismes moteurs et cognitifs, la mémoire liée au processus d’amorçage dont on parlera dans quelques chapitres, le conditionnement classique et des apprentissages non-associatifs qui sont des apprentissages archaïques associés à certains réflexes. On sait aujourd'hui que chaque type de mémoire est pris en charge par des zones du cerveau totalement différentes.

Les preuves de l'existence de deux systèmes de mémoire séparés

[modifier | modifier le wikicode]La subdivision de la MLT en une mémoire explicite et une mémoire implicite ne sort pas de nulle part. De nombreuses observations ne peuvent s'expliquer que si on fait l'hypothèse de l'existence de deux systèmes mnésiques séparés. L'hypothèse a d'abord été formée suite à l'observation de patients profondément amnésiques qui avaient gardé une capacité d'apprentissage résiduelle bien particulière, qu'on détaillera plus bas. De là, d'autres expériences ont tenté de vérifier cette hypothèse, en soumettant des sujets à diverses épreuves, certaines ne mettant en œuvre que la mémoire explicite et d'autres que la mémoire implicite. Dans cette section, nous allons rapidement parler des indices en faveur de l'existence de deux systèmes de mémoire séparés.

L’observation des patients amnésiques

[modifier | modifier le wikicode]L'observation de patients avec des lésions au cerveau est riche d'enseignements pour ceux qui étudient la cognition et la mémoire humaine. Les cas les plus spectaculaires, mais aussi les plus intéressants pour en apprendre plus sur la mémoire, sont ceux des amnésiques qui ont perdu toute possibilité de former des souvenirs ou d’apprendre des faits suite à une lésion cérébrale.

Le cas le plus connu est celui du patient H.M, un patient dont l'observation a révolutionné les neurosciences et les conceptions sur le fonctionnement de la mémoire. Pour soigner ses graves crises d'épilepsies, ce patient s'est fait retirer une partie de son cerveau. L'opération a retiré une partie de son hippocampe, du lobe temporal médian, et quelques aires cérébrales annexes. Le patient s'est remis de cette opération particulièrement lourde, ses crises d'épilepsies avaient grandement diminuées, mais au prix de séquelles permanente assez spectaculaires. Ses capacités intellectuelles et sa mémoire de travail étaient parfaitement conservées. Sa mémoire antérieure était intacte, il se souvenait de toute sa vie avant son opération, il n'avait pas d'amnésie au sens commun du terme. Cependant, le patient avait perdu toute possibilité de former de nouveaux souvenirs ou d'apprendre des connaissances. Concrètement, il était incapable de mémoriser un visage, de reconnaître les médecins qui le soignaient depuis des années, ne pouvait se souvenir de sa nouvelle adresse ni reconnaître les lieux alentours, etc.

Sa mémoire était littéralement celle d'un poisson rouge et il oubliait tout après quelques secondes. Concrètement, si un médecin lui parlait, il pouvait tenir une conversation avec lui sans trop de problèmes durant un court moment, preuve que sa mémoire de travail était conservée. Mais il suffisait que le médecin quitte la pièce pour y revenir pour que le patient oublie totalement avoir déjà vu le médecin et encore plus lui avoir déjà parlé. D'ailleurs, le patient pensa durant le reste de sa vie être dans la même année que celle de son opération. L'interprétation de son amnésie dans le modèle d'Atkinson et Shiffrin est relativement simple : la MCT et la MLT étant déconnectées, l'encodage en MLT est impossible chez ces patients (le transfert des informations ne pouvant aller que de la MCT vers la MLT).

Si H.M avait perdu la capacité de former de nouveaux souvenirs, ainsi que d'apprendre de nouvelles connaissances, il gardait une certaine capacité à mémoriser bien particulière. Sa capacité à apprendre des mouvements ou des séquences motrices était parfaitement conservée. Il a par exemple appris à dessiner une figure présentée à l'envers, par l'intermédiaire d'un miroir, de façon à ce que le dessin soit dans le bon sens. Il a aussi appris à lire un texte en miroir, suite à plusieurs séances d’entraînement. Dans un tout autre genre, H.M a aussi appris la procédure pour résoudre le problème des tours de Hanoï progressivement, par essai et erreurs. Il a été soumis plusieurs jours de suite à ce problème et ses performances augmentaient à chaque essai. Et cela sans que H.M garde le moindre souvenir des séances d'apprentissage : à chaque nouvelle séance, il disait n’avoir jamais eu affaire à ce problème des tours de Hanoï. En clair : il gardait la capacité à apprendre non pas des connaissances, mais des automatismes moteurs et cognitifs. Ces apprentissages avaient lieu sans conscience d'avoir appris quelque chose et s'exprimaient par une amélioration progressive de la performance dans certaines tâches bien précises, suite à des entraînements à base de nombreuses répétitions régulières.